多模态大语言模型研究进展综述

多模态大语言模型研究进展综述

近年来,随着大语言模型(LLM)技术的快速发展,基于LLM的多模态学习成为了人工智能领域的研究热点。本文对LLM引导的多模态学习的最新研究进展进行了全面的综述。

1. 多模态大语言模型概述

多模态大语言模型(MLLM)是指能够处理文本、图像、视频等多种模态输入的大规模语言模型。与传统的多模态方法相比,MLLM具有更强的通用性和涌现能力,能够完成诸如根据图像写故事、进行OCR无关的数学推理等任务。

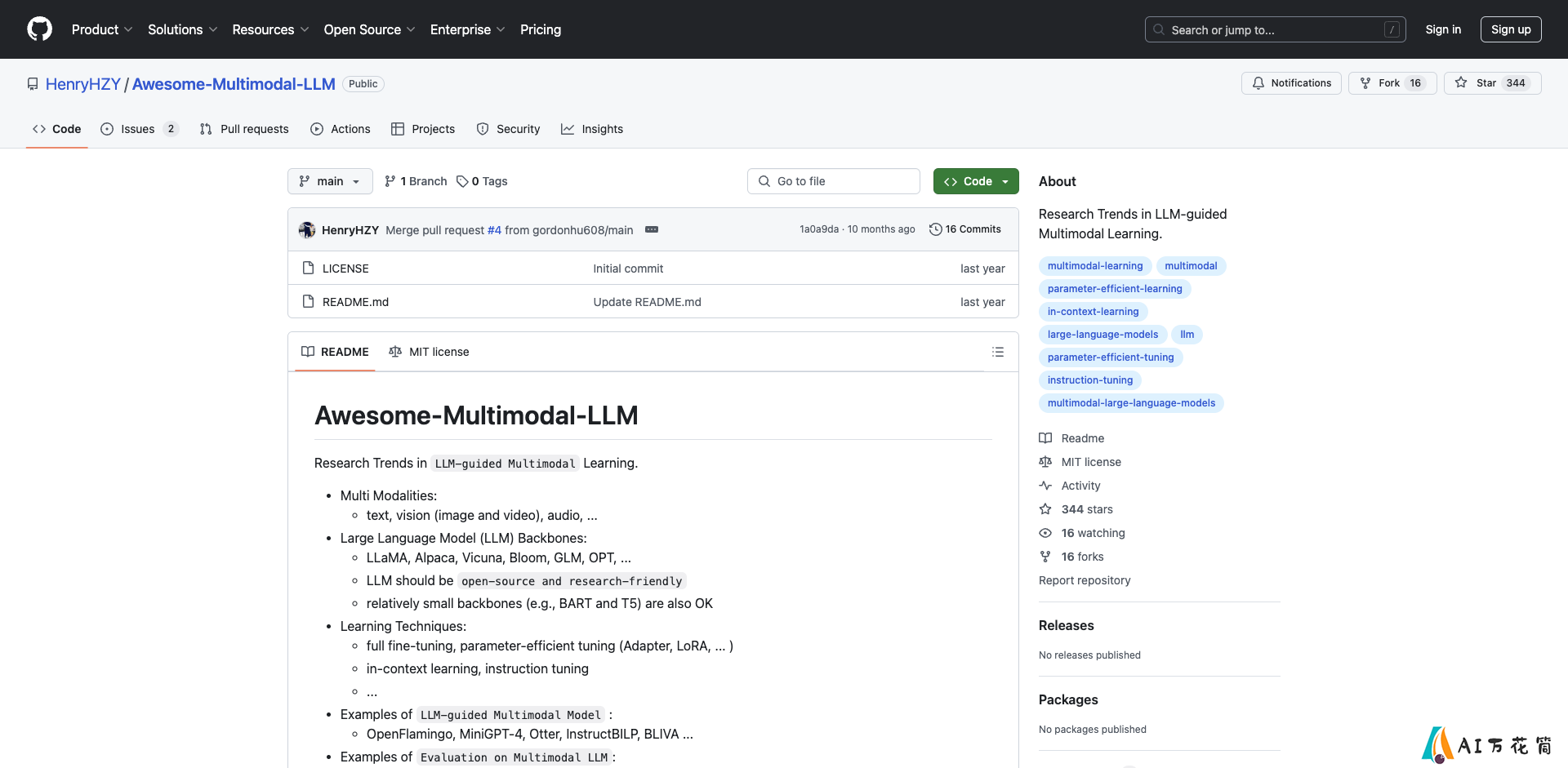

典型的MLLM架构包括:

大语言模型主干网络:如LLaMA、Alpaca、Vicuna等视觉编码器:如CLIP、ViT等多模态融合模块2. 模型架构与训练策略

当前主流的MLLM架构可以分为以下几类:

端到端训练:如GPT-4、PaLM-E等,将视觉和语言模型联合训练。视觉编码器+LLM微调:如LLaVA、MiniGPT-4等,冻结预训练的视觉编码器,仅微调LLM。参数高效微调:如LLaMA-Adapter等,仅微调少量参数实现多模态能力。常用的训练策略包括:

指令微调上下文学习思维链推理多任务学习3. 应用场景

MLLM在以下领域展现出了广阔的应用前景:

视觉问答与对话图像/视频描述生成视觉推理多模态任务规划跨模态检索与生成4. 评测与分析

对MLLM的评测主要包括以下方面:

视觉-语言理解能力多模态推理能力幻觉问题鲁棒性与对抗攻击公平性与偏见5. 挑战与展望

当前MLLM仍面临以下挑战:

模型规模与计算资源幻觉与事实一致性多模态对齐与融合隐私与安全问题可解释性未来的研究方向包括:

更高效的训练方法更强大的视觉-语言对齐结合知识图谱增强推理能力多语言多模态模型实现真正的通用人工智能总的来说,MLLM作为通向通用人工智能的重要一步,具有巨大的发展潜力。随着研究的不断深入,相信MLLM将在更多领域发挥重要作用,推动人工智能技术的进步。

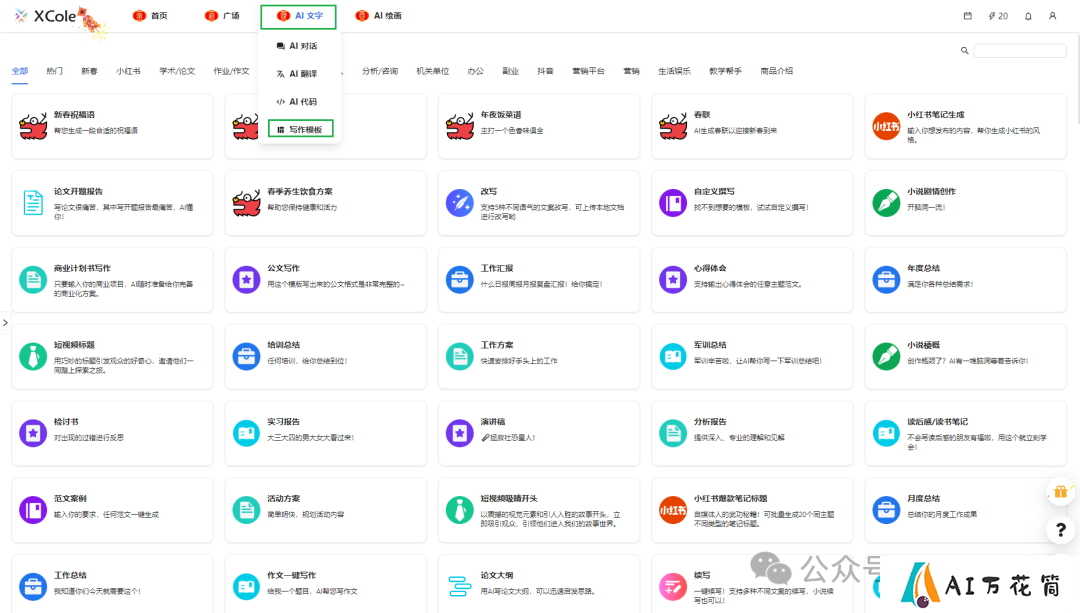

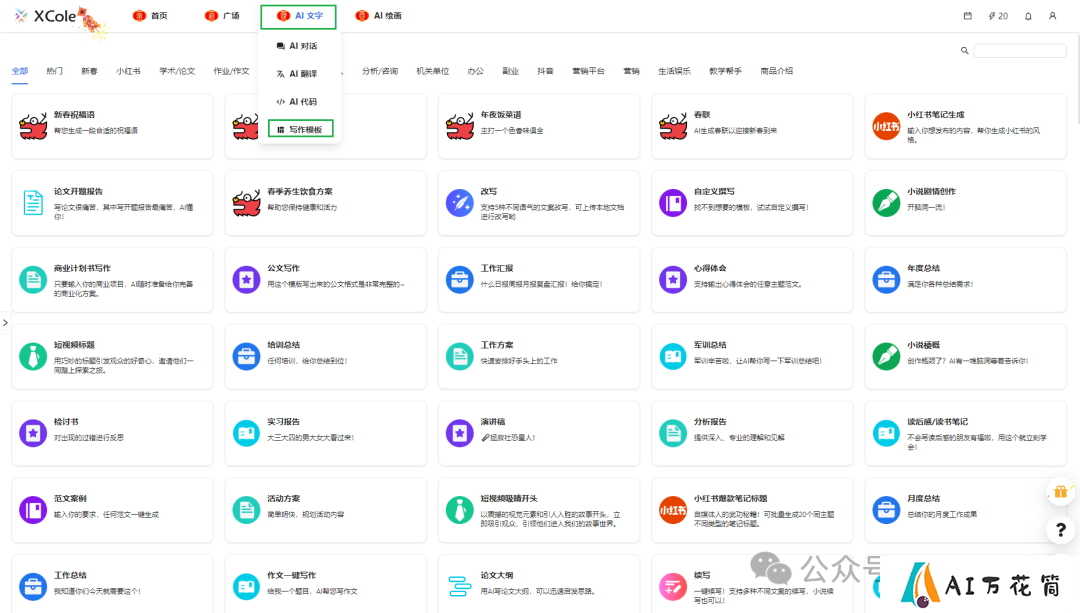

图1: 典型的多模态大语言模型架构

参考资料

[1] Liu, H., Li, C., Wu, Q., & Lee, Y. J. (2023). Visual instruction tuning. arXiv preprint arXiv:2304.08485.

[2] Li, J., Li, D., Savarese, S., & Hoi, S. (2023). BLIP-2: Bootstrapping language-image pre-training with frozen image encoders and large language models. arXiv preprint arXiv:2301.12597.

[3] Zhu, D., Chen, J., Shen, X., Li, X., & Elhoseiny, M. (2023). MiniGPT-4: Enhancing vision-language understanding with advanced large language models. arXiv preprint arXiv:2304.10592.

-

下一篇: 最后一页

-

2025-04-29

-

Awesome Chinese Stable Diffusion 中文文生图模型综述

2025-05-03

-

wcplusPro:一款专业的微信公众号数据采集、管理和分析工具

2025-05-02

-

NSFW Filter: 一款免费开源的浏览器扩展程序,让网上冲浪更安全

2025-05-04

-

2025-04-30

-

IceCubesApp: 高效轻量的开源 SwiftUI Mastodon 客户端

2025-05-03

-

awesome-llm-webapps: 开源LLM网络应用集合

2025-05-02

-

2025-05-04

-

-

2025-05-03

-

- 1Awesome Chinese Stable Diffusion 中文文生图模型综述

- 2wcplusPro:一款专业的微信公众号数据采集、管理和分析工具

- 3NSFW Filter: 一款免费开源的浏览器扩展程序,让网上冲浪更安全

- 4分享7款真正免费的在线视频去水印网站

- 5IceCubesApp: 高效轻量的开源 SwiftUI Mastodon 客户端

- 6awesome-llm-webapps: 开源LLM网络应用集合

- 7千言万象:轻松打造小红书爆款笔记-入门指南篇

- 8Serverless-Qrcode-Hub:生成永久二维码,解决微信群聊二维码频繁变动的问题

- 9中国大语言模型发展现状与趋势分析