Lagent:构建基于大语言模型的智能代理的轻量级开源框架

Lagent:让构建LLM智能代理变得简单高效

在人工智能快速发展的今天,大语言模型(LLM)正在改变我们与计算机交互的方式。如何高效地利用LLM的能力,构建智能代理(Agent)成为了一个热门话题。InternLM团队开源的Lagent框架,为开发者提供了一个轻量级、易用性强的解决方案。

Lagent框架概述

Lagent是一个用Python开发的开源框架,旨在帮助用户高效地构建基于大语言模型的智能代理。它具有以下主要特点:

统一的接口设计:无论是使用OpenAI API、Hugging Face的Transformers还是LMDeploy推理加速框架,都可以通过统一的接口进行切换。

流式输出:提供stream_chat接口支持流式输出,让本地演示更加酷炫。

高度可扩展:通过简单的继承和装饰,用户可以创建自己的工具集,适用于InternLM和GPT等不同模型。

文档完善:提供全面的API文档,方便用户快速上手。

快速上手Lagent

要开始使用Lagent,首先需要通过pip安装:

pip install lagent安装完成后,可以运行一个简单的Web演示来体验Lagent的功能:

pip install streamlitstreamlit run examples/internlm2_agent_web_demo.py这将启动一个基于Streamlit的Web界面,让用户可以与基于InternLM2模型构建的智能代理进行交互。

Lagent的核心组件

Lagent框架主要包含以下几个核心组件:

Model:负责与不同的语言模型进行交互,支持OpenAI API、Transformers和LMDeploy等多种接口。

Action:定义了智能代理可以执行的各种操作,用户可以通过继承基类来自定义新的操作。

Agent:将Model和Action组合起来,形成一个完整的智能代理系统。

通过这种模块化的设计,Lagent使得构建和定制智能代理变得非常灵活和高效。

应用场景与案例

Lagent可以应用于多种场景,例如:

智能客服:利用LLM的对话能力,结合自定义的业务逻辑,构建智能客服系统。代码助手:集成代码分析工具,帮助开发者进行代码审查、bug修复等任务。数据分析:结合数据处理和可视化工具,实现智能化的数据分析流程。

社区与生态

Lagent是一个开源项目,欢迎社区贡献。目前,该项目在GitHub上已经获得了超过1.7k的星标,有170多个分支。开发团队非常重视社区反馈,并积极响应issues和pull requests。

如果你对Lagent感兴趣,可以通过以下方式参与:

在GitHub仓库上给项目点星、提issue或提交PR加入Discord社区与其他开发者交流关注@intern_lmTwitter账号获取最新动态未来展望

随着大语言模型技术的不断进步,Lagent也在持续演进。未来,我们可以期待:

支持更多的LLM模型和推理框架提供更丰富的预置工具和Action改进Agent的推理能力,实现更复杂的多步骤任务优化性能,支持更大规模的应用部署结语

Lagent为构建基于LLM的智能代理提供了一个简单而强大的框架。无论你是AI研究人员、软件开发者还是产品经理,Lagent都能帮助你快速将LLM的能力转化为实际应用。随着更多开发者的加入和贡献,相信Lagent会在LLM应用开发领域发挥越来越重要的作用。

如果你对构建智能代理感兴趣,不妨从今天开始尝试Lagent,探索LLM应用的无限可能!

-

下一篇: 最后一页

-

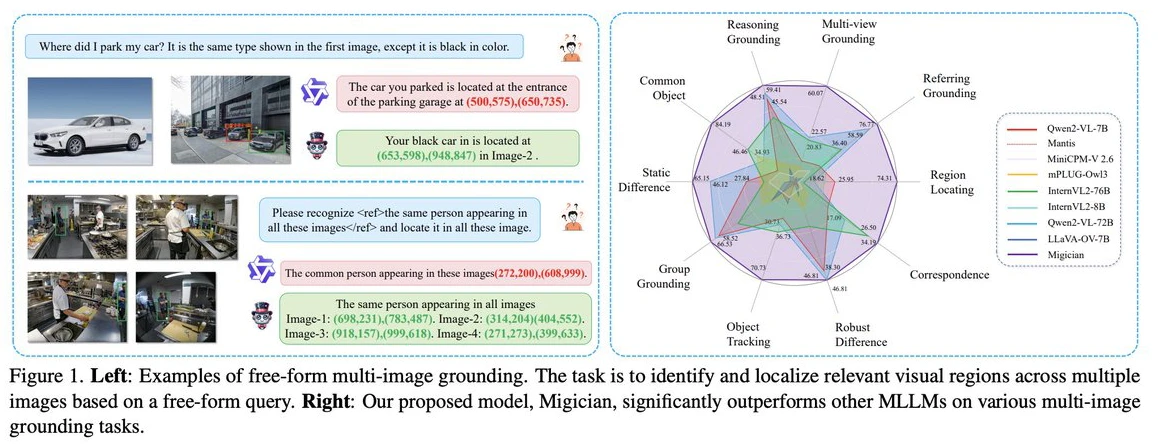

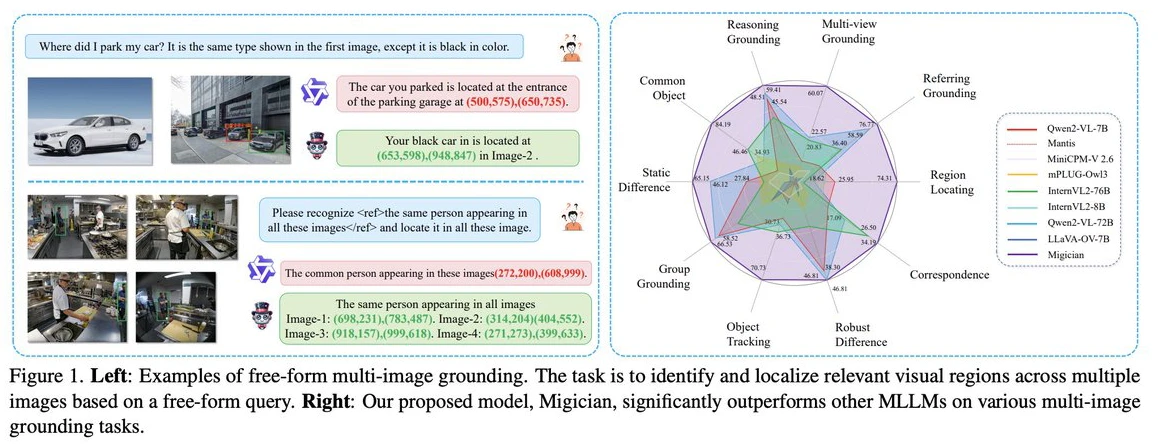

Migician:清华大学等团队出的解决复杂场景下的多图像目标定位问题的多模态模型

2025-03-11

-

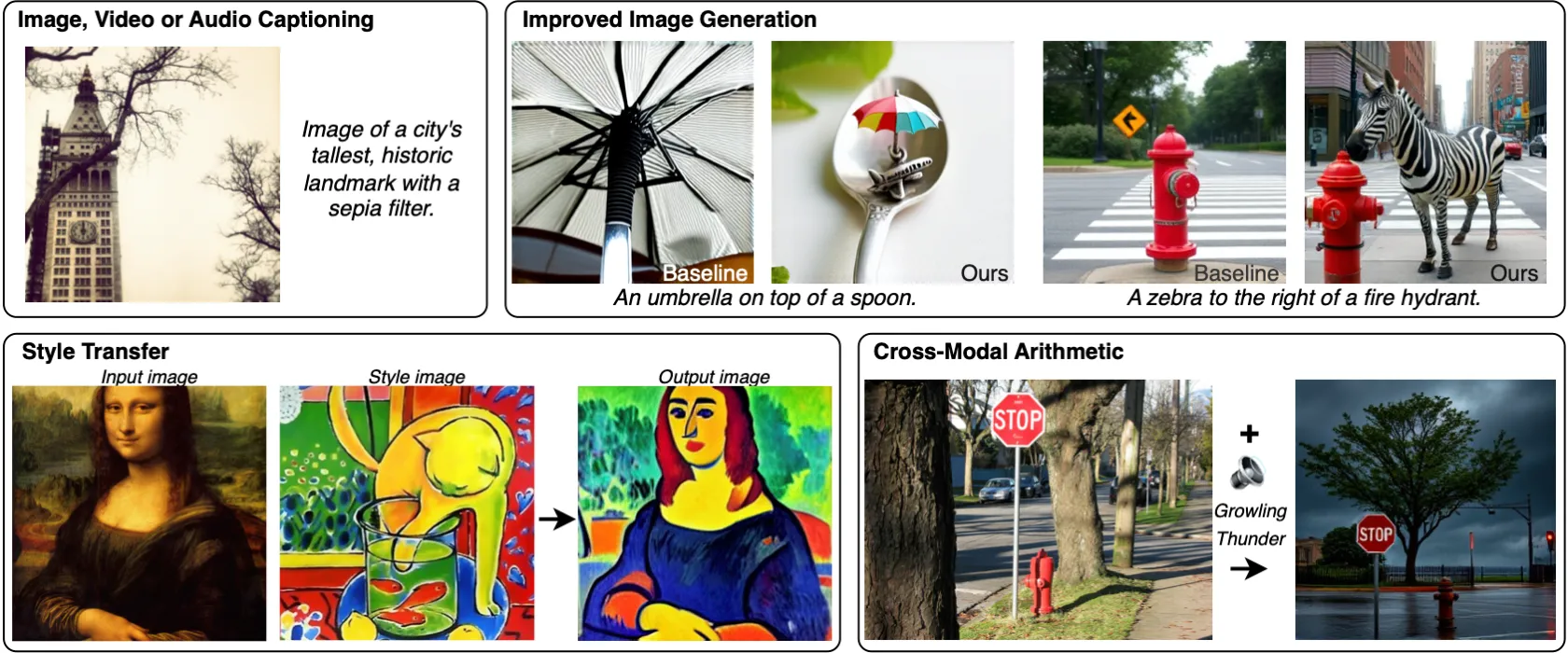

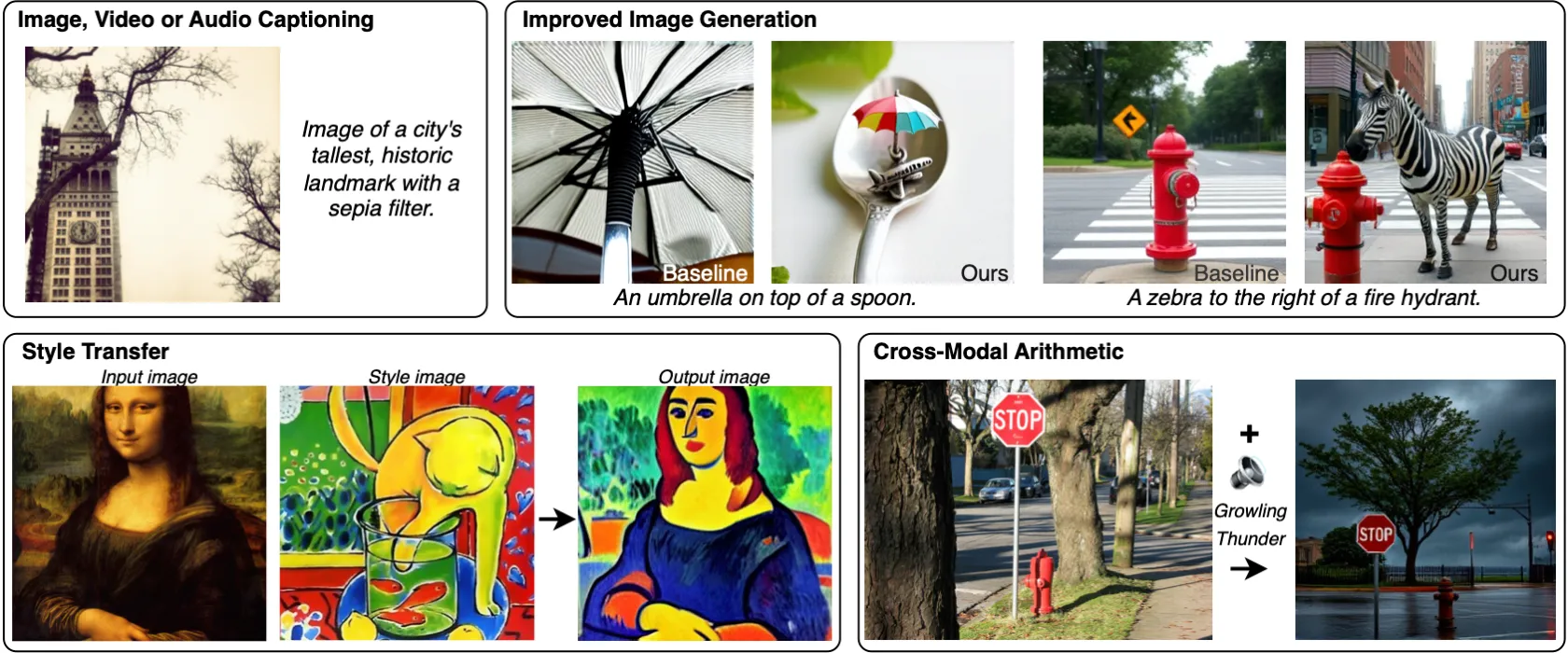

MILS:Meta发布的无需训练就能让LLM获得多模态能力的方法

2025-03-28

-

2025-04-14

-

Gemini 2.5 Pro与Gemini 2.5相比较,有哪些提升?

2025-04-29

-

2025-02-24

-

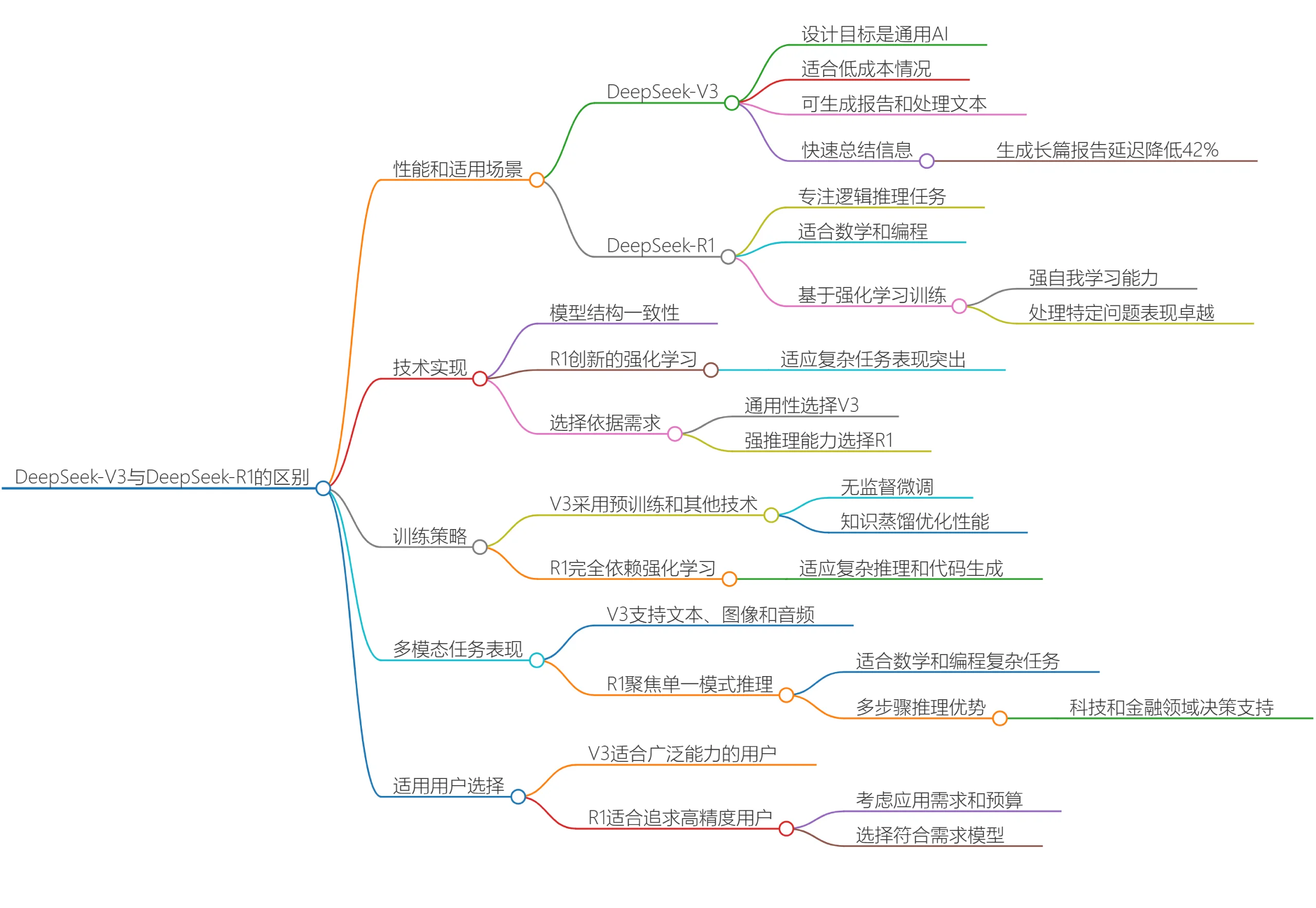

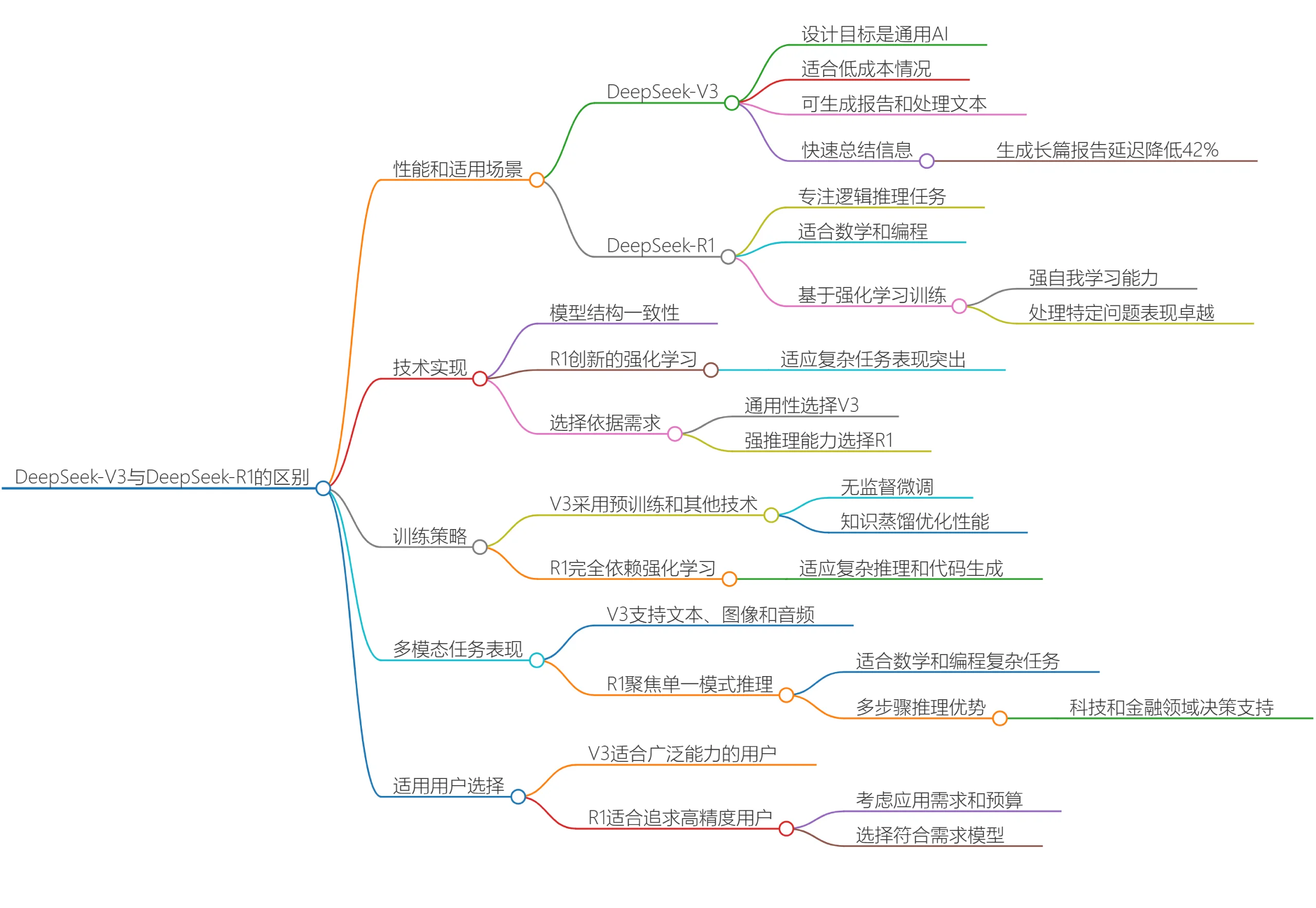

DeepSeek V3和DeepSeek R1有什么区别?哪个更适合你呢?

2025-03-20

-

2025-04-05

-

2025-04-21

-

文生图模型Ideogram 2A:更快的生成速度和更低的成本

2025-03-12

-

2025-03-28