DeepSeek前实习生魔改MoE,用迭代机制把内存需求砍了42%,团队:“免费午餐”优化方法

DeepSeek MoE“变体”来了,200美元以内,内存需求减少17.6-42%!

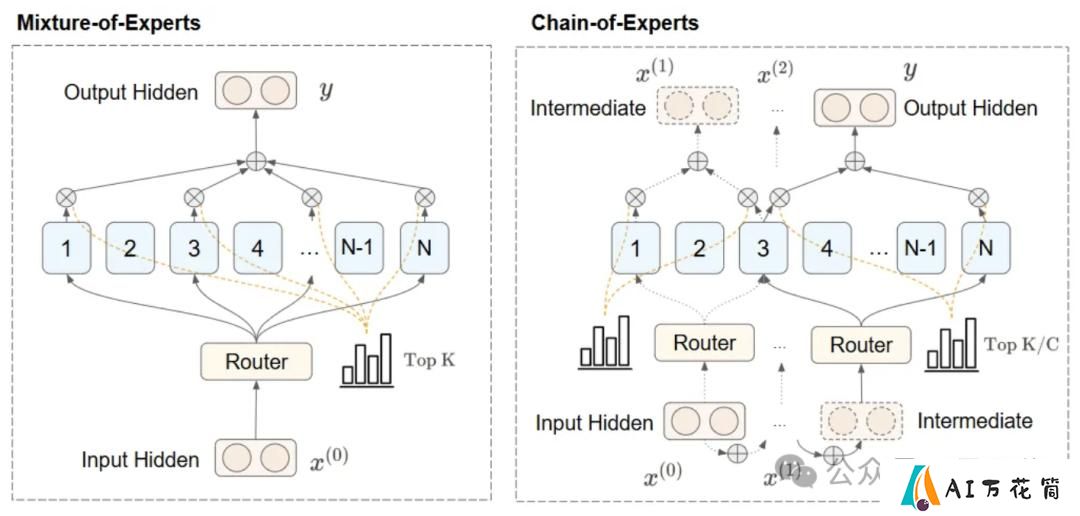

名叫CoE(Chain-of-Experts),被认为是一种“免费午餐”优化方法,突破了MoE并行独立处理token、整体参数数量较大需要大量内存资源的局限。

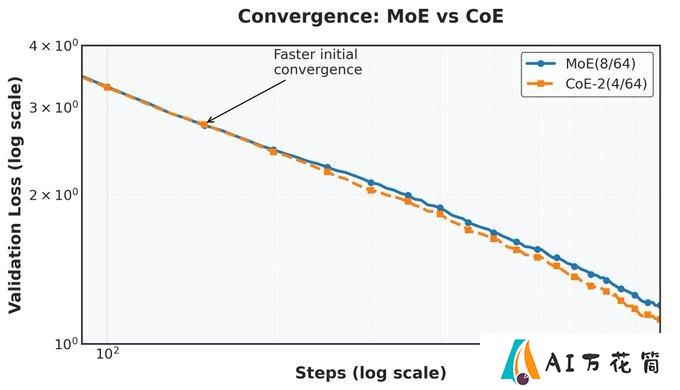

与并行处理不同,CoE使专家能在单层内串行通信,形成一种迭代机制,即专家能“沟通”,在其它专家输出之上处理token。

研究团队在实验中发现,经过2次迭代的CoE,在相同的计算预算下将数学任务的验证损失从1.20降低至1.12,仅仅通过重构信息流就获得了性能提升。

通过扩展CoE的迭代次数,在性能相当的情况下,内存使用比通过增加模型层数或扩展专家选择数量的方法降低了17.6-42%。

另外,在专家组合自由度、专家使用效率等其它方面,CoE也都具有显著优势,专家组合增加823倍。

目前,研究团队晒出了CoE技术Blog(完整论文即将发布),引起不少网友围观。

翻看作者主页,还发现作者Zihan Wang真曾在DeepSeek实习过

-

下一篇: 最后一页

-

SVD AI生成视频:云端Comfyui部署喂饭级教程,“0”代码 无难度!

2025-01-22

-

2025-02-01

-

2025-06-23

-

pytorch-grad-cam学习资料汇总 - 计算机视觉高级AI可解释性工具

2025-01-07

-

2025-01-16

-

Best-AI-Agents学习资料汇总 - 探索人工智能自主代理的前沿技术

2025-01-27

-

2025-02-08

-

understand-prompt学习资料汇总 - AI助手的探索与应用

2025-01-02

-

Metaflow: 简化数据科学和机器学习工作流程的强大框架

2025-01-13

-

2025-01-22