RAG真能提升LLM推理能力?人大最新研究:数据有噪声,RAG性能不升反降

RAG通过纳入外部文档可以辅助LLM进行更复杂的推理,降低问题求解所需的推理深度,但由于文档噪声的存在,其提升效果可能会受限。中国人民大学的研究表明,尽管RAG可以提升LLM的推理能力,但这种提升作用并不是无限的,并且会受到文档中噪声信息的影响。通过DPrompt tuning的方法,可以在一定程度上提升LLM在面对噪声时的性能。

近年来,大语言模型已经在多种任务上表现出来出色的能力,然而,由于缺乏事实性信息,当前的LLM经常出现严重的幻觉现象;此外,LLM中的知识是通过其参数进行编码记忆,这意味着要融入新知识需要进一步的微调,消耗大量的时间与计算资源。因此,通过结合外部检索器来增强LLM的性能,已经成为了主流的方案。

尽管RAG在现代LLM中被广泛采用,但对于RAG如何辅助推理的深入理解仍然是一个未解的问题。目前,大多数研究人员主要将RAG视为提供领域特定知识的方法,并常常试图通过RAG使LLM适应特定子领域。然而,RAG在增强推理能力方面的影响尚未得到深入研究。

近日,来自中国人民大学的学者指出,RAG可以帮助LLM提升其推理能力,但其提升有限,并且由于retriever中的噪声,RAG甚至可能造成推理能力的下降。

论文地址:https://export.arxiv.org/abs/2410.02338

背景与动机

我们可以将LLM视为计算

-

下一篇: 最后一页

-

2025-07-04

-

2025-07-09

-

DeepSeek硬控智能家居!四大电视巨头抢跑,AR眼镜、智能音箱都上桌了

2025-06-26

-

AI零食真能吃吗?我们买了无印良品AI薯条尝了尝,结果很意外

2025-07-01

-

对话商业大咖,解构“正确的事”:WISE2024 商业之王大会来了!

2025-07-07

-

2025-07-12

-

解构Manus AI:这是通用Agent革命,还是精巧缝合怪?

2025-06-23

-

2025-06-29

-

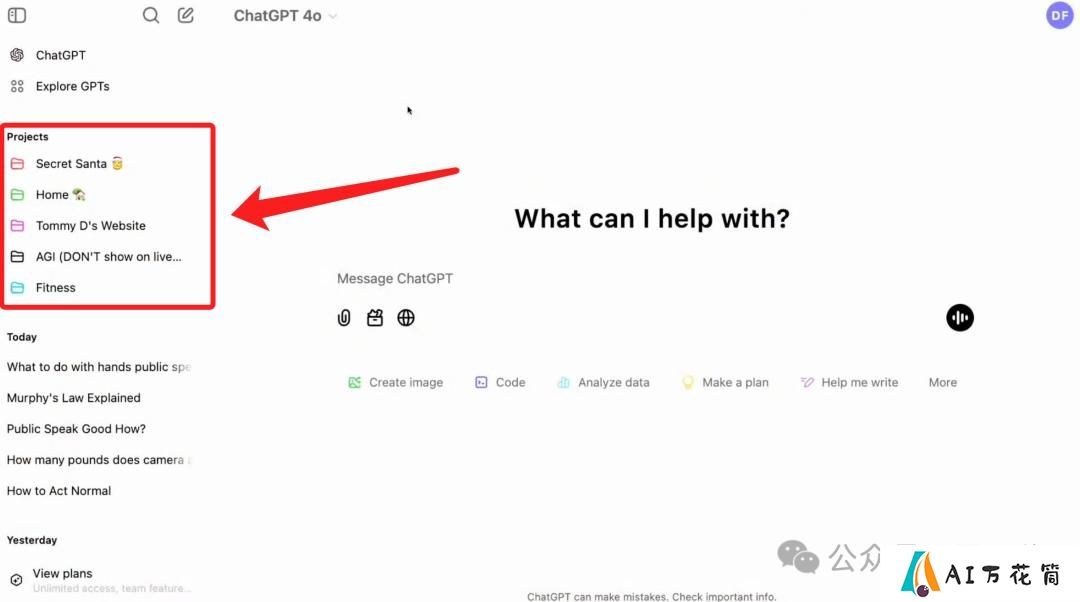

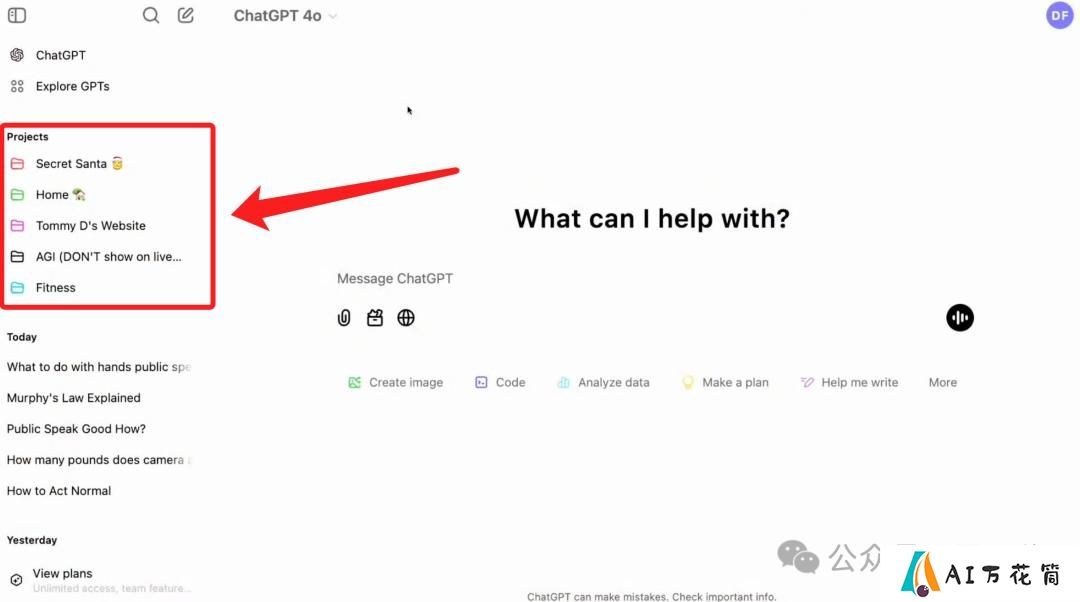

ChatGPT终于也推出Projects功能,却故意露出一个“AGI”的项目

2025-07-04

-

桌面版ChatGPT升级,支持编程App交互,离AI接管电脑又近一步

2025-07-09