AI视频革新,东京大学、腾讯共同开源图片生成视频项目,可控制运动轨迹

项目简介

MOFA-Video是一款基于Pytorch的官方实现,专注于通过生成性运动场适应技术在冻结的图像到视频扩散模型中实现可控制的图像动画。该项目的核心在于运用稳定视频扩散模型,引入ControlNet灵感的MOFA适配器,使得用户能够根据多种稀疏控制信号将输入图像动画化。MOFA-Video具备在多个域之间调整动作的能力,使其成为在视频生成和图像处理领域的一个创新工具。

DEMO

1. 轨迹控制 + 地标控制

2. 轨迹控制

3. 地标控制

技术

MOFA-Video是一种设计用来将不同领域中的动作适应到冻结的视频扩散模型的方法。通过使用稀疏到密集(S2D)运动生成和基于流的运动适应,MOFA-Video能够使用各种类型的控制信号有效地对单个图像进行动画处理,包括轨迹、关键点序列及其组合。

在训练阶段,通过稀疏运动采样生成稀疏控制信号,然后训练不同的MOFA-适配器通过预训练的SVD生成视频。在推理阶段,不同的MOFA-适配器可以组合在一起,共同控制冻结的SVD。

项目链接

https://github.com/MyNiuuu/MOFA-Video

- AI视频革新,东京大学、腾讯共同开源图片生成视频项目,可控制运动轨迹

- 字节、阿里、百度大模型价格战拼刺刀!百度刚刚直接官宣免费调用,不知道谁能笑到最后,反正开发者们是笑了

- Phidata:8.3k星星!用GPT-4o创建具有长期记忆的 AI Agent

- ID-Animator:1小时前开源,单张人脸照片就可以生成高质量的特定人体视频

- ScrapeGraphAI:开源的大语言模型爬虫,只要说出需求就会自动全网抓取想要的信息

- IDM-VTON:刚开源就有1.8K星星,最新的照片AI换装项目,可用于虚拟试穿,附试用链接

- StoryDiffusion:南开大学最新开源,创作连续故事情节的漫画和视频

- MemGPT:9.2k星星!创建具有长期记忆和自定义工具的大模型Agent,完全开源!

- llm-answer-engine:开源且完成度很高的AI搜索引擎,可商业化落地

- LLocalSearch:完全本地化的搜索Agent助手,自动整理全网搜索结果,已开源可立即体验!

-

tortoise-tts学习资料汇总 - 高质量多声音TTS系统

2024-12-31

-

-

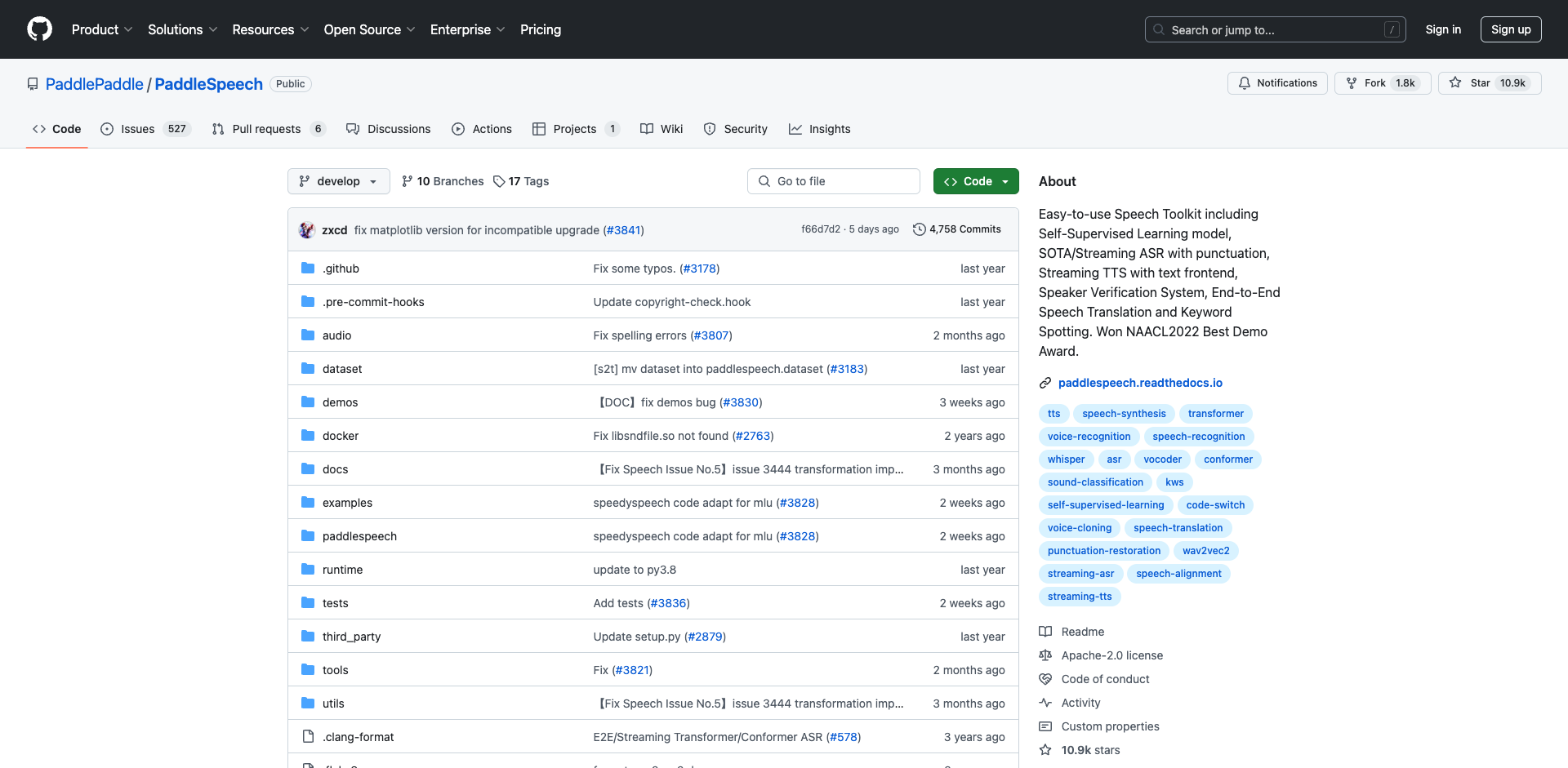

PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

2025-01-02

-

pot-desktop使用指南 - 跨平台划词翻译和OCR软件

2025-01-02

-

understand-prompt学习资料汇总 - AI助手的探索与应用

2025-01-02

-

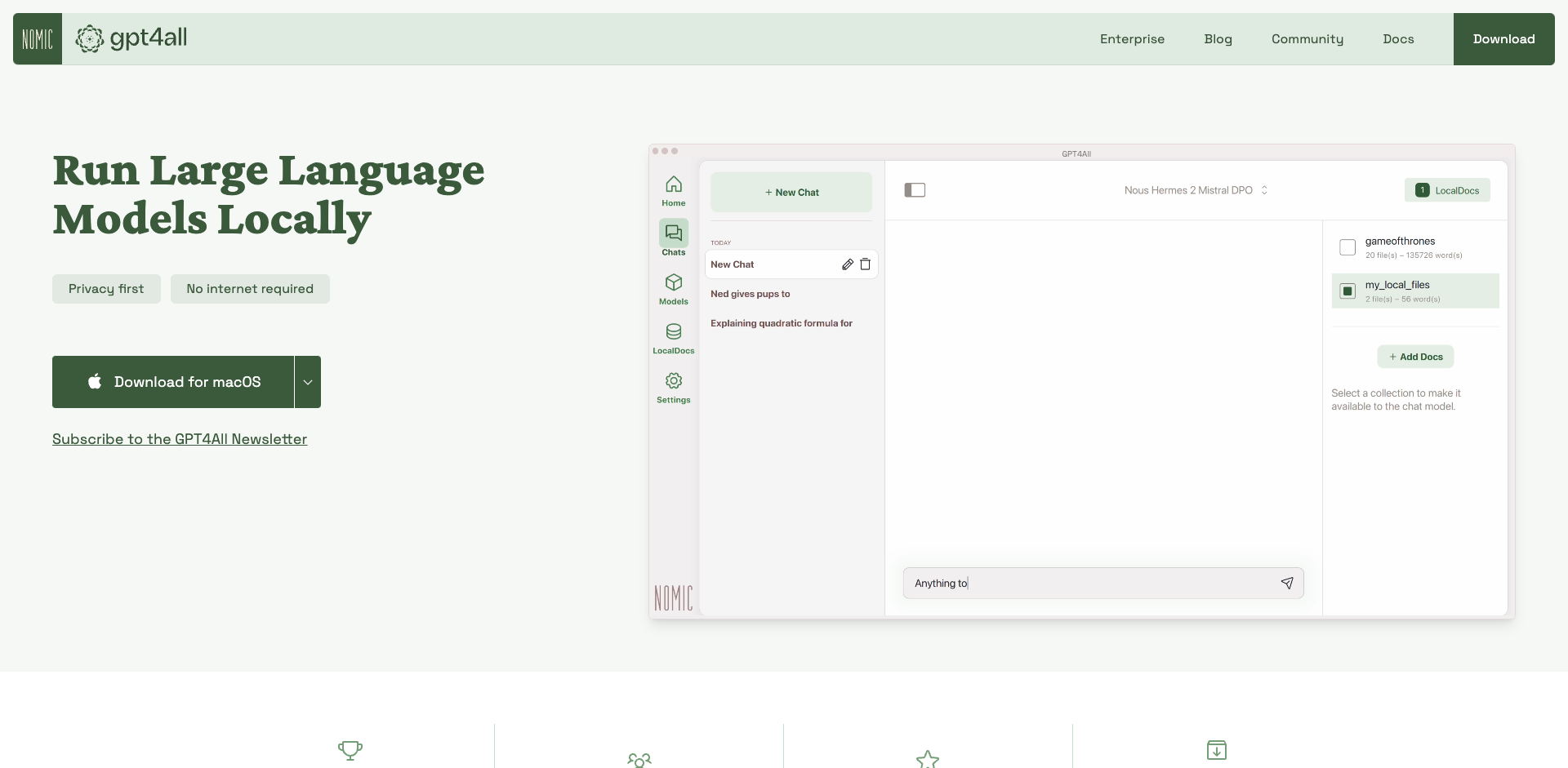

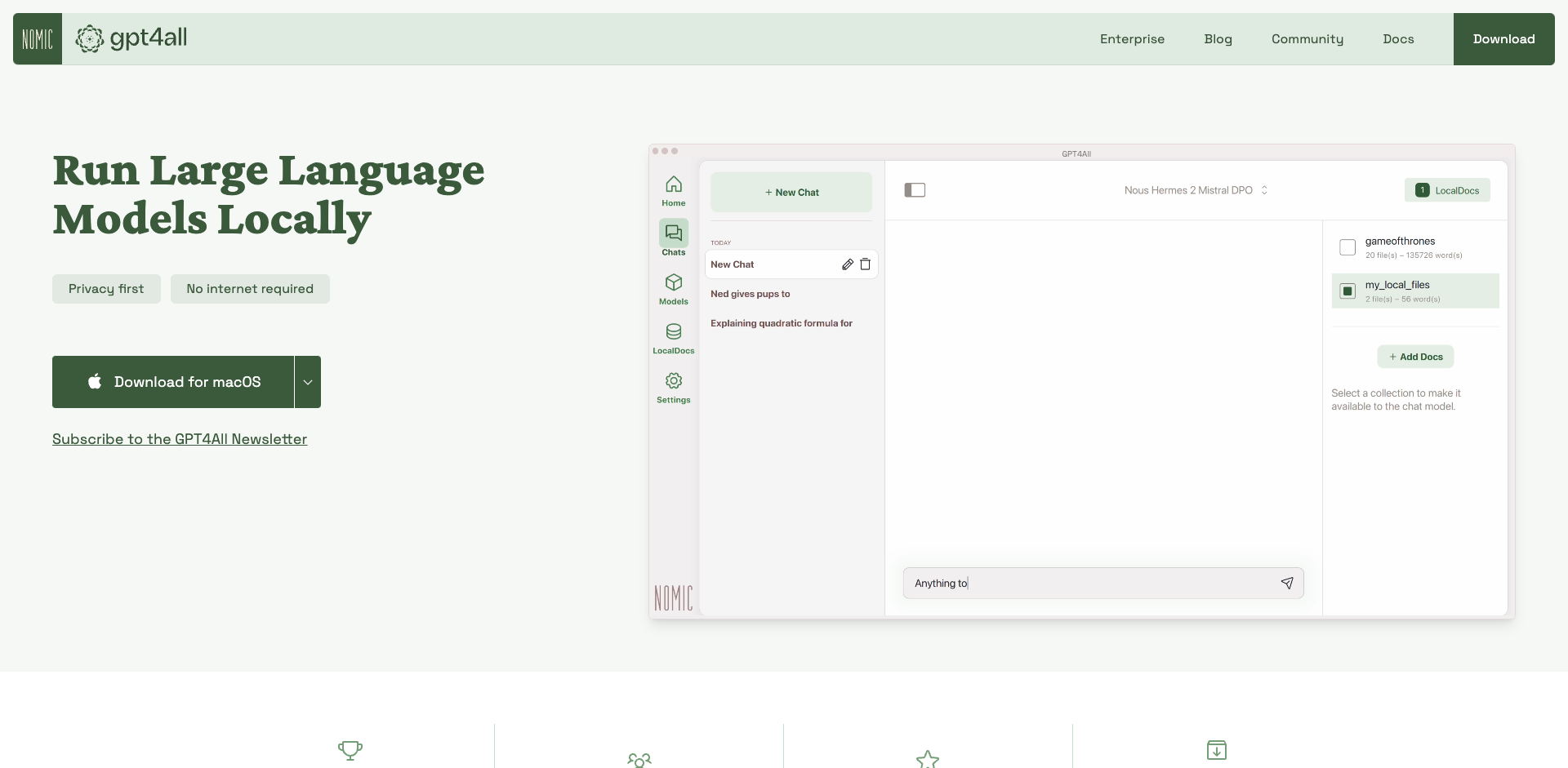

GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

2025-01-02

-

2025-01-02

-

wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

2025-01-02

-

Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

2025-01-02

-

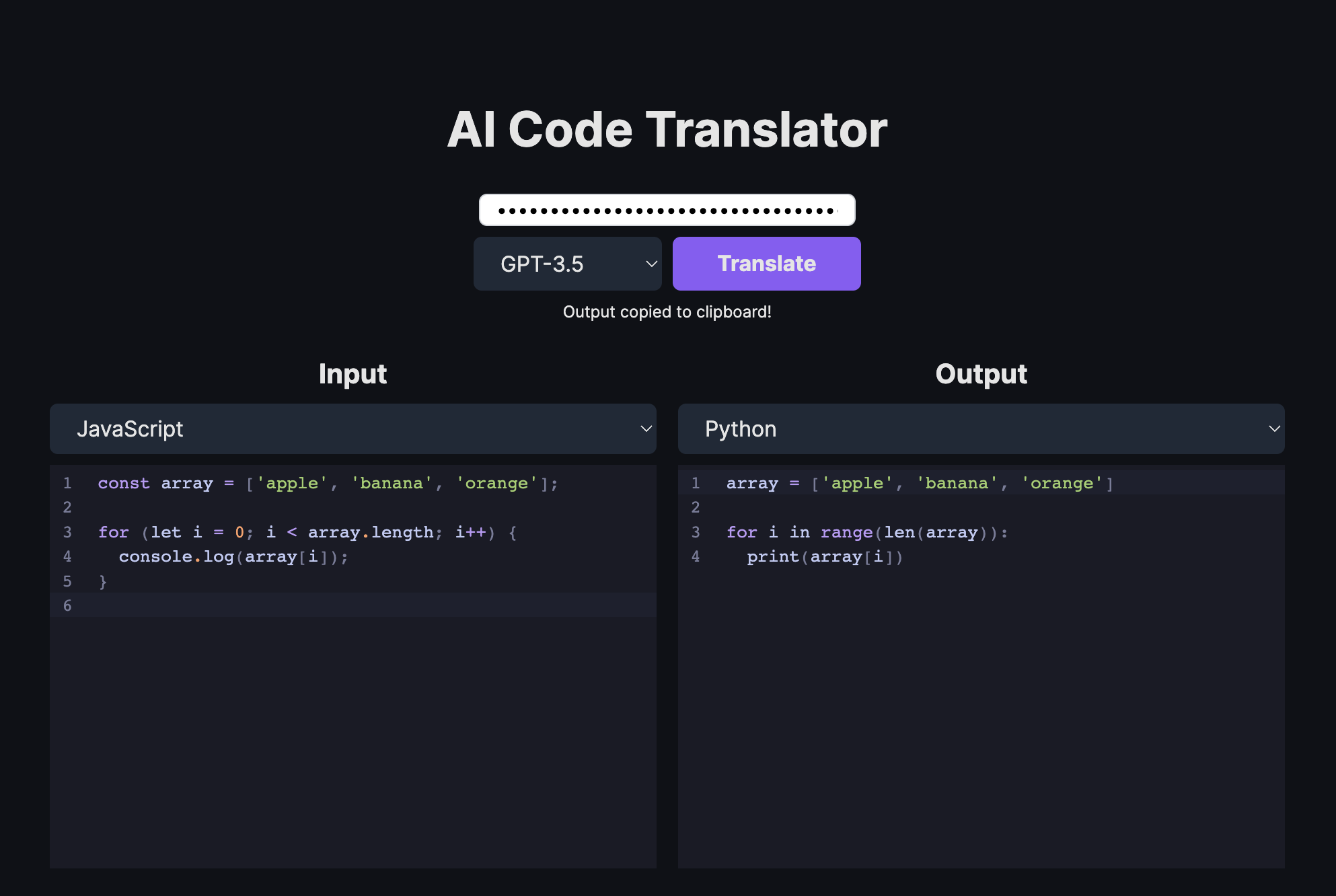

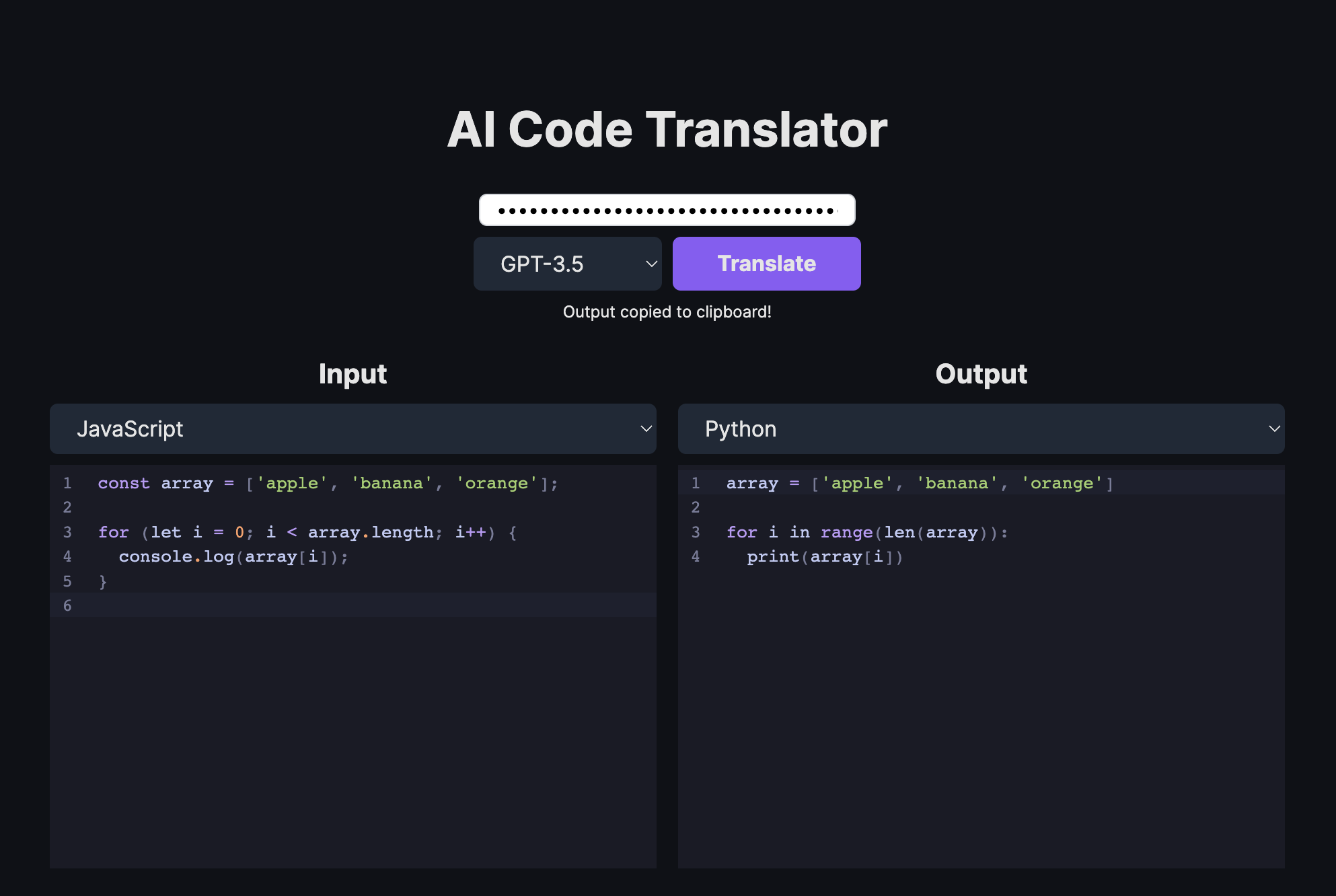

AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言

2025-01-02

-

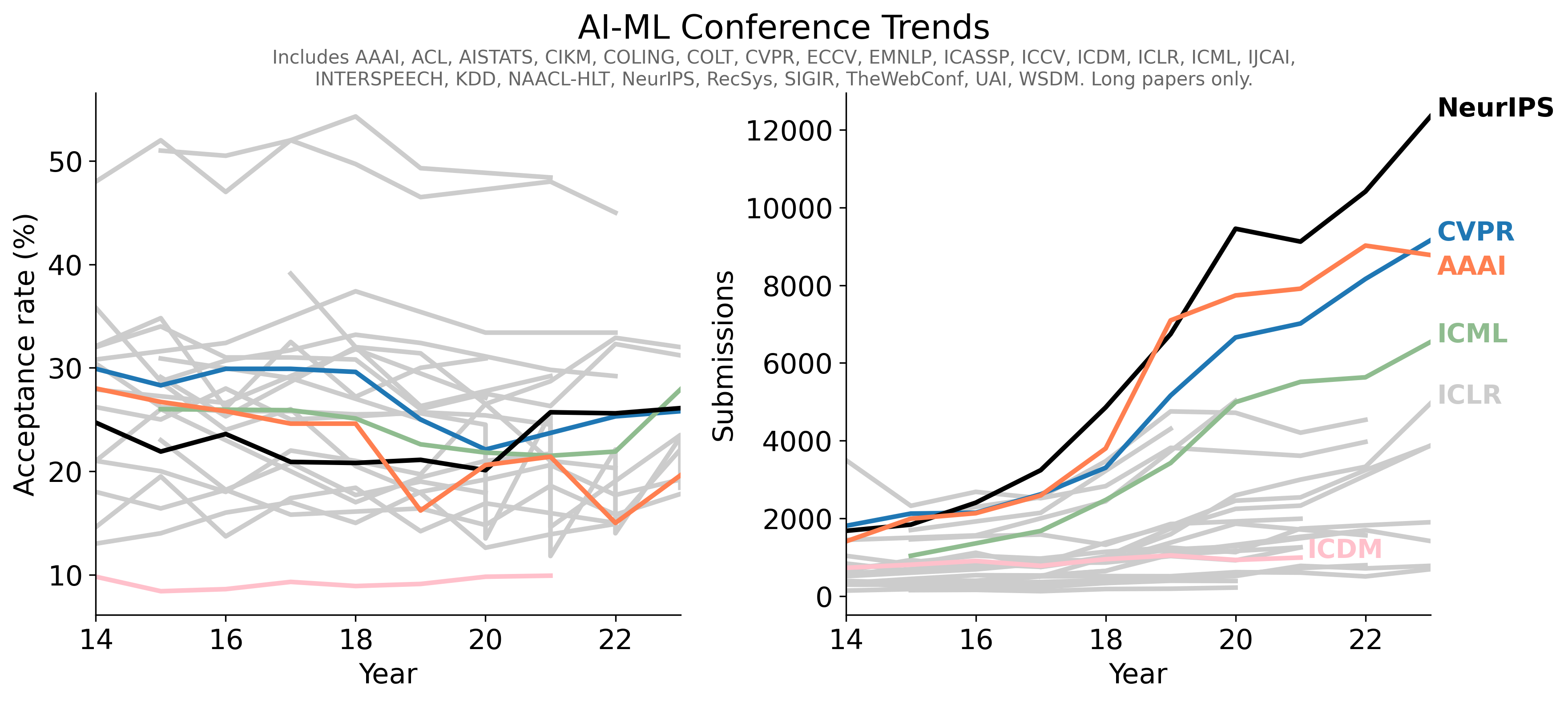

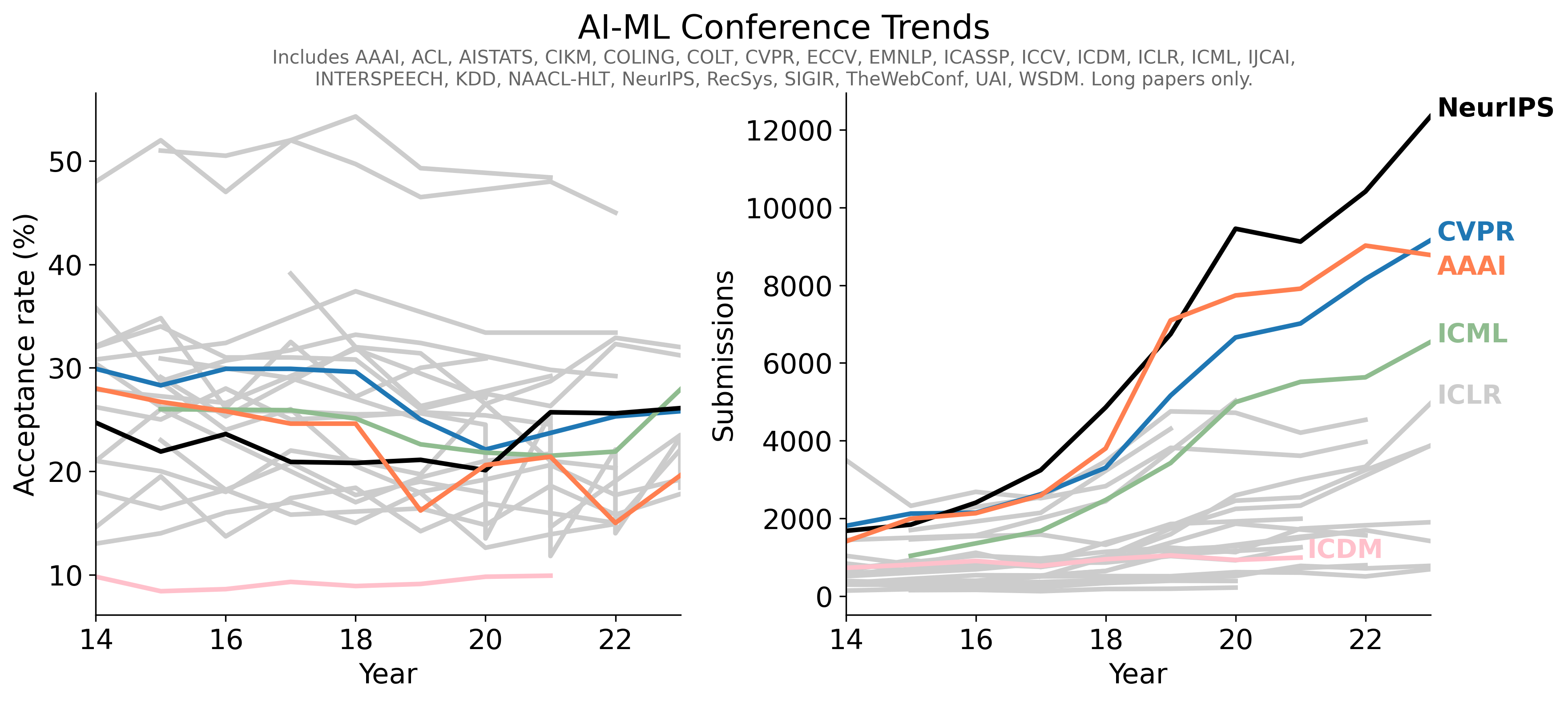

- 1Conference-Acceptance-Rate项目学习指南 - 人工智能顶级会议录用率数据汇总

- 2PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

- 3pot-desktop使用指南 - 跨平台划词翻译和OCR软件

- 4understand-prompt学习资料汇总 - AI助手的探索与应用

- 5GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

- 6law-cn-ai 入门指南 - AI 驱动的中国法律助手

- 7wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

- 8Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

- 9AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言