Nous-Yarn-Mistral-7b-128k:处理长篇文本的先进语言模型,支持128k令牌的语境窗口

更新时间:2025-01-22来源:互联网

项目简介

Nous-Yarn-Mistral-7b-128k 是一种最先进的语言模型,用于处理长篇文本语境,采用 YaRN 扩展方法对长篇文本数据进行了 1500 步的进一步预训练。它是 Mistral-7B-v0.1 的扩展版本,支持 128k 令牌的语境窗口。

要使用,加载模型时传递 trust_remote_code=True 参数,例如:

model = AutoModelForCausalLM.from_pretrained("NousResearch/Yarn-Mistral-7b-128k", use_flash_attention_2=True, torch_dtype=torch.bfloat16, device_map="auto", trust_remote_code=True)此外,您需要使用最新版本的 transformers(在 4.35 版本发布之前)。

pip install git+https://github.com/huggingface/transformers基准测试

长文本语境基准测试:

短文本语境基准测试显示质量下降最小:

项目链接

https://huggingface.co/NousResearch/Yarn-Mistral-7b-128k

-

下一篇: 最后一页

相关文章

更多

- Nous-Yarn-Mistral-7b-128k:处理长篇文本的先进语言模型,支持128k令牌的语境窗口

- Segmind SSD-1B:SDXL文生图的超能英雄,速度提升60%!

- Whisper JAX:让你的语音转文字功能速度快70倍!

- LCM:苹果Mac终于可以跑SD了,几秒一张XL,喂饭级教学!

- LCM模型:探索AI的新边界,让你1秒出4张图,还有可以体验的网站!好玩!太好玩了!我还要玩!

- Pyannote:揭秘声音的DNA,精准分辨出各个发言者的声音

- DETR:Facebook AI打造的下一代物体检测技术

- 视频制作的新趋势:Wav2Lip 唇同步技术全解析

- AnimateAnyone:动画新纪元,AI视频合成魔法

- Seamless:语言无界,Facebook革新AI翻译技术,让世界沟通无障碍!

近期热点

-

tortoise-tts学习资料汇总 - 高质量多声音TTS系统

2024-12-31

-

-

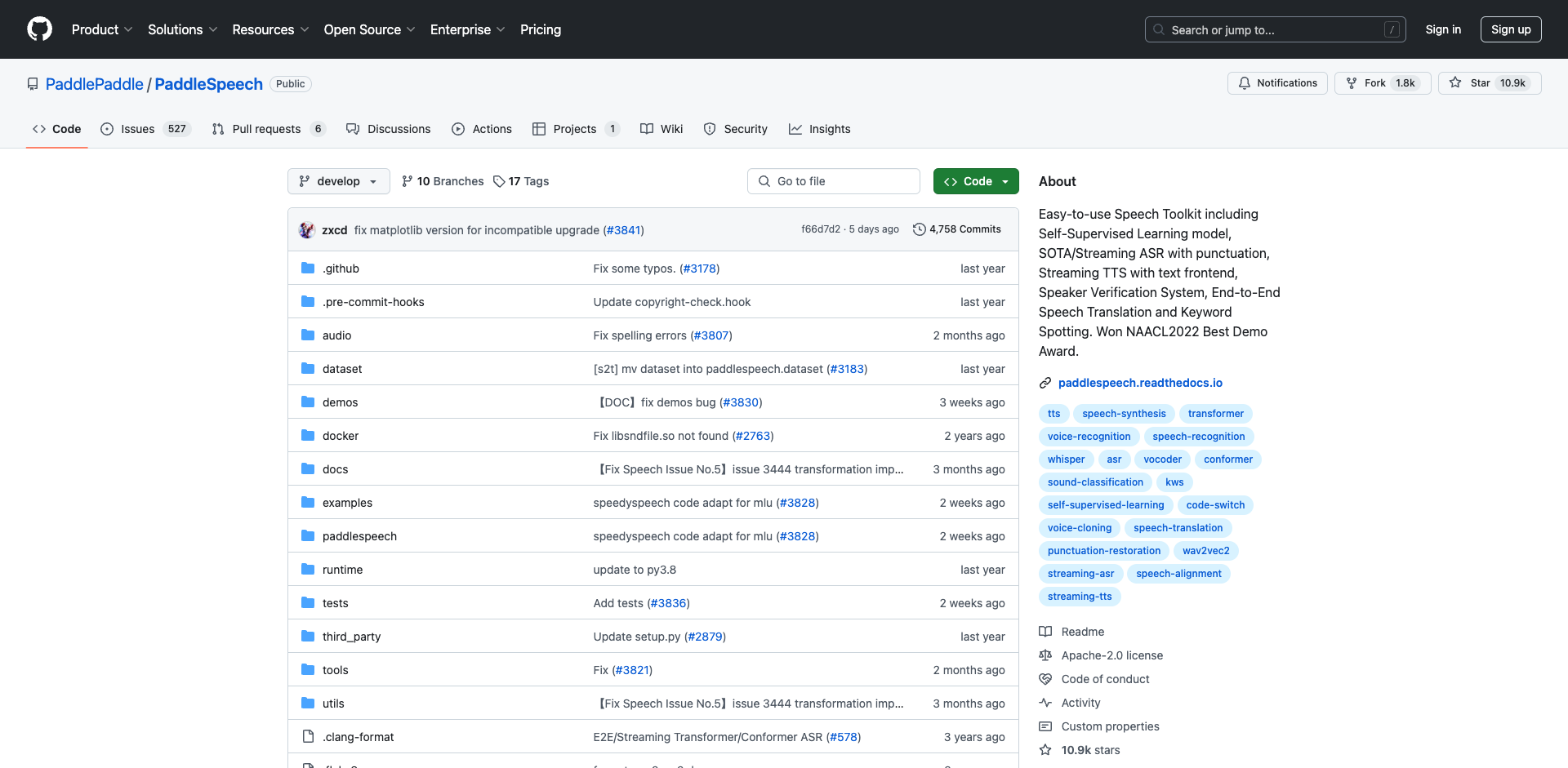

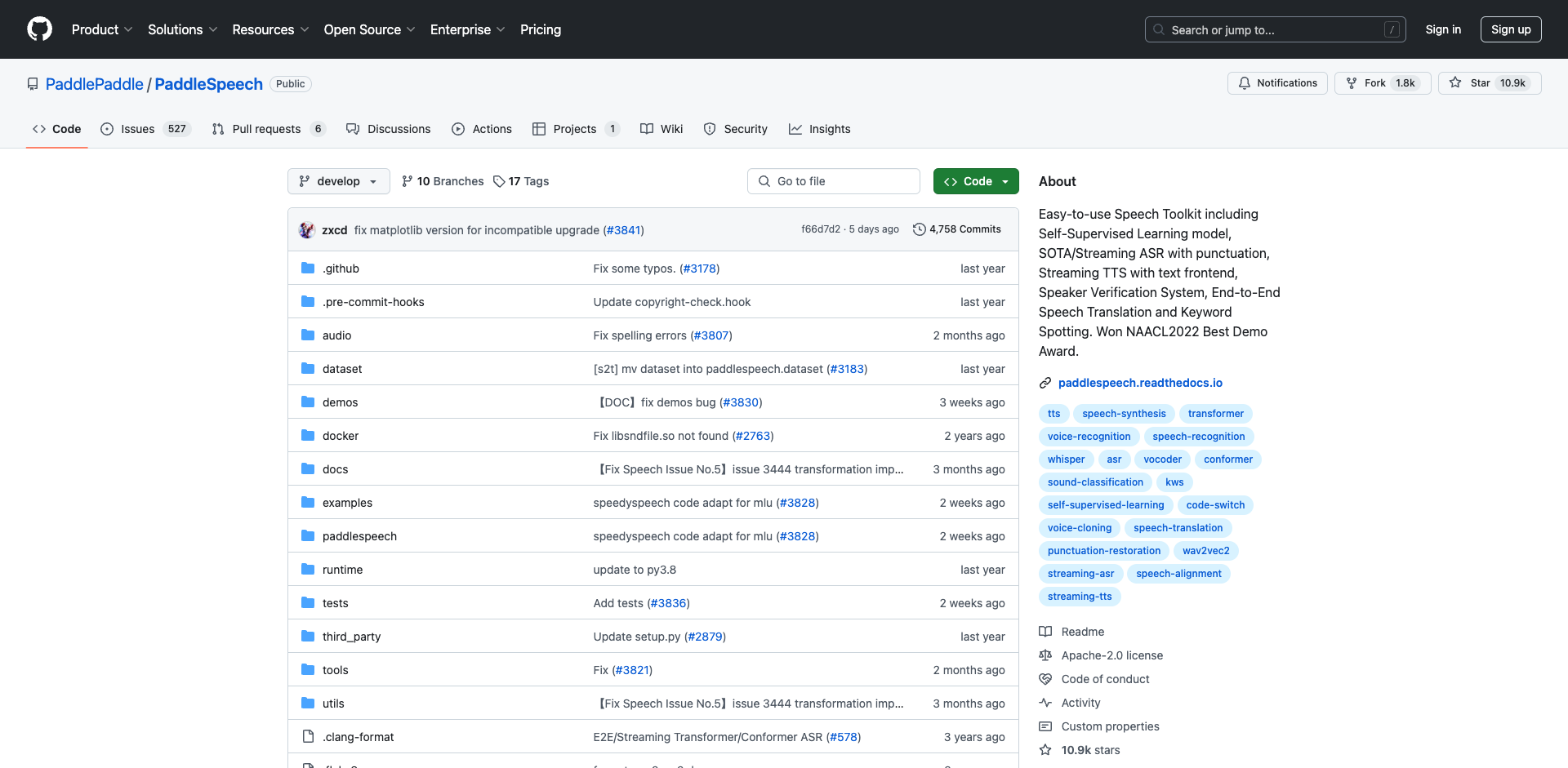

PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

2025-01-02

-

pot-desktop使用指南 - 跨平台划词翻译和OCR软件

2025-01-02

-

understand-prompt学习资料汇总 - AI助手的探索与应用

2025-01-02

-

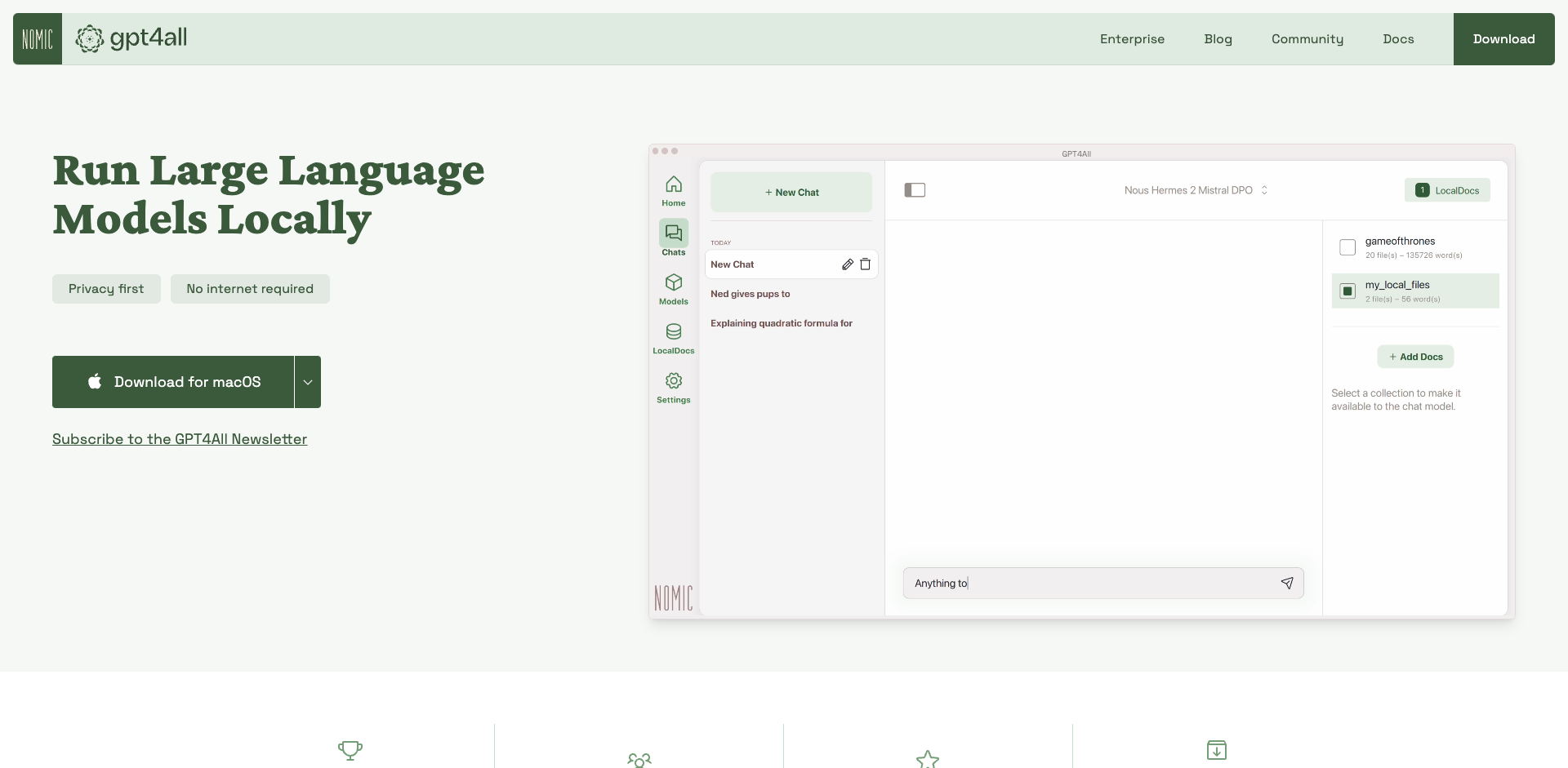

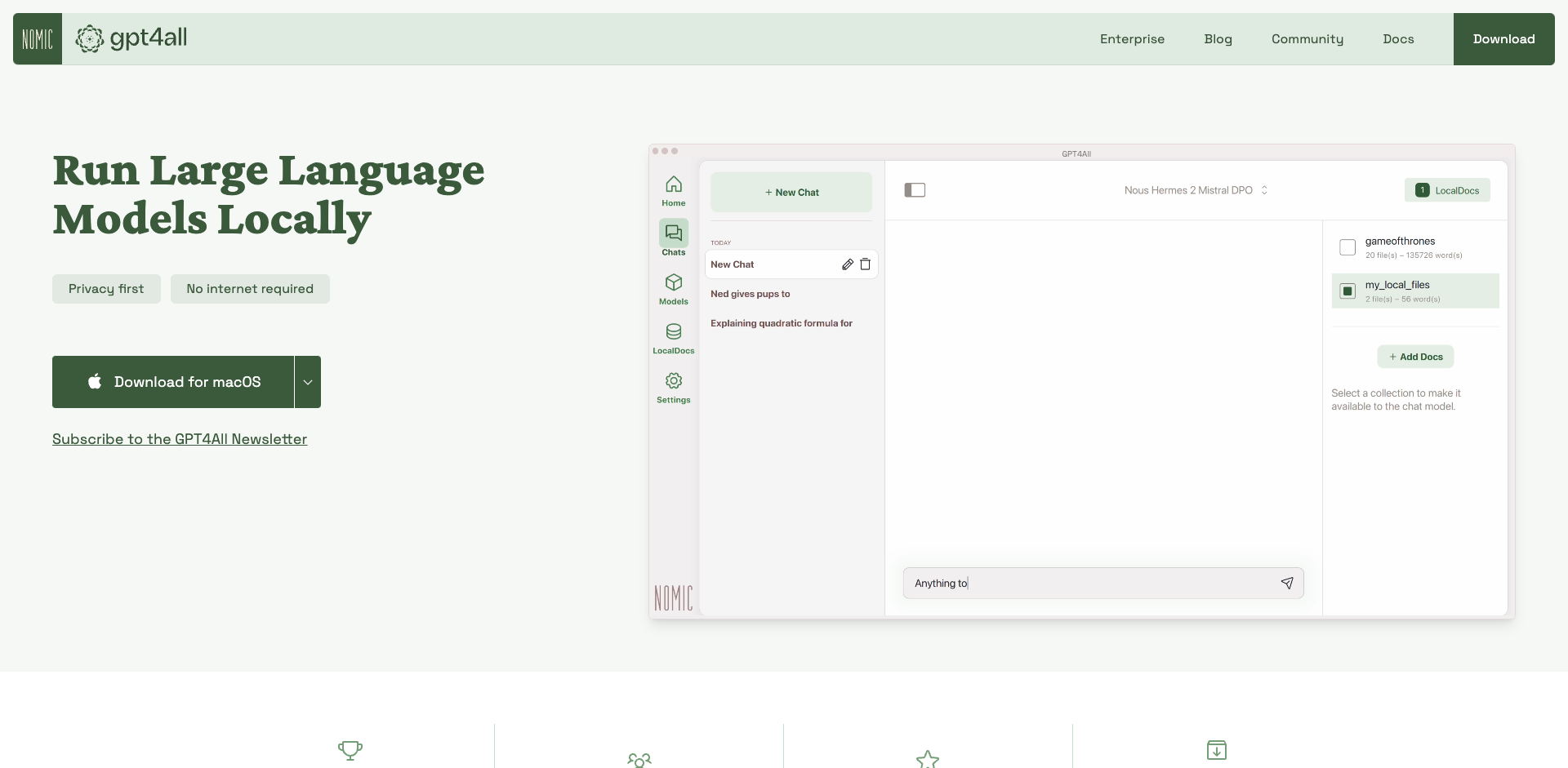

GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

2025-01-02

-

2025-01-02

-

wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

2025-01-02

-

Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

2025-01-02

-

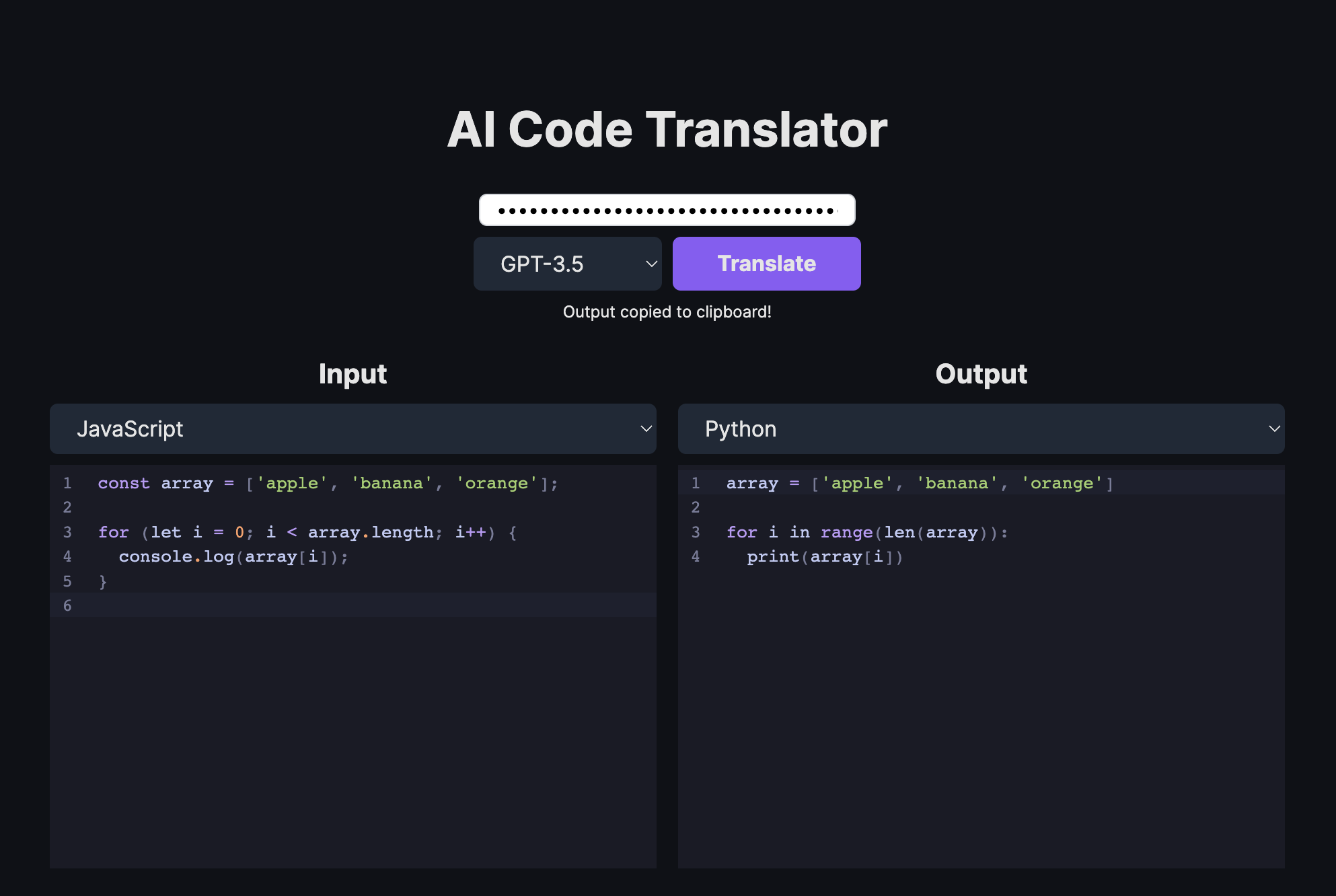

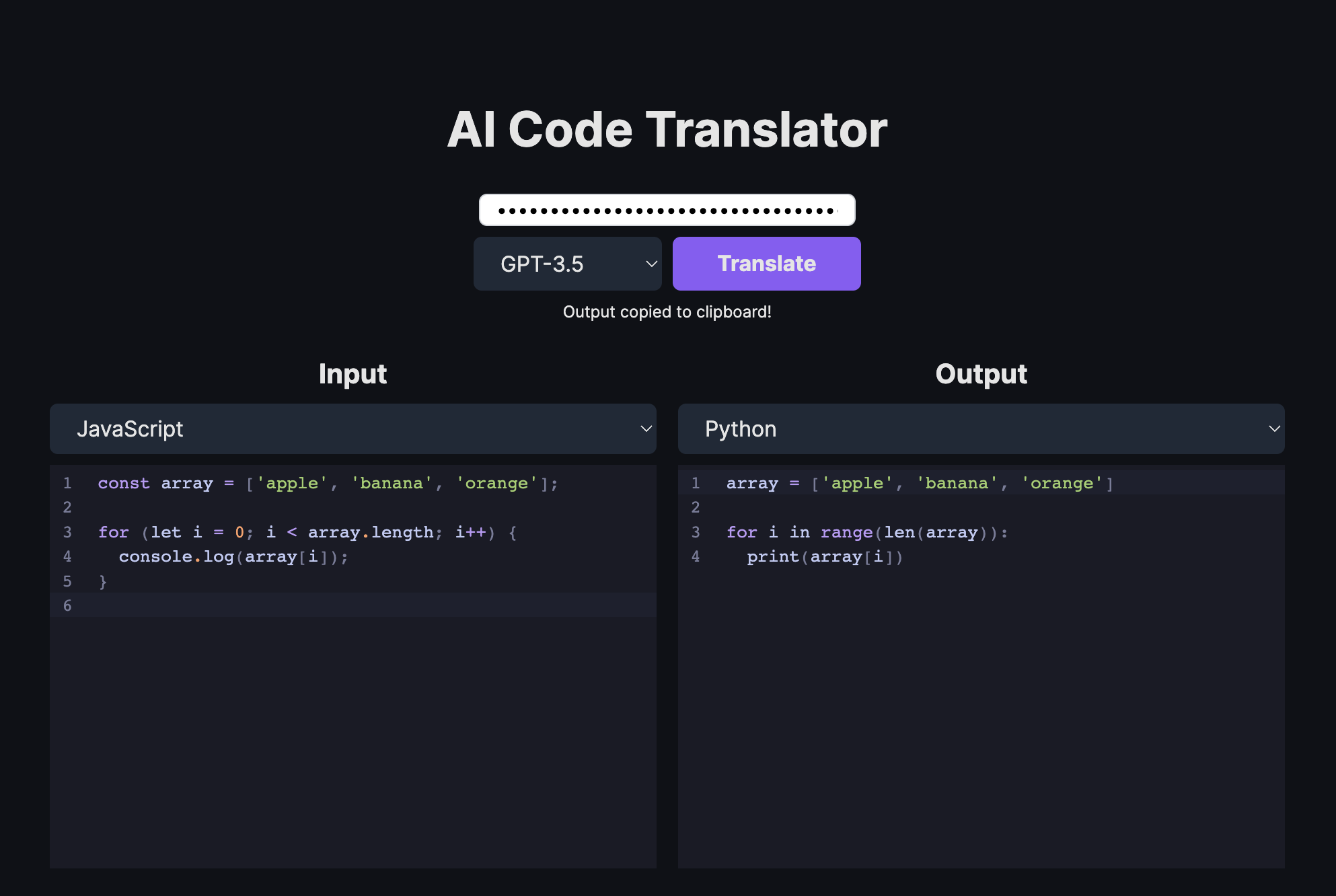

AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言

2025-01-02

热门文章

-

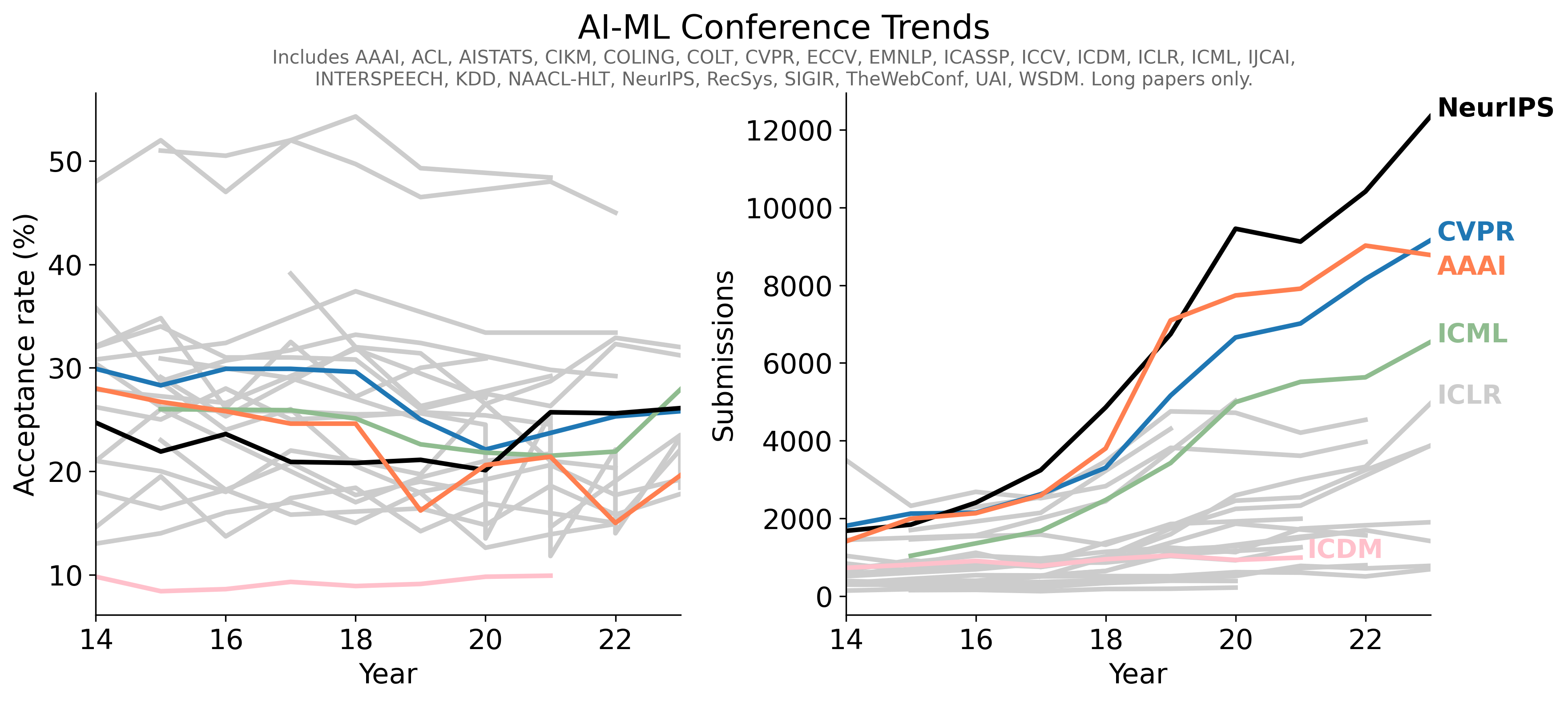

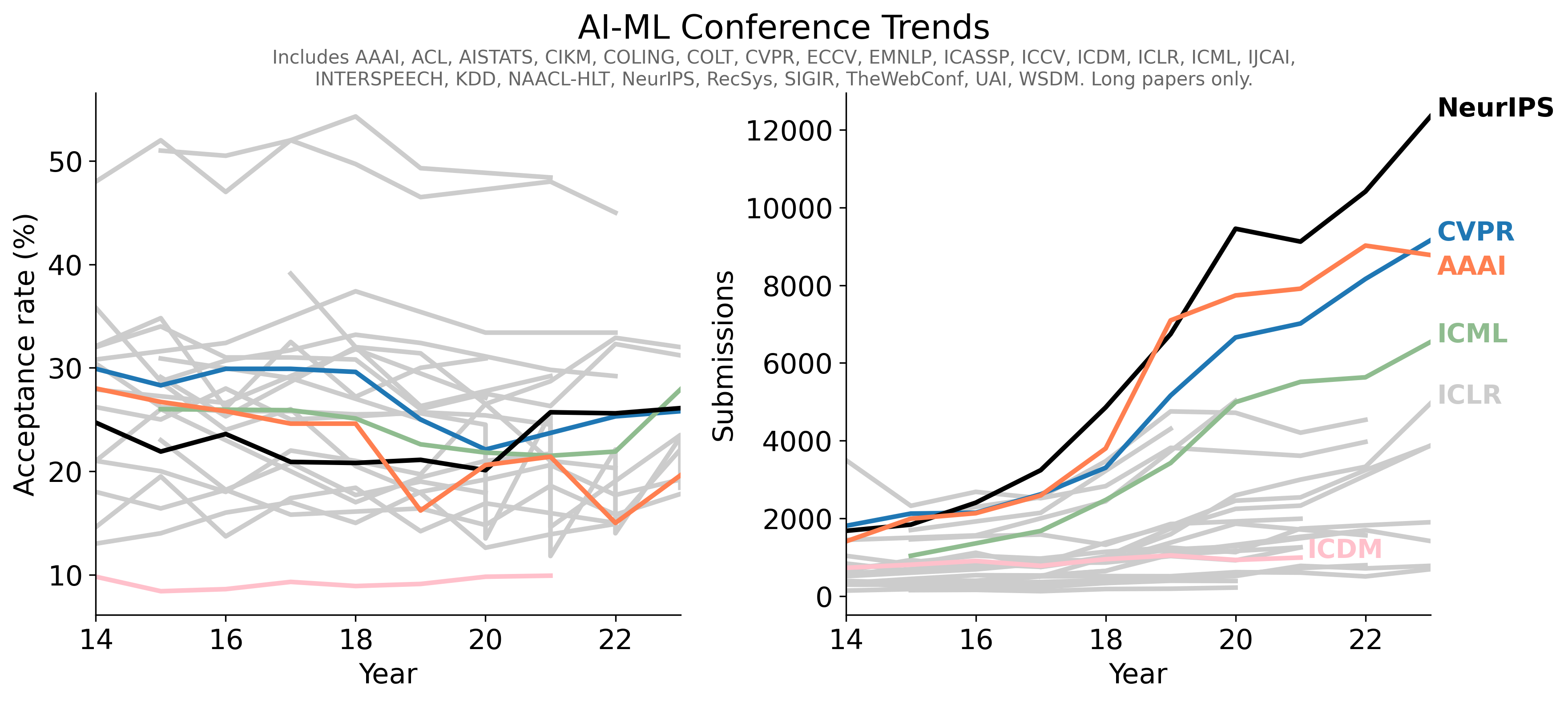

- 1Conference-Acceptance-Rate项目学习指南 - 人工智能顶级会议录用率数据汇总

- 2PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

- 3pot-desktop使用指南 - 跨平台划词翻译和OCR软件

- 4understand-prompt学习资料汇总 - AI助手的探索与应用

- 5GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

- 6law-cn-ai 入门指南 - AI 驱动的中国法律助手

- 7wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

- 8Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

- 9AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言