VisualGLM-6B 学习资料汇总 - 开源多模态中英双语对话模型

更新时间:2025-01-26来源:互联网

VisualGLM-6B简介

VisualGLM-6B是由清华大学开源的一个支持图像、中文和英文的多模态对话语言模型。它基于ChatGLM-6B语言模型,通过训练BLIP2-Qformer构建起视觉模型与语言模型的桥梁,整体模型共78亿参数。

VisualGLM-6B具有以下特点:

支持图像、中文和英文的多模态对话基于ChatGLM-6B,具有62亿参数通过BLIP2-Qformer连接视觉模型和语言模型在30M中文和300M英文图文对上进行预训练支持低资源设备部署,INT4量化后最低只需6.3G显存官方资源

GitHub仓库: https://github.com/THUDM/VisualGLM-6BHugging Face模型: https://huggingface.co/THUDM/visualglm-6b技术报告: https://arxiv.org/abs/2103.10360使用教程

安装依赖:pip install -r requirements.txt使用Transformers加载模型:from transformers import AutoTokenizer, AutoModeltokenizer = AutoTokenizer.from_pretrained("THUDM/visualglm-6b", trust_remote_code=True)model = AutoModel.from_pretrained("THUDM/visualglm-6b", trust_remote_code=True).half().cuda()image_path = "your_image_path"response, history = model.chat(tokenizer, image_path, "描述这张图片。", history=[])print(response)运行Demo:python web_demo.py # 网页版Demopython cli_demo.py # 命令行Demo模型微调

VisualGLM-6B支持以下几种微调方式:

LoRAQLoRAP-tuning微调示例代码:

bash finetune/finetune_visualglm.sh部署

命令行部署: python cli_demo.py网页部署: python web_demo.pyAPI部署: python api.py模型量化

model = AutoModel.from_pretrained("THUDM/visualglm-6b", trust_remote_code=True).quantize(8).half().cuda()相关项目

XrayGLM: 基于VisualGLM-6B的X光诊断问答模型StarGLM: 基于VisualGLM-6B的天文图像问答模型总结

VisualGLM-6B作为一个开源的多模态对话模型,为研究者和开发者提供了丰富的学习和应用资源。通过本文的介绍和资源汇总,相信读者可以快速上手使用VisualGLM-6B,并根据自己的需求进行进一步的开发和优化。

-

下一篇: 最后一页

相关文章

更多

- VisualGLM-6B 学习资料汇总 - 开源多模态中英双语对话模型

- YAYI2学习资料汇总-新一代多语言开源大语言模型

- Open-Custom-GPT学习资料汇总 - 快速创建和嵌入自定义GPT的开源项目

- PhaseLLM学习资料汇总-大型语言模型评估和工作流框架

- FantasyCopilot入门指南 - 新一代AI桌面助手工具

- SiYuan 学习资料汇总 - 隐私优先的个人知识管理系统

- SQL Translator入门学习资料 - 将自然语言转换为SQL的AI工具

- Chatpad学习资料汇总 - 优质ChatGPT用户界面

- Tacotron入门学习资料 - 端到端语音合成系统

- MaryTTS 学习资料汇总 - 开源多语言文本转语音系统

近期热点

-

tortoise-tts学习资料汇总 - 高质量多声音TTS系统

2024-12-31

-

-

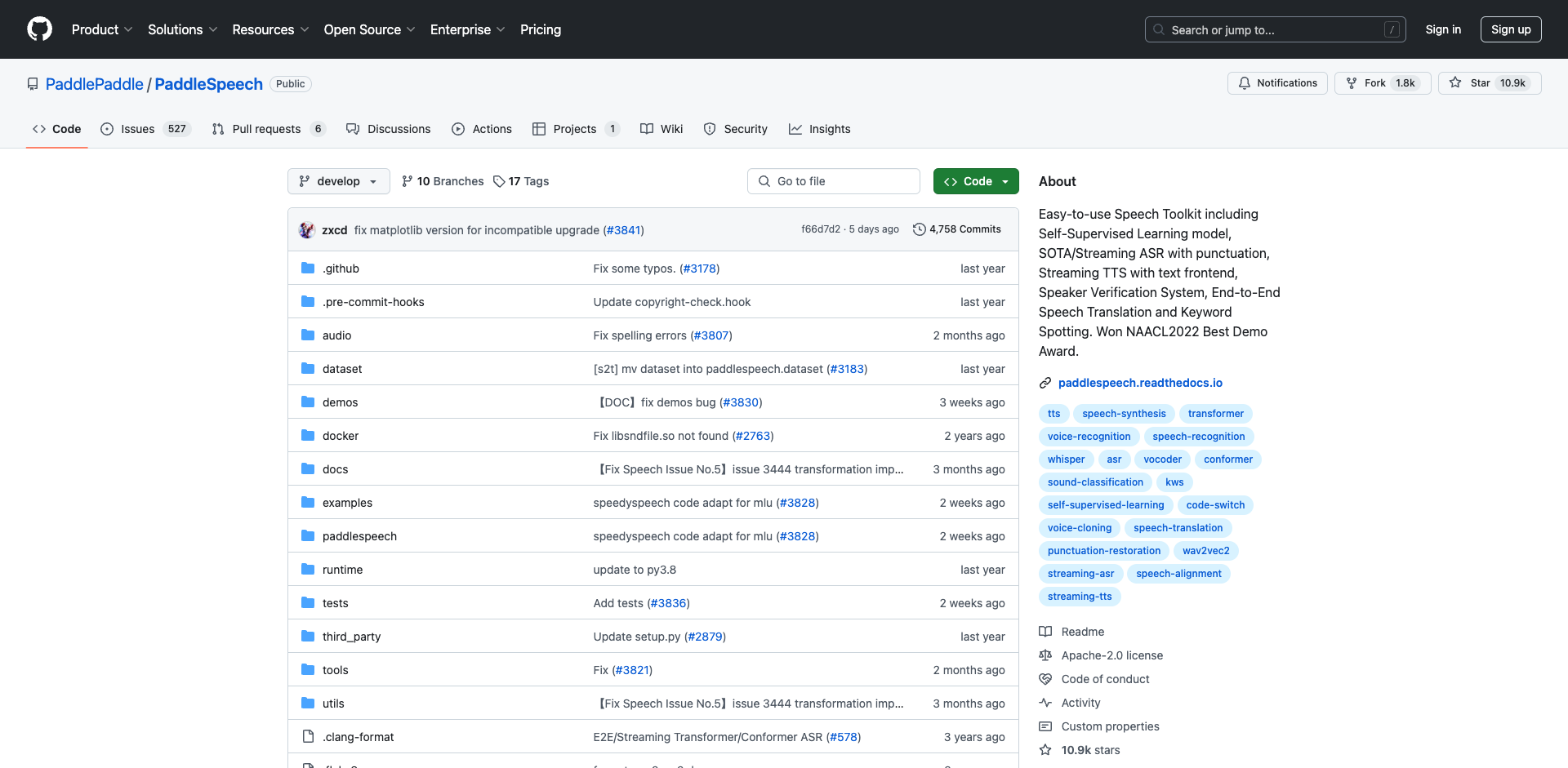

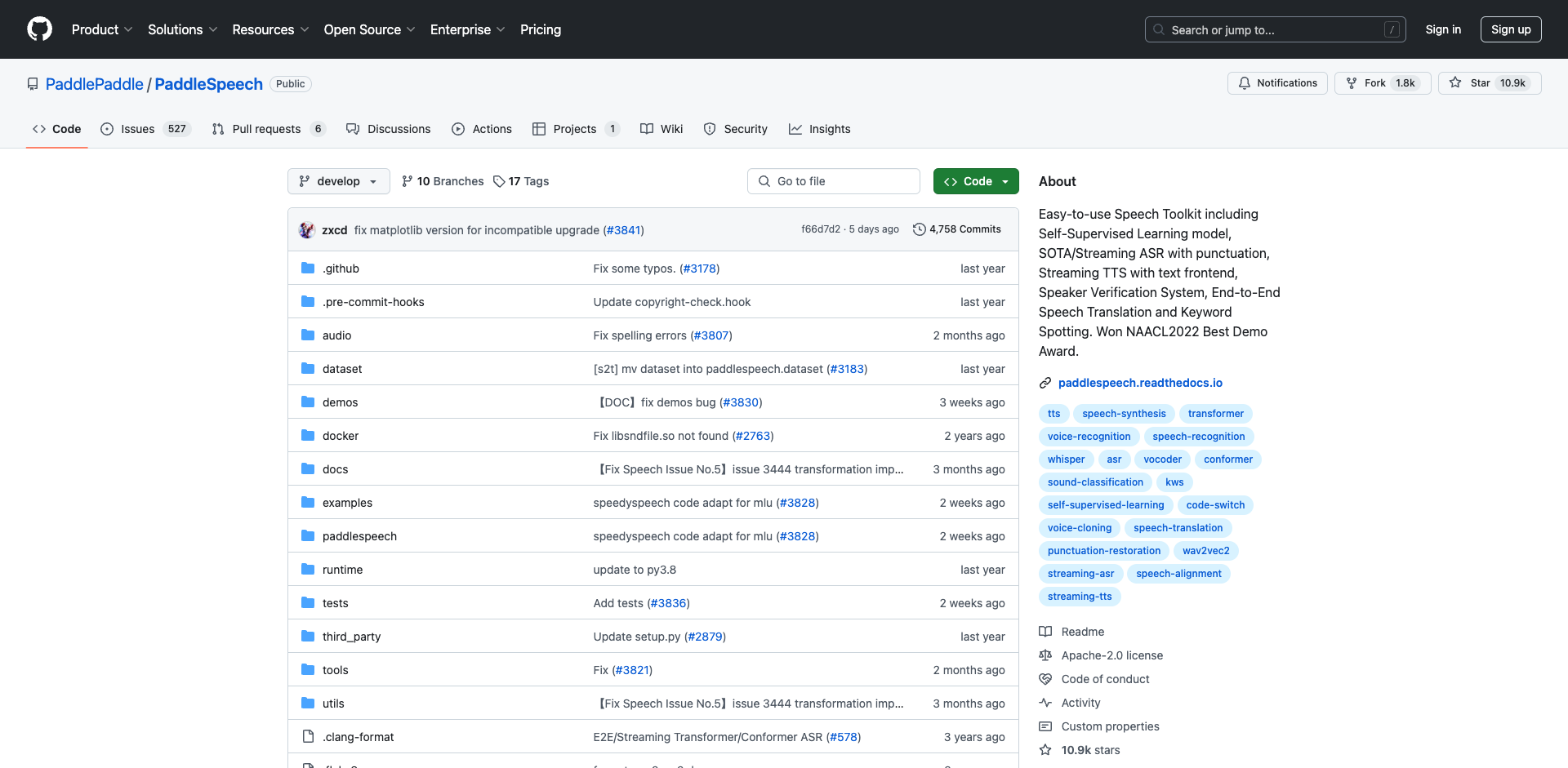

PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

2025-01-02

-

pot-desktop使用指南 - 跨平台划词翻译和OCR软件

2025-01-02

-

understand-prompt学习资料汇总 - AI助手的探索与应用

2025-01-02

-

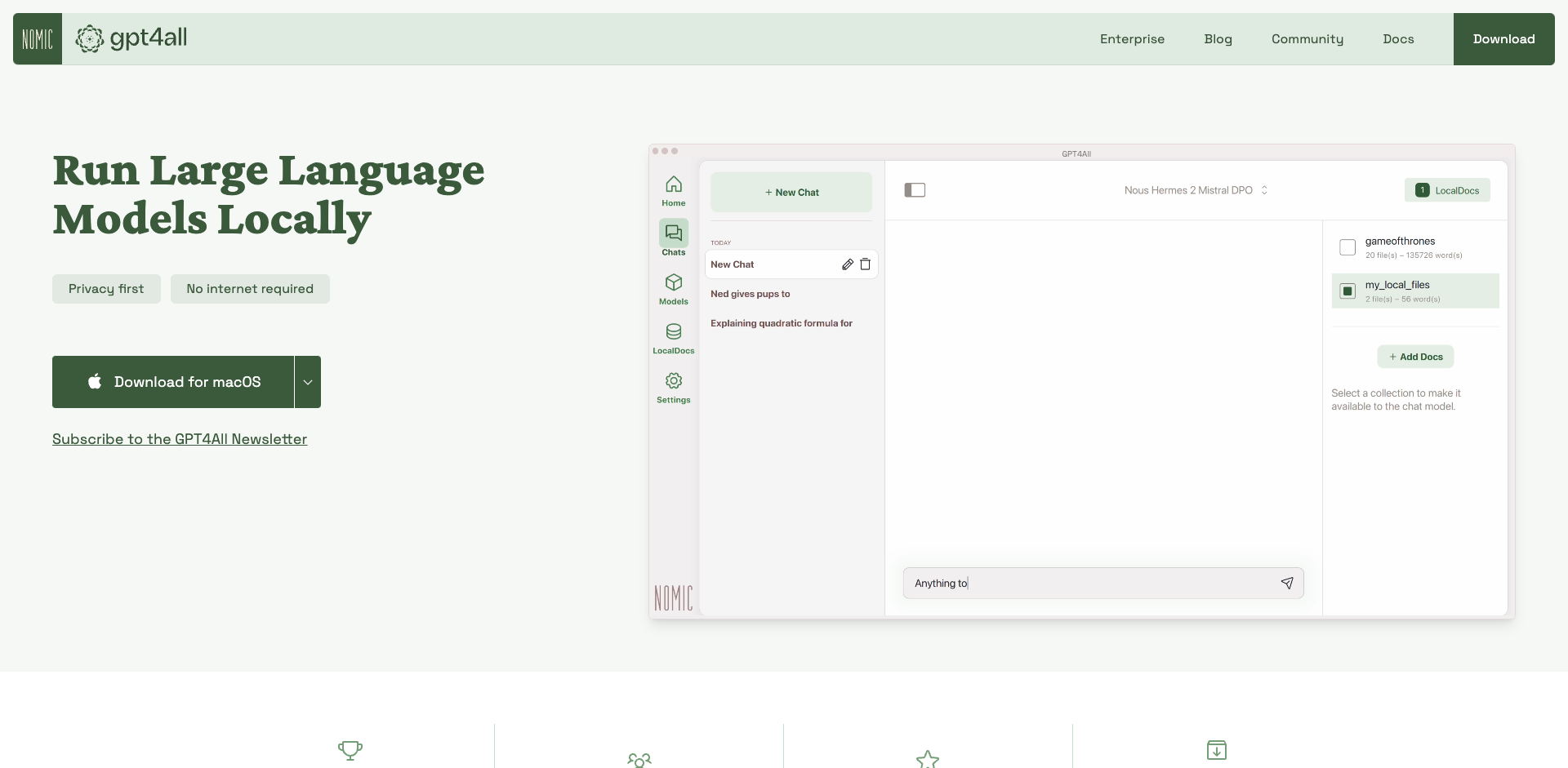

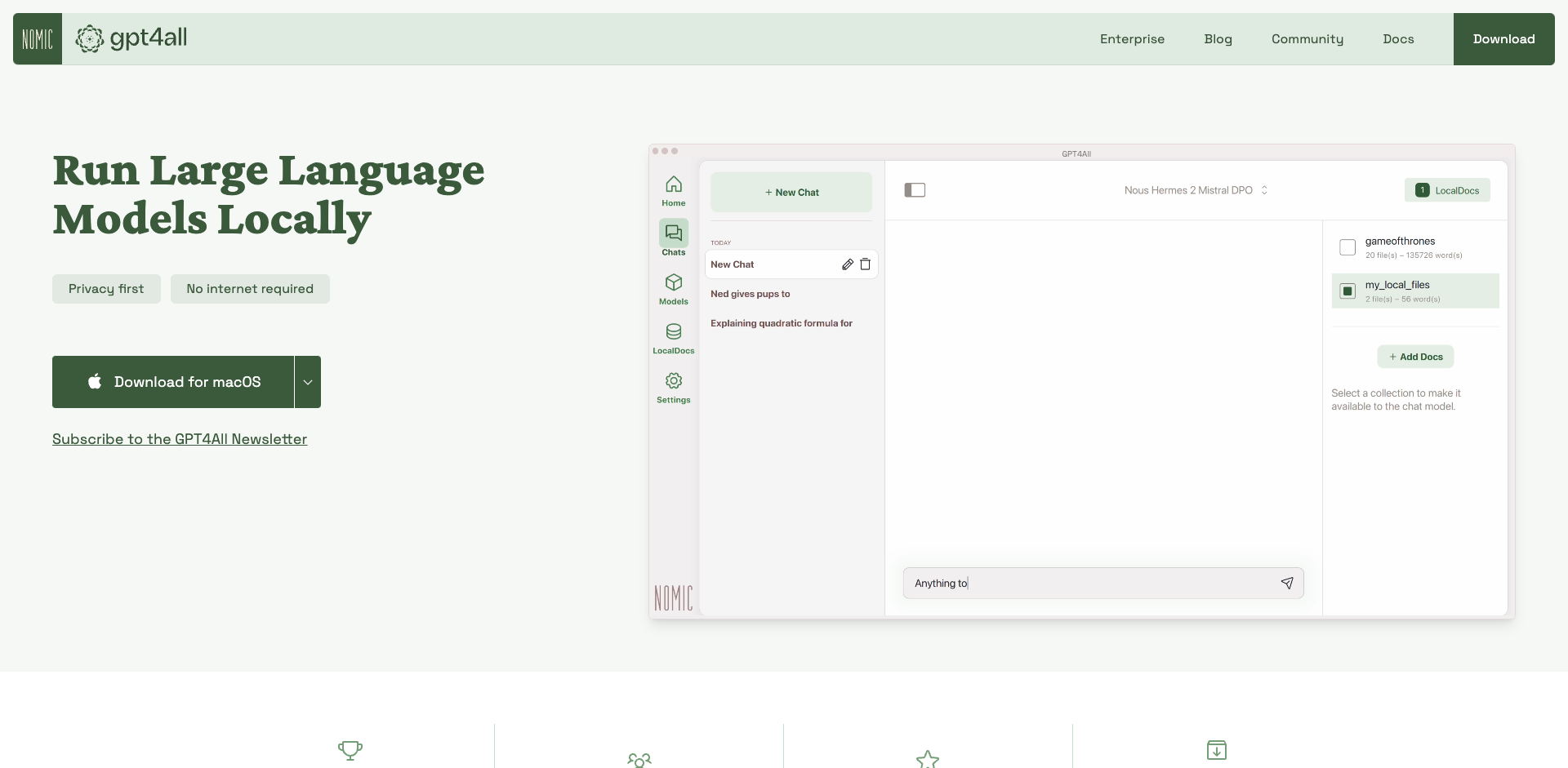

GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

2025-01-02

-

2025-01-02

-

wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

2025-01-02

-

Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

2025-01-02

-

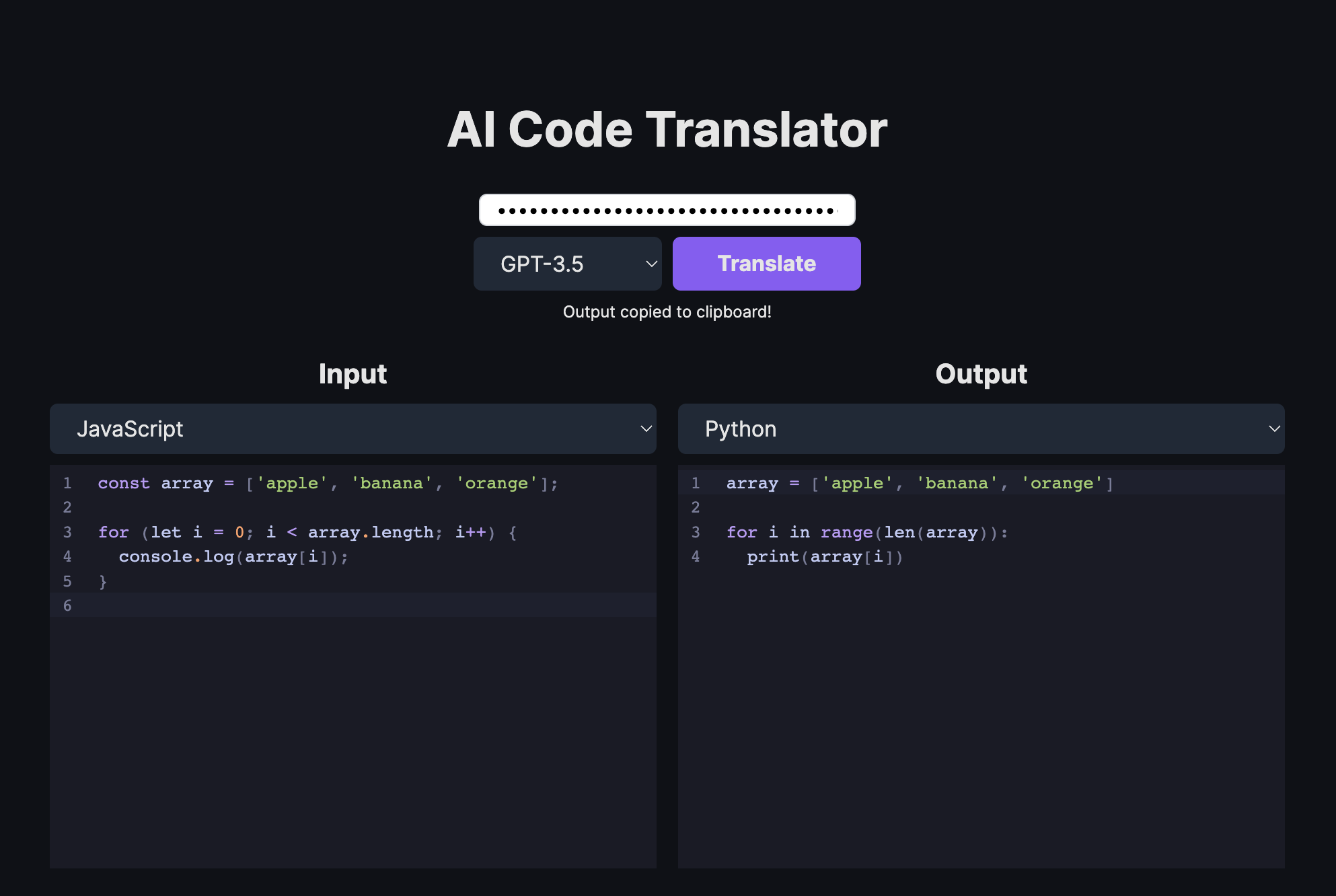

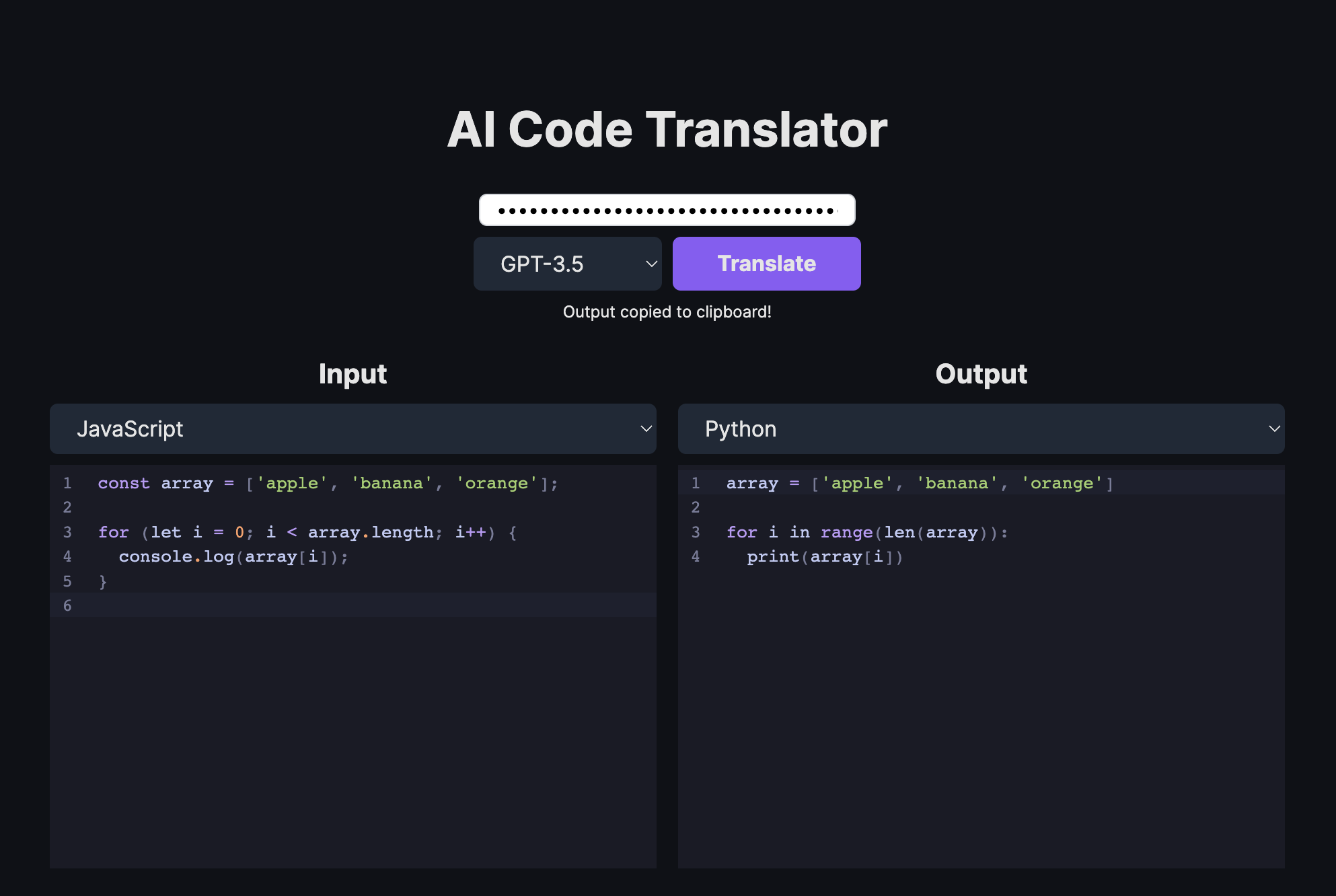

AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言

2025-01-02

热门文章

-

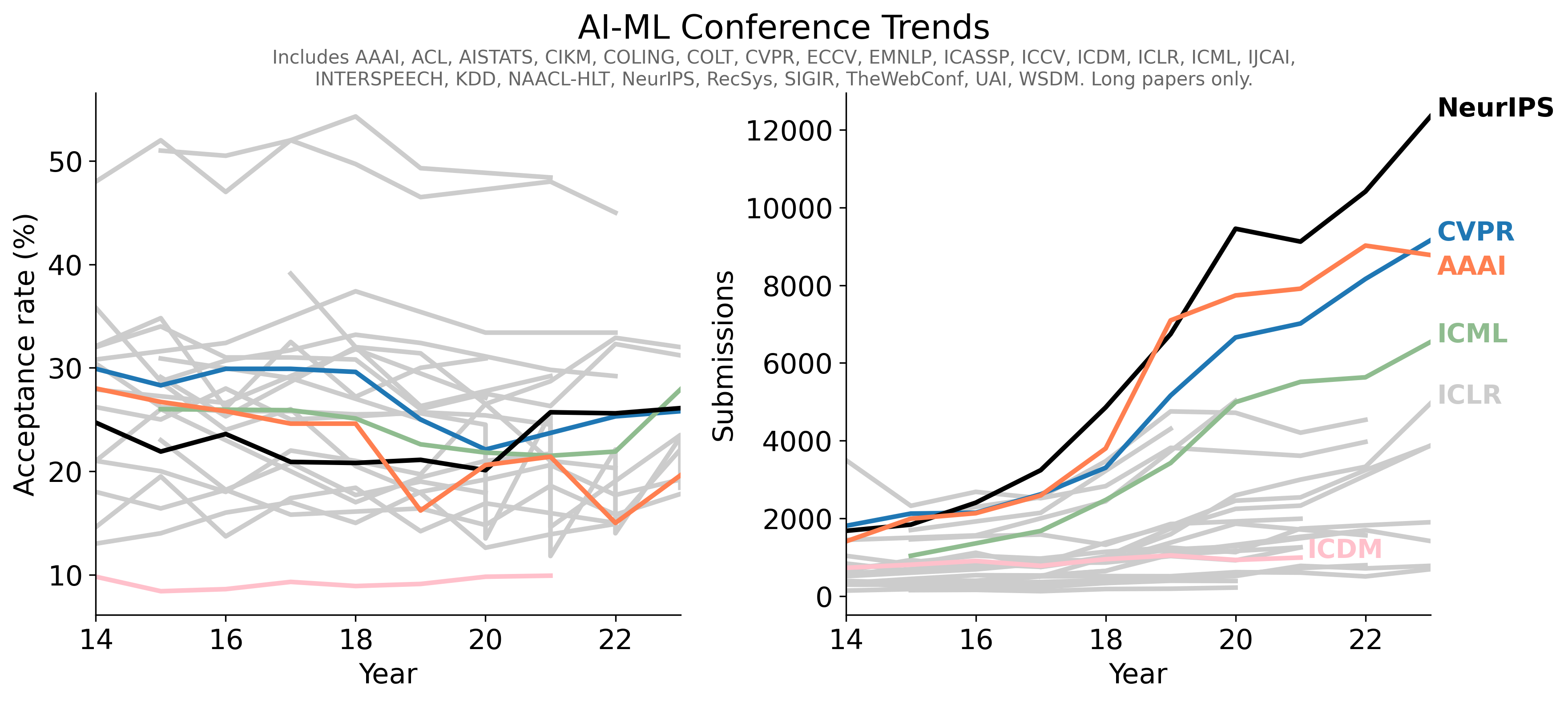

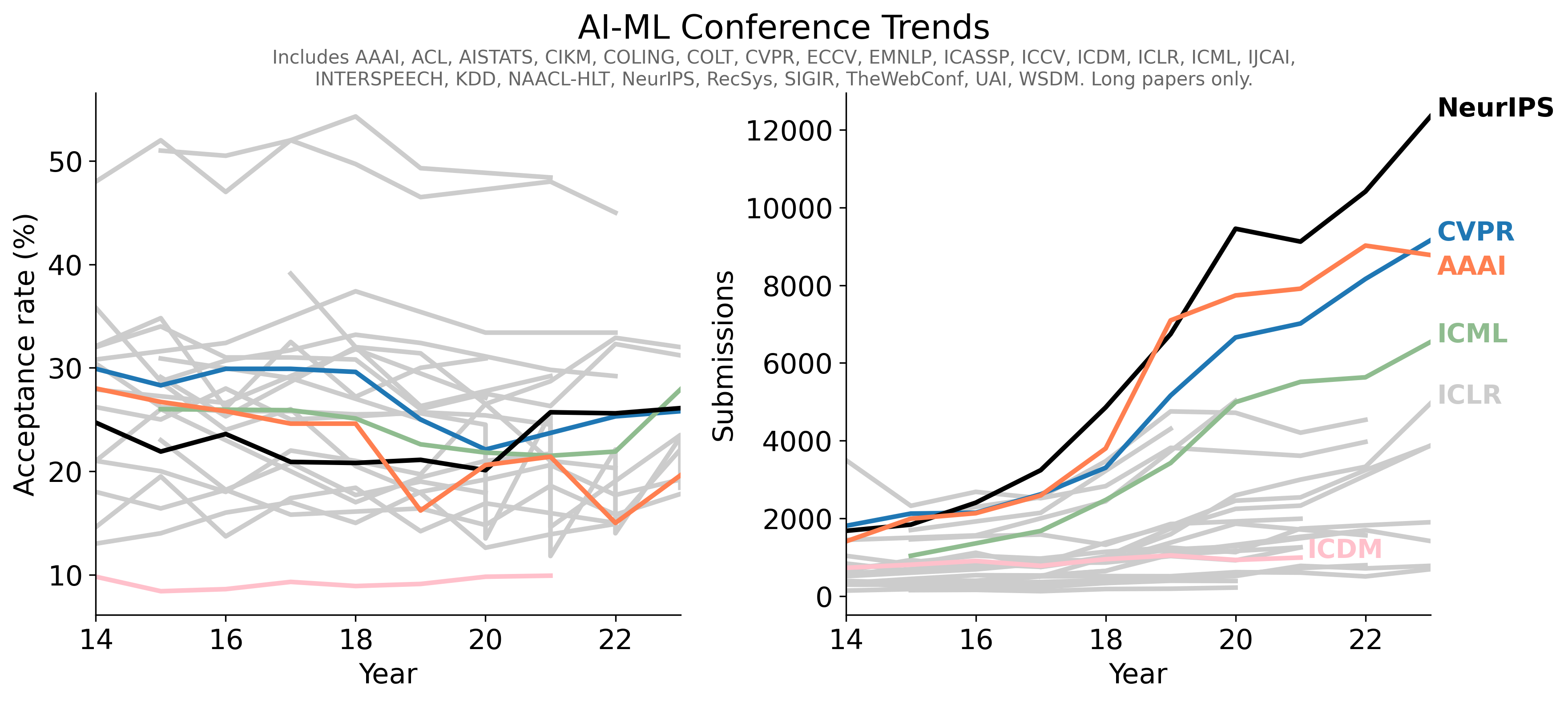

- 1Conference-Acceptance-Rate项目学习指南 - 人工智能顶级会议录用率数据汇总

- 2PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

- 3pot-desktop使用指南 - 跨平台划词翻译和OCR软件

- 4understand-prompt学习资料汇总 - AI助手的探索与应用

- 5GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

- 6law-cn-ai 入门指南 - AI 驱动的中国法律助手

- 7wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

- 8Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

- 9AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言