DeepSeek开源周第二天开源项目:Deepep

昨天是DeepSeek ai开源周第一天,开源的项目是FlashMLA,不到半小时,Github已经已经300多Star了,短短1小时就超过10W阅读,非常的火爆,今天是DeepSeek开源周的第二天,DeepSeek开源了第2个项目:Deepep。

什么是Deepep?

Deepep是一个用于MOE模型培训和推理的开源EP通信库。它基于先进的混合专家架构,充分利用了大规模数据集以提高其预训练和微调的有效性。DeepEP的设计导向是减少计算负担与内存使用,使得用户能够在常规硬件上有效运行大规模模型。

Deepep的功能特点

MoE架构优化:

DeepEP专为Mixture-of-Experts (MoE) 和专家并行 (EP) 设计,提供高效的all-to-all GPU内核,适用于训练和推理任务。

支持低精度运算,包括FP8和BF16,提升计算效率,节省显存。

高性能通信:

提供高吞吐量和低延迟的通信内核,支持NVLink和RDMA网络。在H800 GPU上测试,最大带宽可达153 GB/s (NVLink) 和46 GB/s (RDMA)。

针对NVLink到RDMA的非对称带宽转发场景进行了优化,确保高吞吐量表现。

低延迟通信:

提供纯RDMA的低延迟内核,特别适合推理解码阶段,延迟低至163微秒。

引入基于hook的通信-计算重叠方法,不占用GPU SM资源,最大化计算效率。

硬件优化:

利用未公开的PTX指令提升Hopper架构的性能。

支持InfiniBand网络,并理论上兼容RoCE,提供灵活的网络配置选项。

Deepep的应用场景

大规模模型训练:

适用于Mixture-of-Experts (MoE) 模型的训练,提供高效的并行通信支持,显著提升训练效率。

推理任务:

特别适合延迟敏感的推理解码场景,显著提升效率,降低延迟,提高推理吞吐量。

高性能计算需求:

完美适配现代高性能计算需求,支持多种硬件平台,包括Hopper GPU架构,未来可能扩展更多设备。

Deepep的使用与集成

易用性:

支持Hopper GPU架构,需要Python 3.8+、CUDA 12.3+和PyTorch 2.1+环境。

安装时需搭配团队修改版的NVSHMEM,安装指南详细。

集成方式:

开源且易于集成,只需几行命令即可构建并运行测试。

安装后导入deep_ep模块即可直接使用,提供示例代码和测试脚本。

DeepEP已在GitHub上开源,地址:https://github.com/deepseek-ai/DeepEP

1. DeepSeek开源周第一天开源项目:DeepSeekFlashMLA

- DeepSeek开源周第二天开源项目:Deepep

- Anthropic推出Claude Code:具备代码搜索、自动修改、测试、GitHub集成等功能

- 埃隆·马斯克的xAI Grok发布新Logo,非常惊艳!

- 阿里巴巴正式开源通义万相Wan2.1视频生成AI模型

- 清华大学《DeepSeek + DeepResearch让科研像聊天一样简单》PDF直接免费下载,没有套路

- DeepSeek开源周第三天开源项目:DeepGemm

- 如何用DeepSeek和即梦AI、可灵AI生成“快来惹毛我”毛绒玩偶风格视频

- 观心大模型:国内首个心血管专科医疗AI大模型

- 清华大学全部5份DeepSeek学习资料打包下载

- Raycast AI extension:可通过自然语言命令管理和执行任务的工具

-

tortoise-tts学习资料汇总 - 高质量多声音TTS系统

2024-12-31

-

-

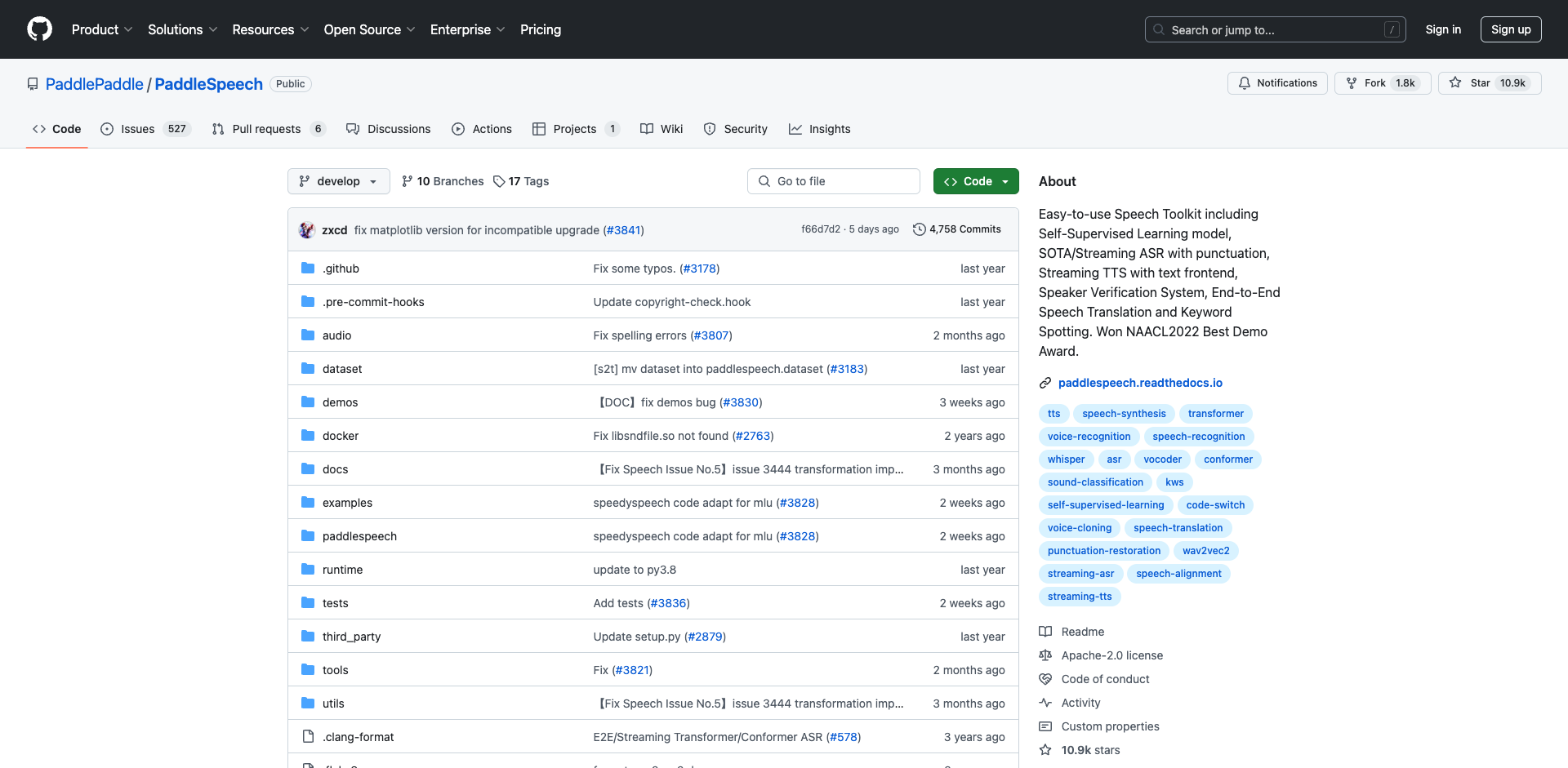

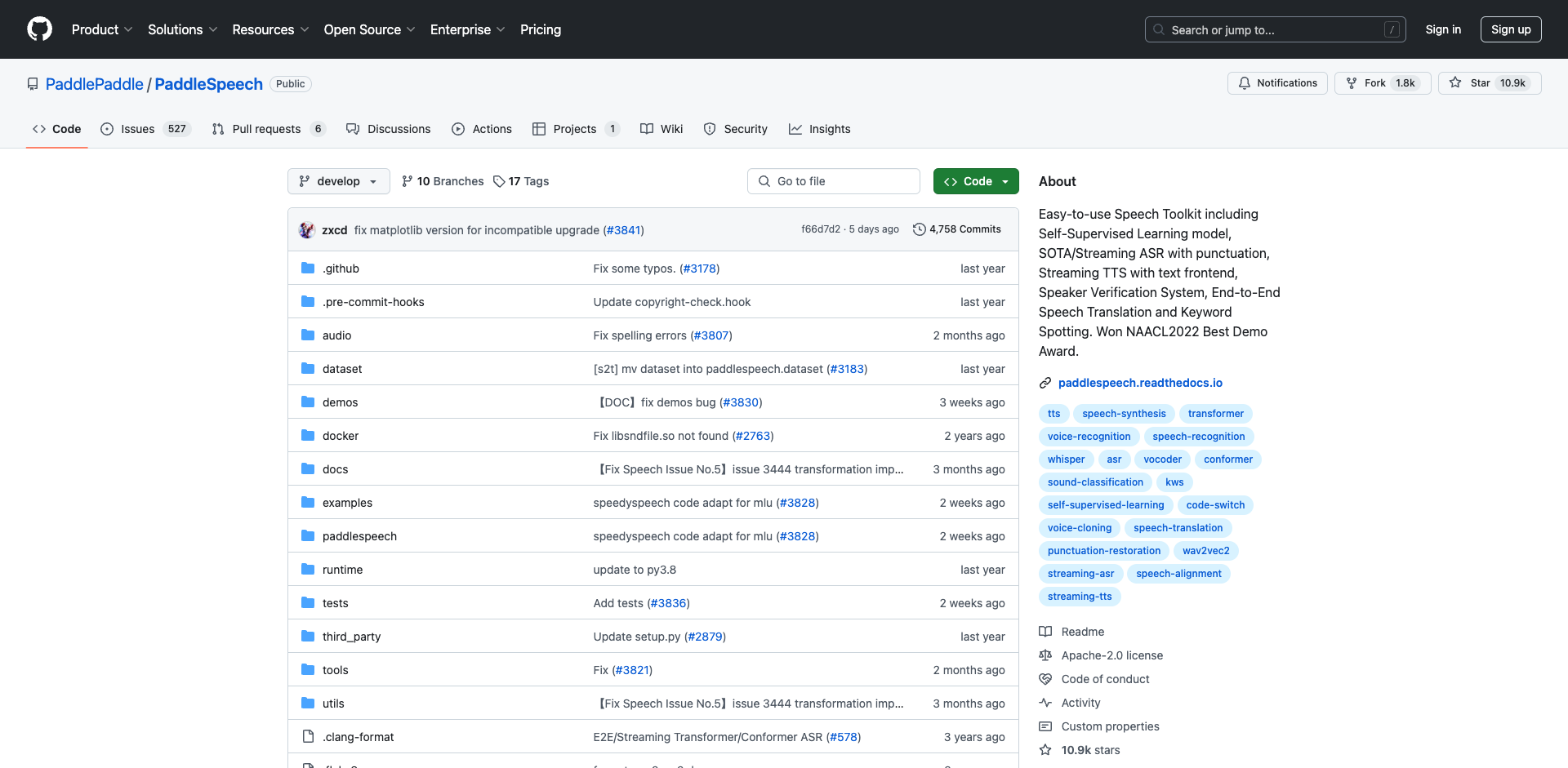

PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

2025-01-02

-

pot-desktop使用指南 - 跨平台划词翻译和OCR软件

2025-01-02

-

understand-prompt学习资料汇总 - AI助手的探索与应用

2025-01-02

-

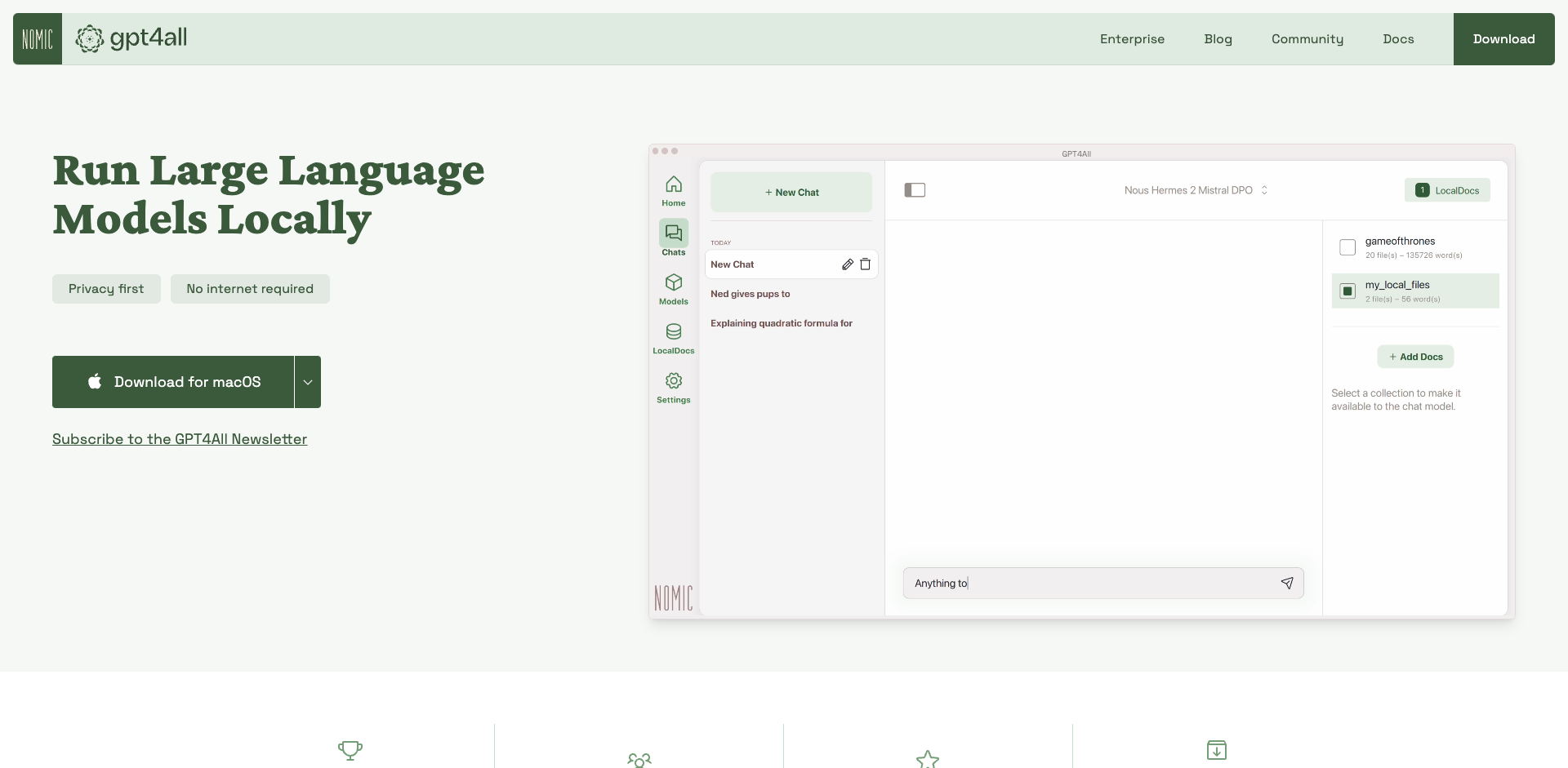

GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

2025-01-02

-

2025-01-02

-

wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

2025-01-02

-

Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

2025-01-02

-

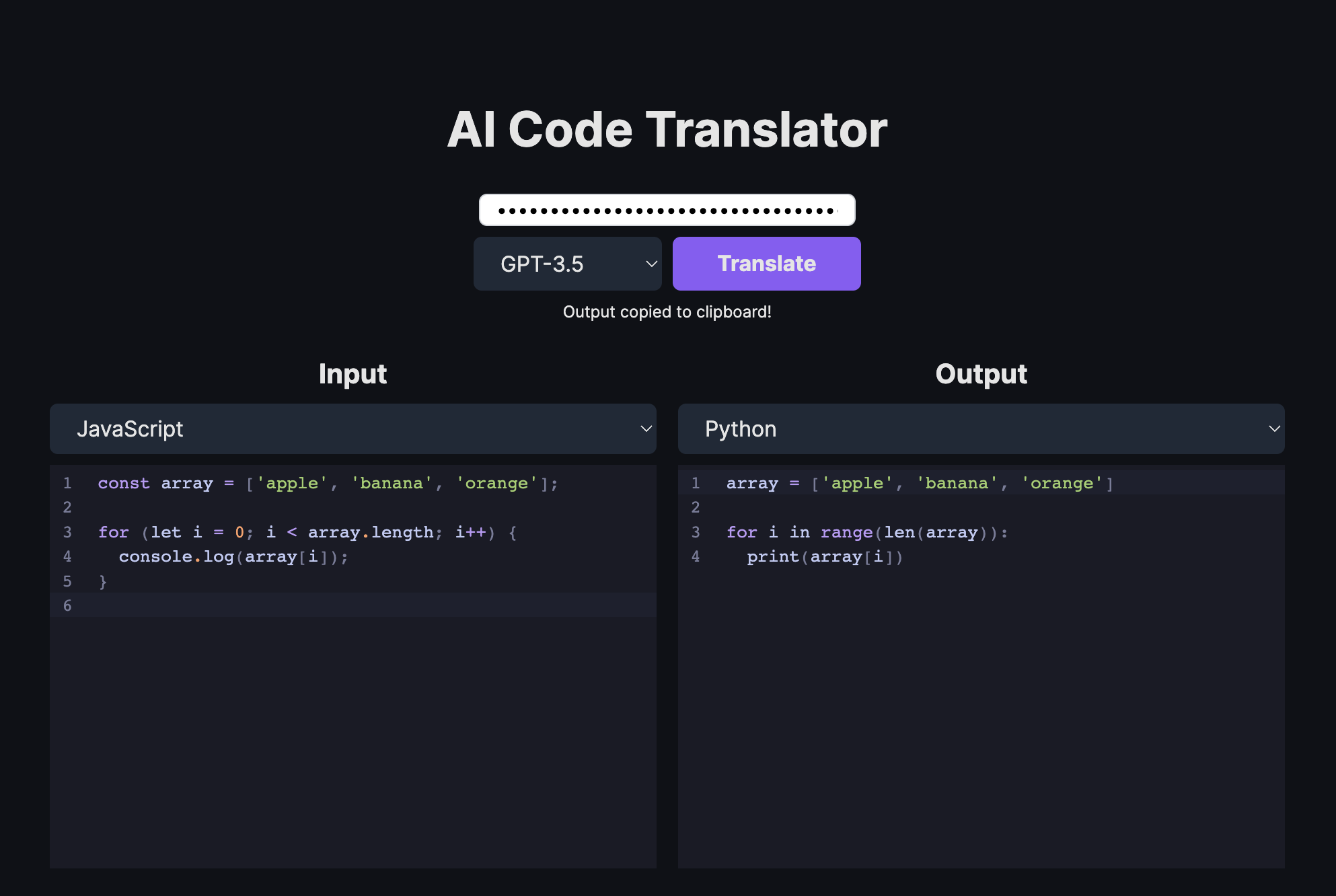

AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言

2025-01-02

-

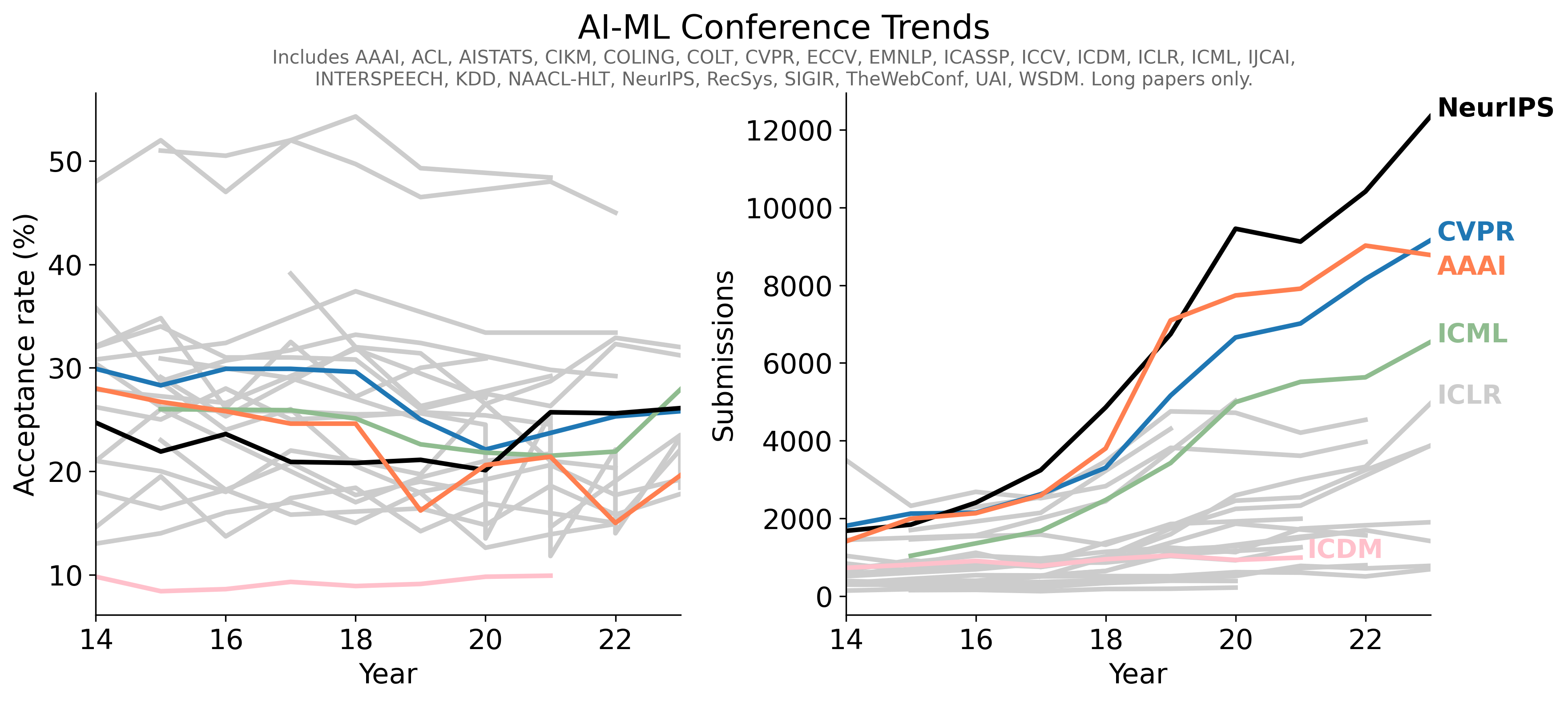

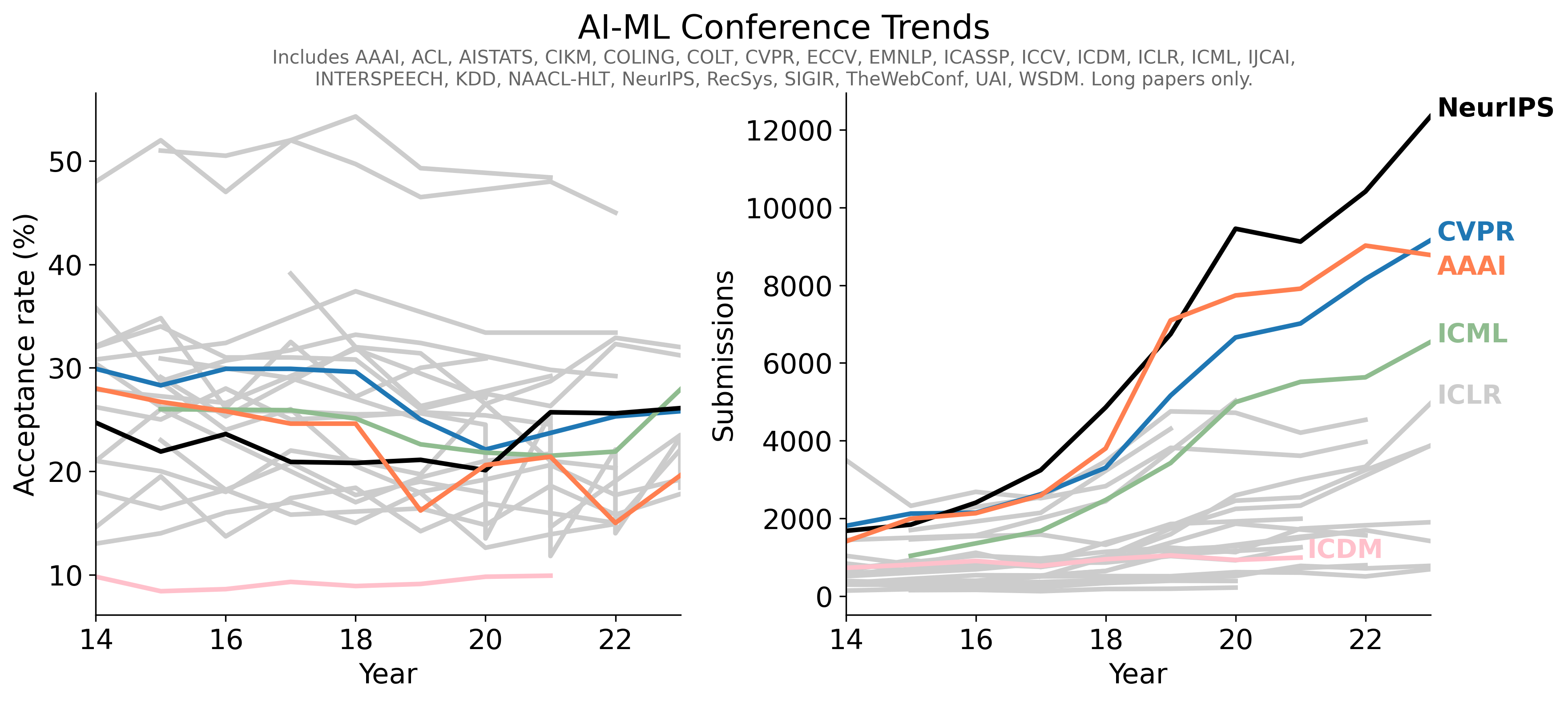

- 1Conference-Acceptance-Rate项目学习指南 - 人工智能顶级会议录用率数据汇总

- 2PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

- 3pot-desktop使用指南 - 跨平台划词翻译和OCR软件

- 4understand-prompt学习资料汇总 - AI助手的探索与应用

- 5GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

- 6law-cn-ai 入门指南 - AI 驱动的中国法律助手

- 7wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

- 8Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

- 9AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言