安装DeepSeek需要哪些配置,普通电脑可以吗?

安装和运行DeepSeek模型(如DeepSeek-R1或DeepSeek-Coder等)需要什么配置以及普通电脑是否也可以安装,这些取决于你的具体的使用场景和模型规模,以下为你列出不同场景下的配置要求:

一、基础配置(最低要求)

适用场景:运行轻量级模型(如7B以下参数的量化版本)、API调用或在线服务

CPU:四核以上(Intel i5或同等性能)

内存:8GB RAM(小型模型推理)

存储:10GB 可用空间(模型文件+系统)

网络:稳定互联网连接(若使用云端API)

系统:Windows 10+/macOS 10.15+/Linux(64位)

普通电脑可行性:✅ 完全可行

二、本地运行大模型(推荐配置)

适用场景:本地运行13B以上参数的模型(需量化或GPU加速)

CPU:Intel i7/Ryzen 7 或更高

内存:16GB RAM(13B模型) / 32GB+(更大模型)

GPU(可选):NVIDIA GTX 3060(8GB显存)或更高(显著提升推理速度)

存储:SSD硬盘,50GB+空间(原始模型较大)

系统依赖:Python 3.8+、PyTorch/CUDA(GPU版需安装驱动)

普通电脑可行性:⚠️ 部分可行(需中端配置,无GPU时速度较慢)

三、开发/训练需求

适用场景:微调(Fine-tuning)或训练模型

GPU:NVIDIA RTX 3090/4090 或 A100(24GB+显存)

内存:64GB+ RAM

存储:1TB NVMe SSD(大规模数据集)

普通电脑可行性:❌ 不推荐(需专业级硬件)

四、优化方案(低配电脑适配)

使用量化模型:选择4-bit/8-bit量化版本(如DeepSeek-Coder-33B-4bit),显存占用降低50%以上。

借助云服务:通过DeepSeek官方API或租用云GPU(如AutoDL、Google Colab)。

离线工具:使用llama.cpp等优化框架,纯CPU运行(速度较慢但内存需求降低)。

五、实际案例参考

轻薄本(无GPU):可运行DeepSeek-7B-4bit,占用约6GB内存,推理速度3-5词/秒。

游戏本(RTX 3060):流畅运行DeepSeek-13B-8bit,显存占用10GB,速度15+词/秒。

对于普通电脑,轻度使用(小模型/API调用)完全可行,大模型本地运行则需要中端配置,建议先从量化模型或API开始测试,再来根据需求升级硬件。

-

下一篇: 最后一页

-

tortoise-tts学习资料汇总 - 高质量多声音TTS系统

2024-12-31

-

-

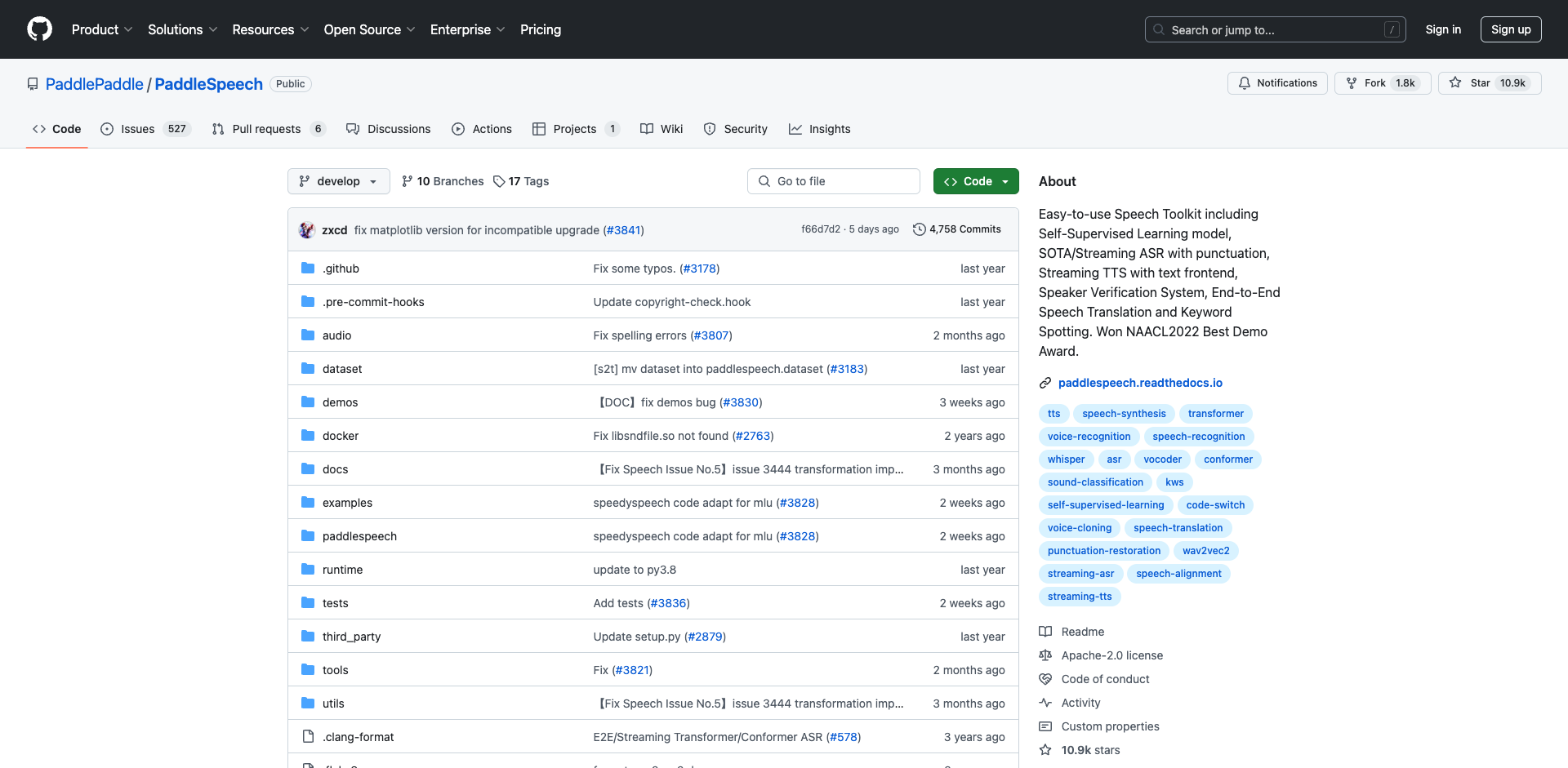

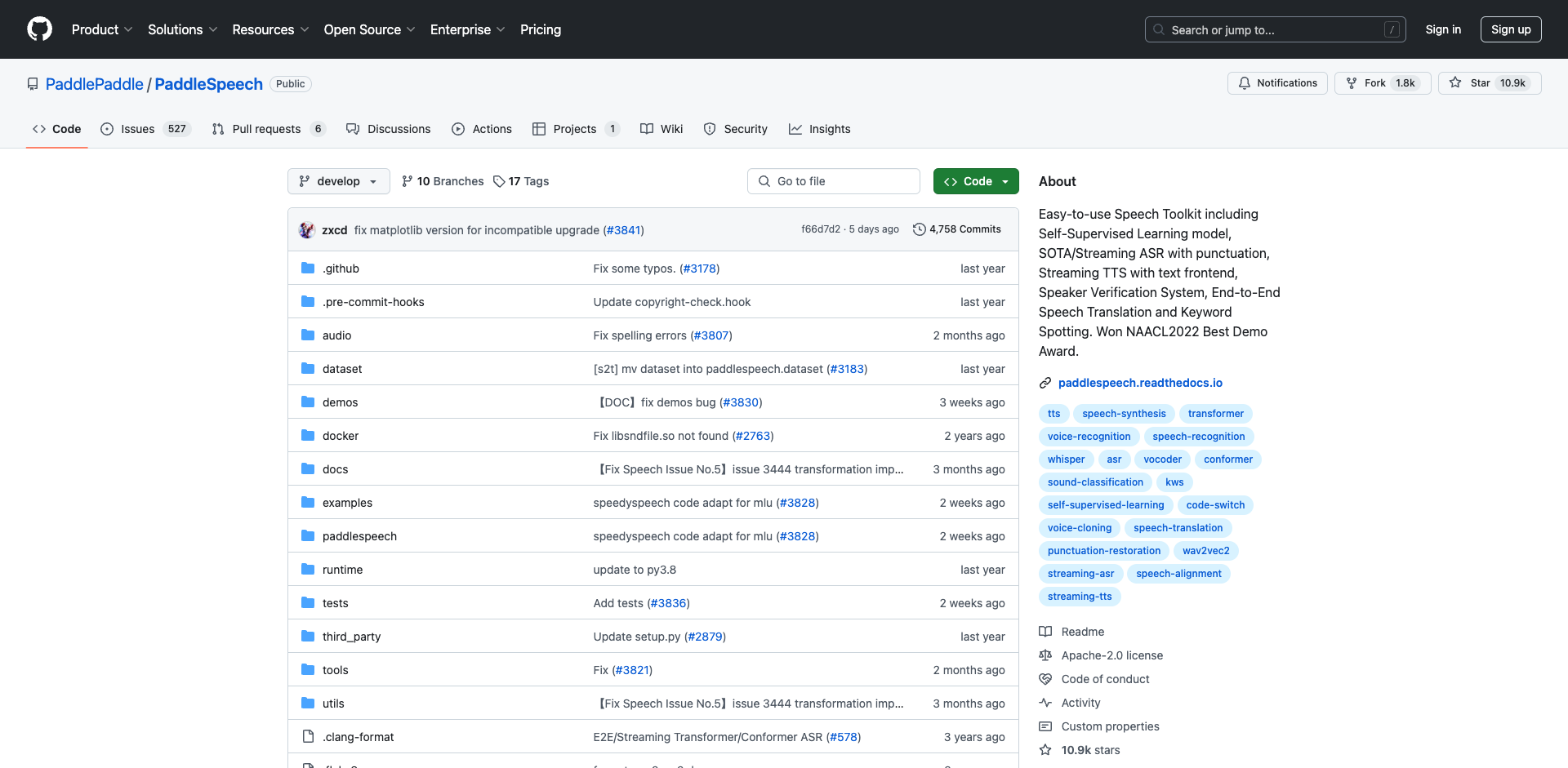

PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

2025-01-02

-

pot-desktop使用指南 - 跨平台划词翻译和OCR软件

2025-01-02

-

understand-prompt学习资料汇总 - AI助手的探索与应用

2025-01-02

-

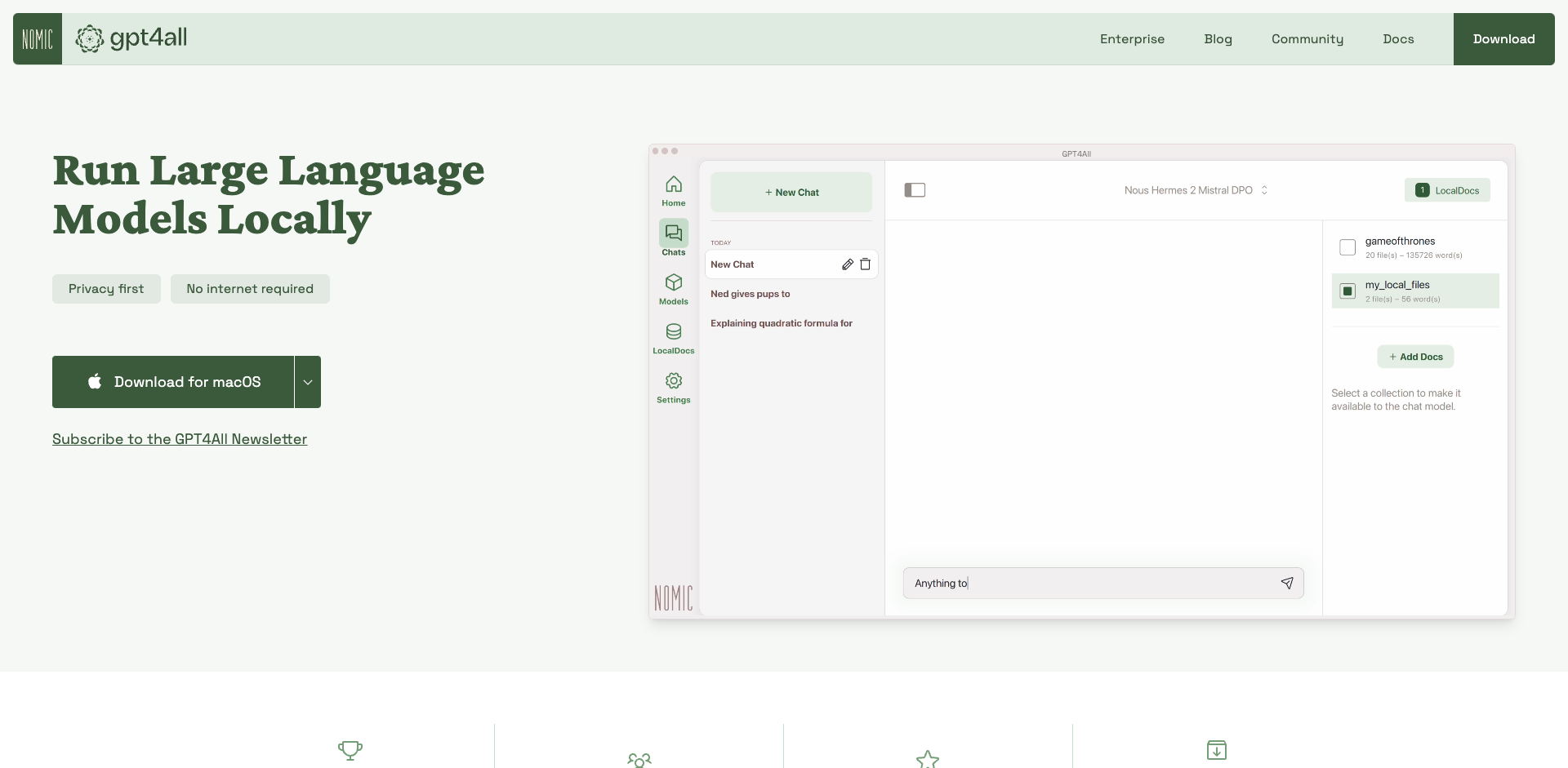

GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

2025-01-02

-

2025-01-02

-

wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

2025-01-02

-

Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

2025-01-02

-

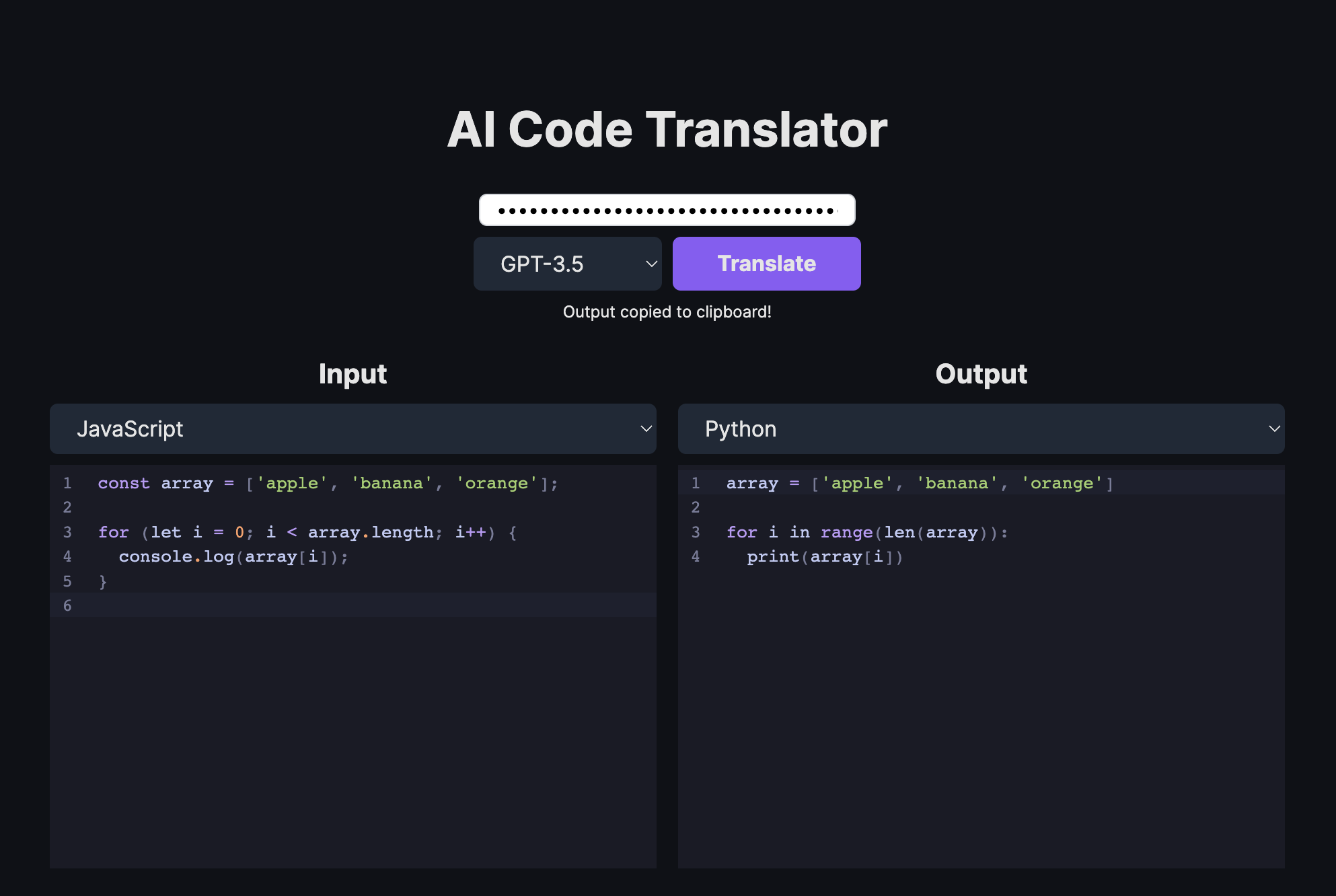

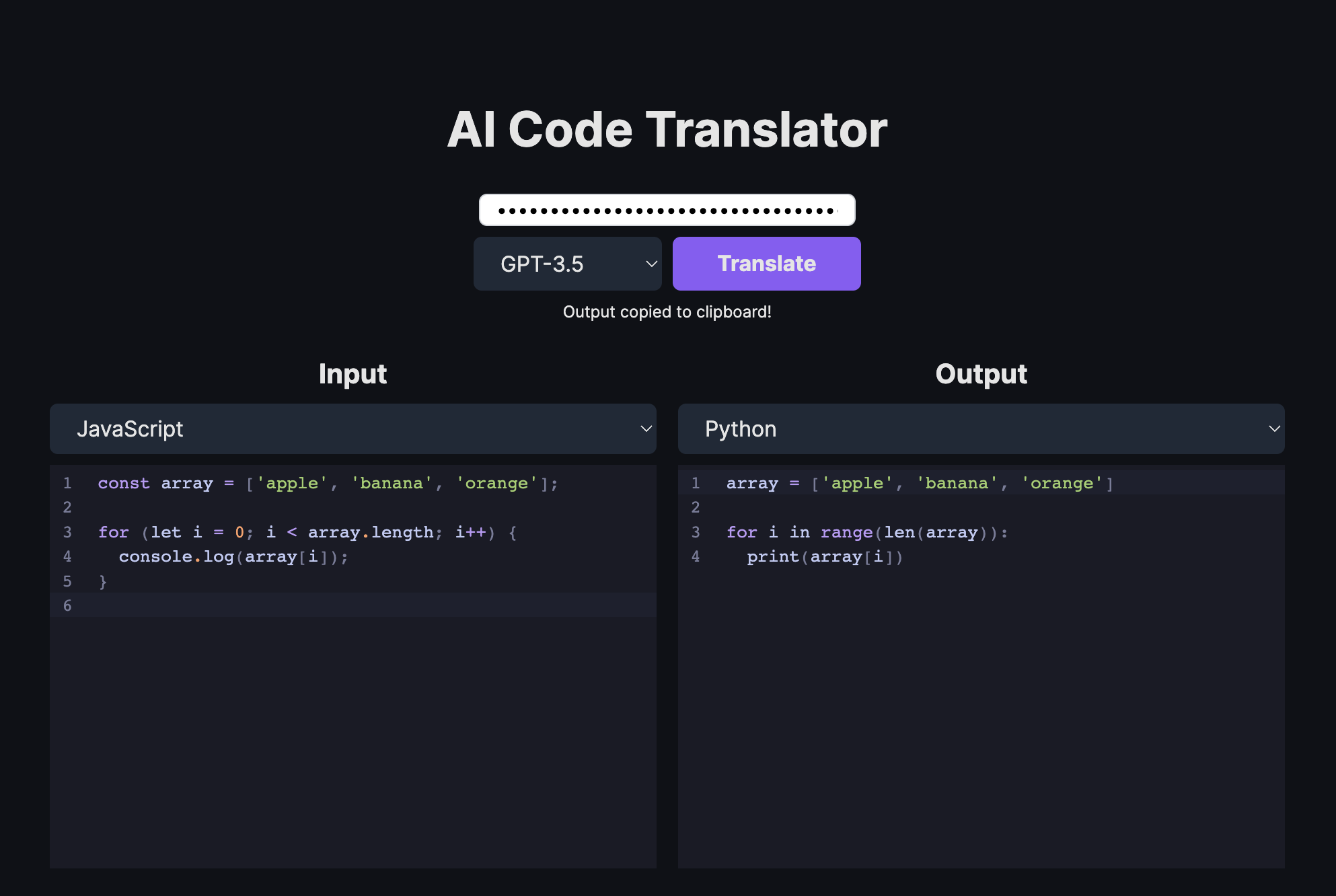

AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言

2025-01-02

-

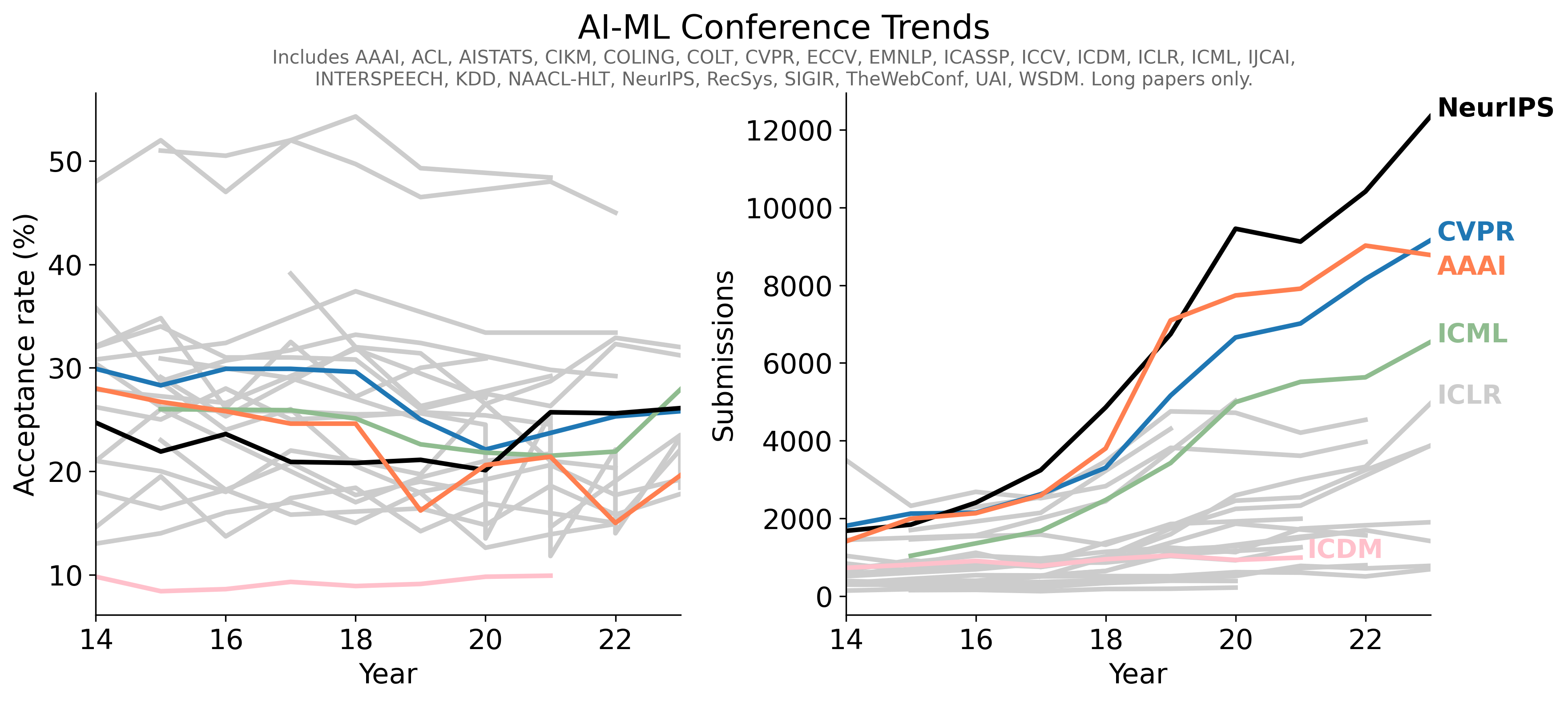

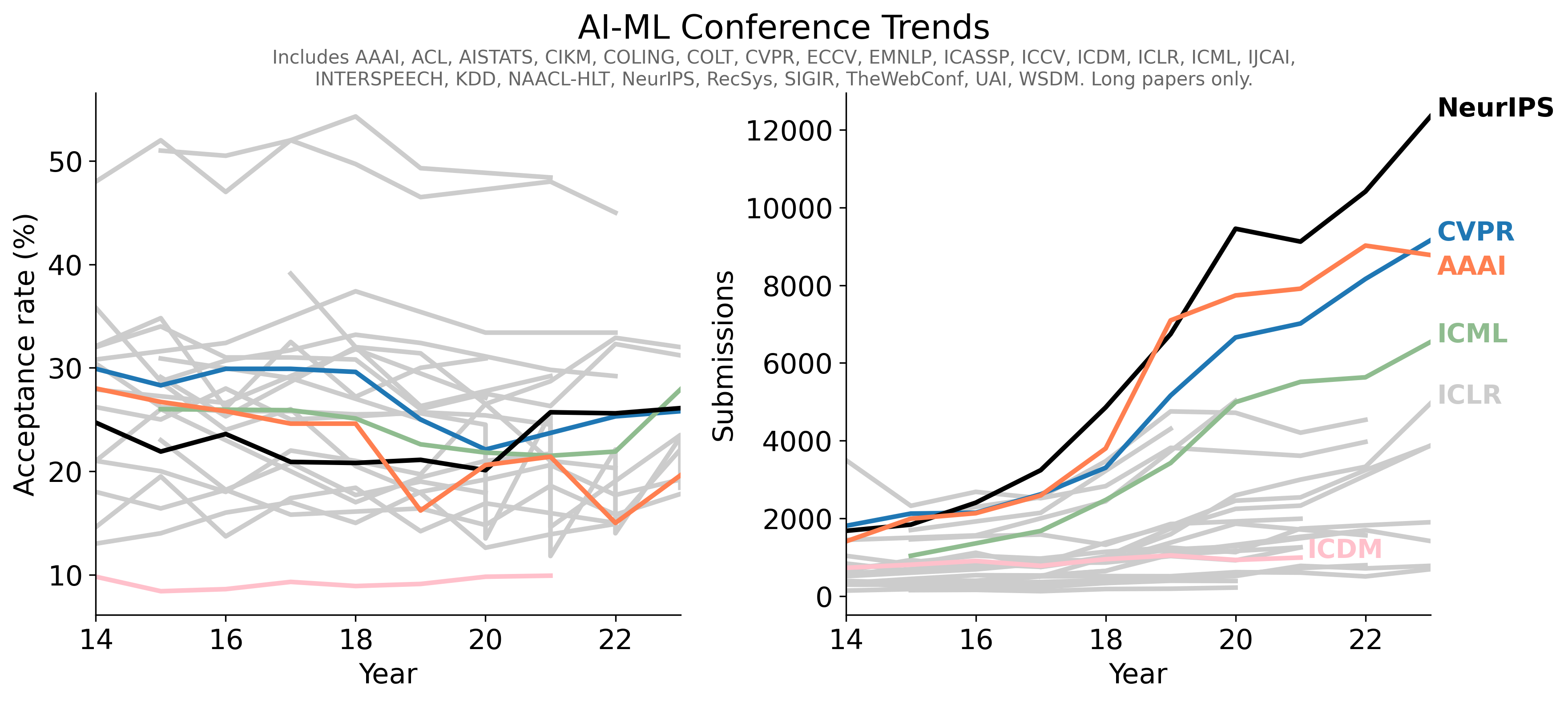

- 1Conference-Acceptance-Rate项目学习指南 - 人工智能顶级会议录用率数据汇总

- 2PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

- 3pot-desktop使用指南 - 跨平台划词翻译和OCR软件

- 4understand-prompt学习资料汇总 - AI助手的探索与应用

- 5GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

- 6law-cn-ai 入门指南 - AI 驱动的中国法律助手

- 7wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

- 8Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

- 9AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言