Privy: 开源本地运行的GitHub Copilot替代方案

Privy: 隐私优先的开源AI编码助手

在当今的软件开发领域,人工智能辅助编码工具已成为提高开发效率的重要手段。然而,许多主流工具如GitHub Copilot需要将代码上传到云端,这引发了隐私和安全方面的担忧。为解决这一问题,一款名为Privy的开源项目应运而生,它旨在提供一个本地运行、注重隐私的AI编码助手替代方案。

Privy的核心特性

Privy是一个开源项目,其核心目标是为开发者提供一个隐私优先、功能强大的AI编码助手。以下是Privy的主要特性:

开源透明: Privy的源代码完全开放,允许用户审查和贡献代码,确保其安全性和可信度。

隐私保护: 通过在本地运行AI模型,Privy确保用户的代码和数据不会离开本地环境,有效保护了开发者的隐私。

实时代码自动完成: Privy能够提供实时的代码建议和自动完成功能,帮助开发者更快速地编写代码。

AI驱动的对话: 开发者可以与AI进行对话,询问编程相关问题,获取代码解释、错误诊断等帮助。

多线程对话: 支持多个对话线程,方便开发者同时处理不同的编程任务或问题。

灵活的LLM支持: Privy可以与多种大型语言模型(LLM)集成,如DeepSeek Coder、CodeLlama和Mistral等。

技术实现与部署

Privy的核心是基于本地运行的大型语言模型。为了使用Privy,用户需要首先在本地部署一个LLM平台。目前,Privy推荐以下几种平台:

Ollama: 高度推荐的LLM运行平台llamafile: 实验性选项llama.cpp: 另一个实验性选项对于代码自动完成和AI对话功能,Privy建议使用不同的模型。例如,DeepSeek Coder系列模型在代码生成方面表现出色,而Mistral等模型则更适合用于对话任务。用户可以根据自己的硬件配置和需求选择适合的模型大小。

安装与配置

Privy主要以Visual Studio Code扩展的形式提供。用户可以通过以下方式安装:

在VS Code市场搜索并安装Privy扩展或者从Open VSX Registry安装安装完成后,用户需要在VS Code的设置中配置Privy:

设置LLM提供者(默认为Ollama)配置LLM提供者的URL选择用于代码自动完成和对话的模型调整自动完成的触发时间等参数

使用技巧

为了充分发挥Privy的潜力,开发者可以参考以下使用技巧:

明确具体: 在请求代码更改或提问时,尽量提供具体的名称和期望结果。

提供上下文: 在基本问题中包含编程语言信息或其他相关背景。

谨慎验证: 虽然Privy能够回答问题,但对于不太常见的话题或复杂的问题,答案可能不够准确,需要开发者自行验证。

合理使用对话线程: 为不同主题使用独立的对话线程,有助于AI更准确地回答问题。

社区贡献

作为一个开源项目,Privy欢迎社区成员的贡献。开发者可以通过以下方式参与:

提交bug报告或功能建议贡献代码改进完善文档帮助回答其他用户的问题项目维护者为新手贡献者标记了一些"good first issues",这些是很好的入门任务。

未来展望

随着AI技术的不断进步,Privy有望在以下方面继续发展:

支持更多编程语言和框架: 扩大对各种编程语言和流行框架的支持范围。

增强本地化能力: 提供更多语言的本地化支持,使全球开发者都能方便使用。

改进AI模型: 随着本地AI模型的进步,提供更准确、更智能的代码建议和对话能力。

扩展IDE支持: 除VS Code外,考虑支持其他流行的集成开发环境。

增强协作功能: 探索在保护隐私的前提下,实现团队协作的AI辅助功能。

结语

Privy作为一个开源的、注重隐私的AI编码助手,为开发者提供了一个强大的GitHub Copilot替代方案。通过本地运行AI模型,Privy不仅保护了代码的隐私和安全,还为开发者提供了灵活可控的AI辅助编码体验。随着项目的不断发展和社区的积极参与,Privy有望成为推动开源AI编码助手发展的重要力量,为软件开发行业带来更多创新和价值。

- Privy: 开源本地运行的GitHub Copilot替代方案

- OpenAI 发布了三款全新语音模型,包括两款语音转文本模型以及一款文本转语音模型

- Math.NET Numerics: 强大的 .NET 数值计算库

- Ethereal Engine: 开创未来的开源元宇宙平台

- OpenAI语音模型GPT-4o-transcribe、GPT-4o-mini-transcribe和GPT-4o-mini-tts的特点、定价和使用场景

- libsurvive: 开源灯塔追踪系统

- 邮件应用新纪元:Nextcloud Mail全面解析

- 推荐10款优秀的免费、开源AI Agent框架

- MusicInfuser:一个可以根据音乐和文本生成舞蹈视频的模型

- StarVector:用于生成可缩放矢量图形的开源多模态视觉模型

-

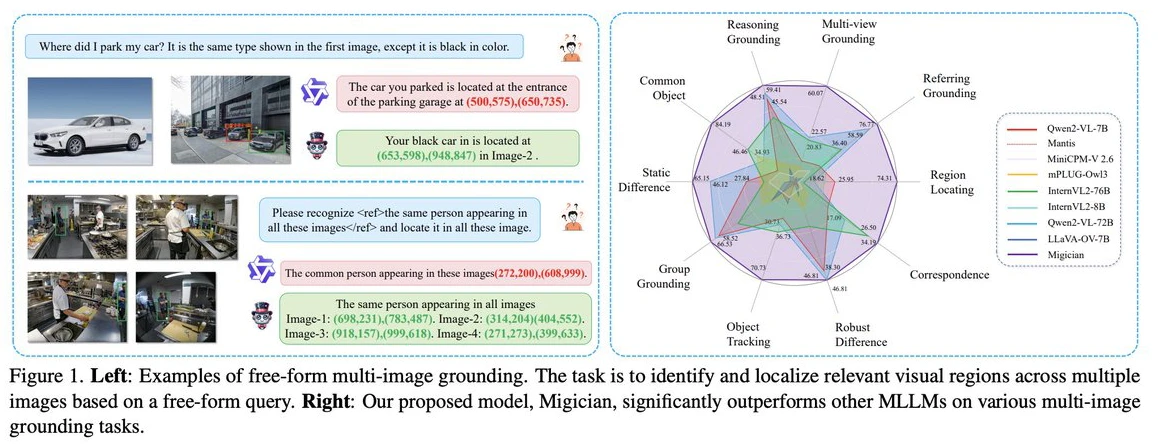

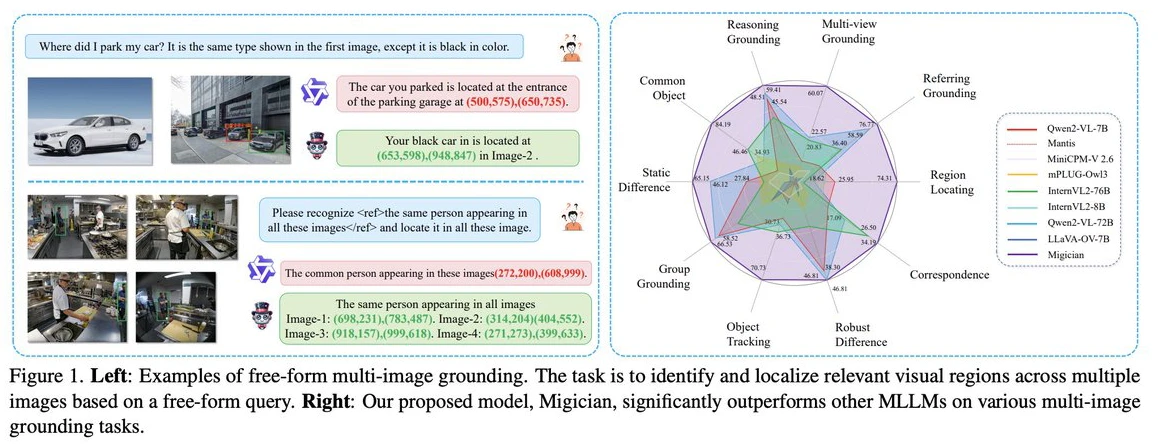

Migician:清华大学等团队出的解决复杂场景下的多图像目标定位问题的多模态模型

2025-03-11

-

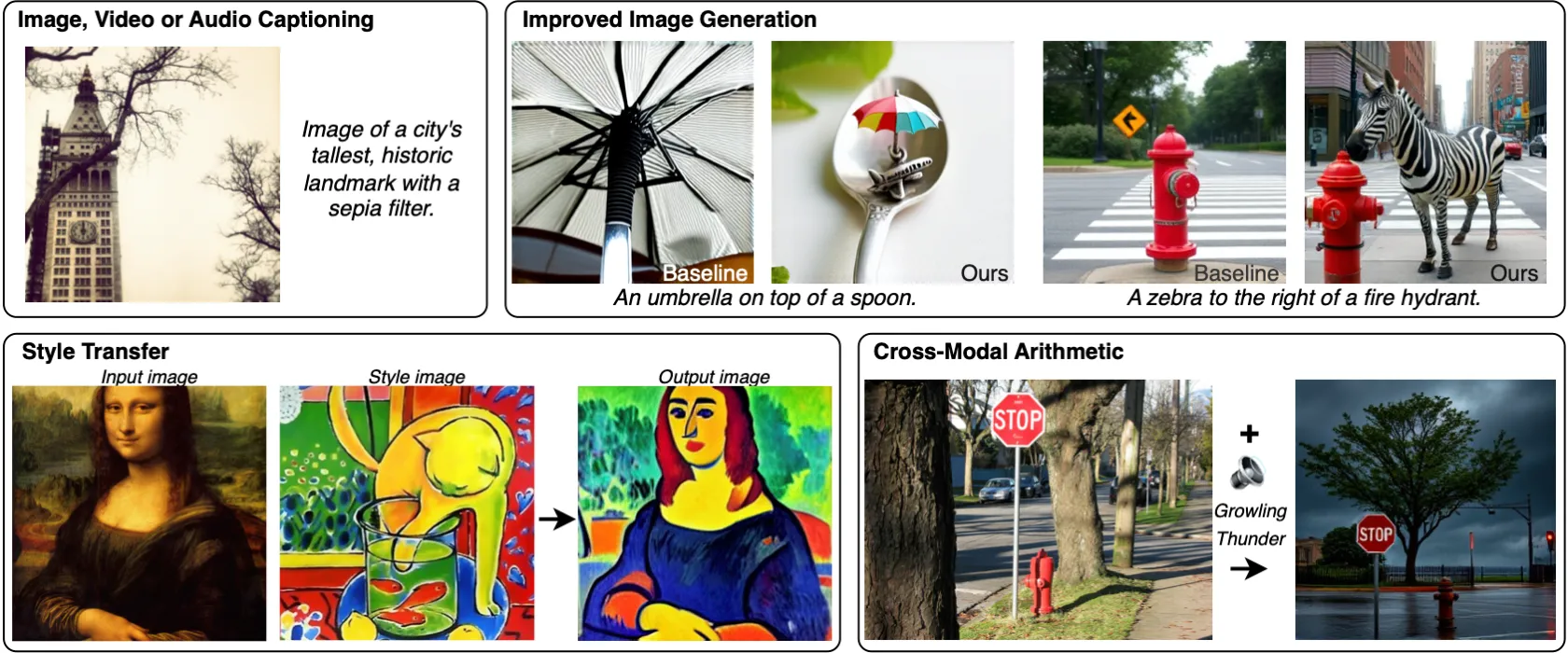

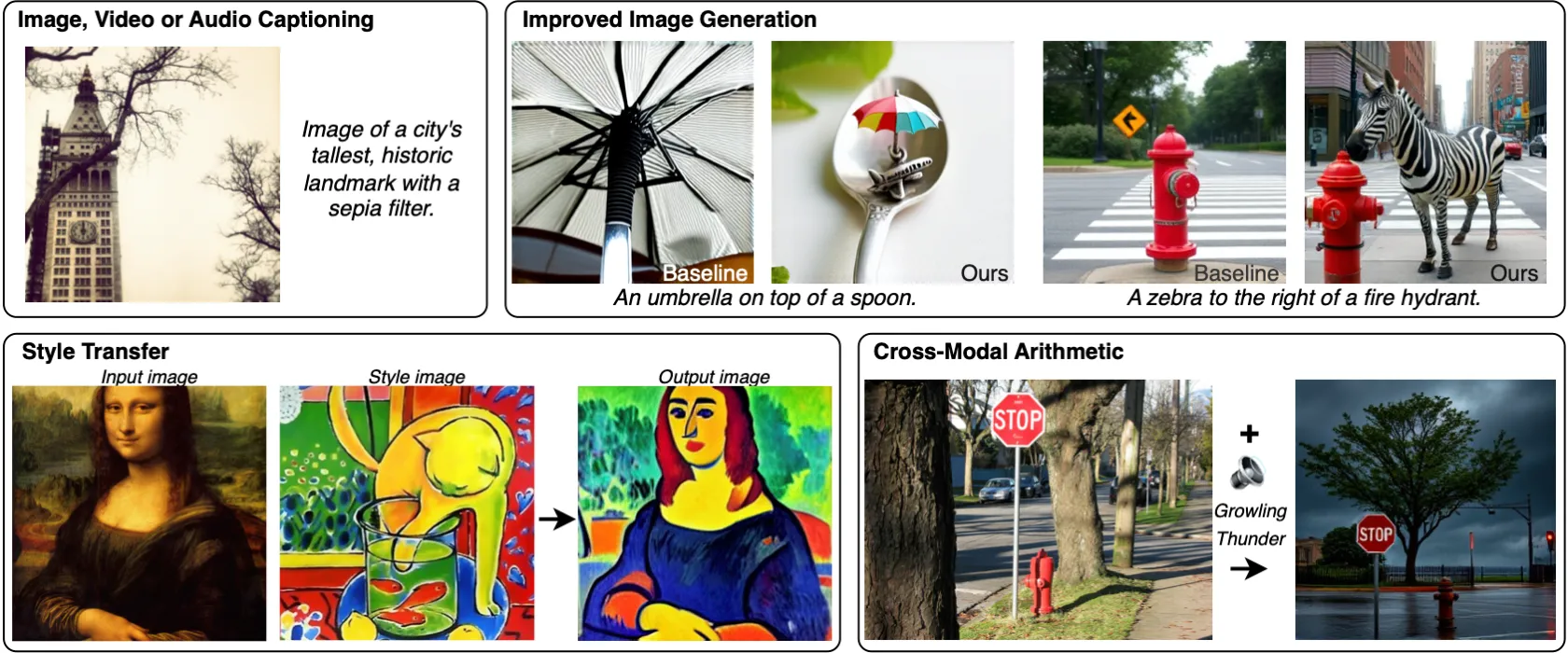

MILS:Meta发布的无需训练就能让LLM获得多模态能力的方法

2025-03-28

-

2025-04-14

-

Gemini 2.5 Pro与Gemini 2.5相比较,有哪些提升?

2025-04-29

-

2025-02-24

-

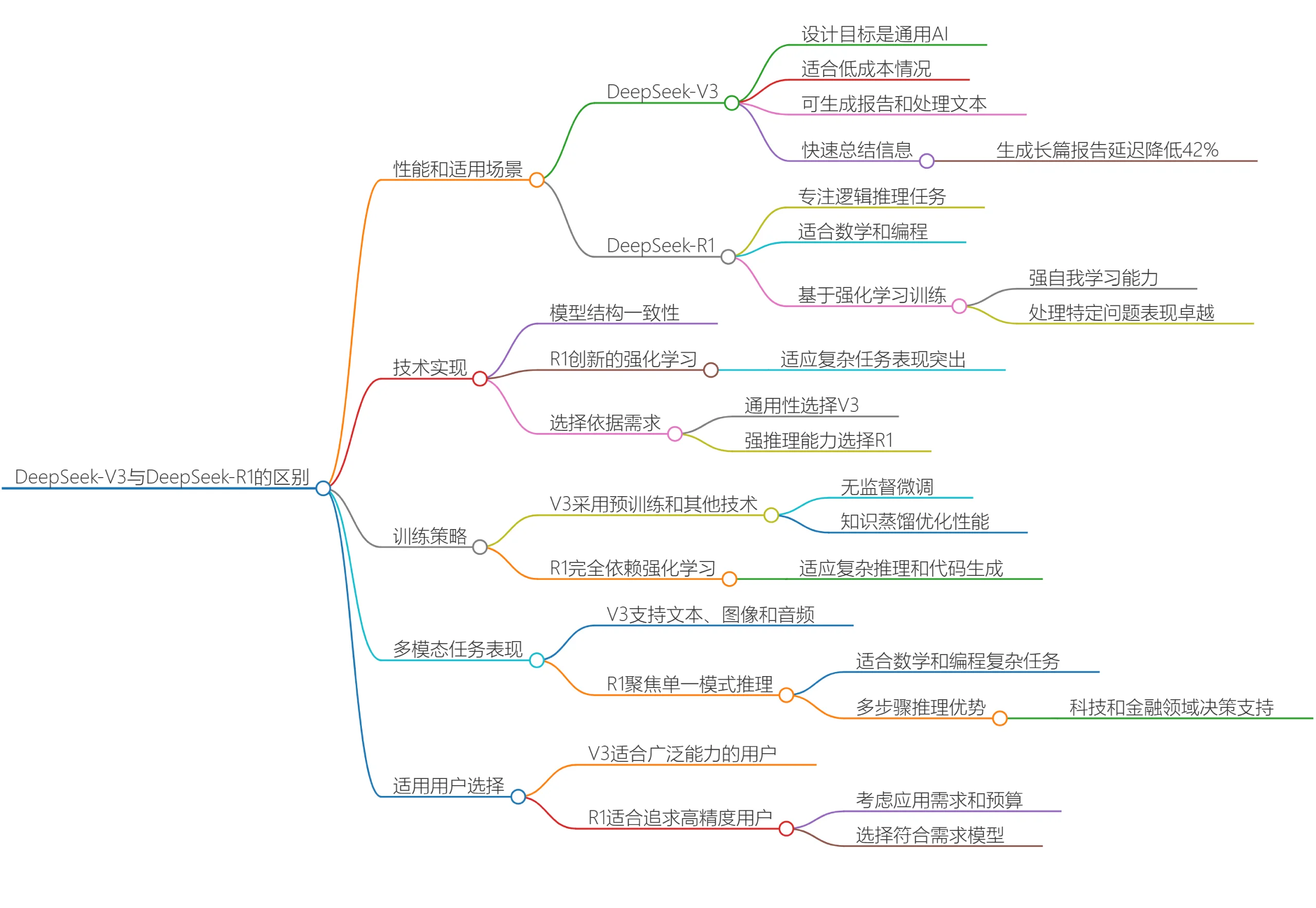

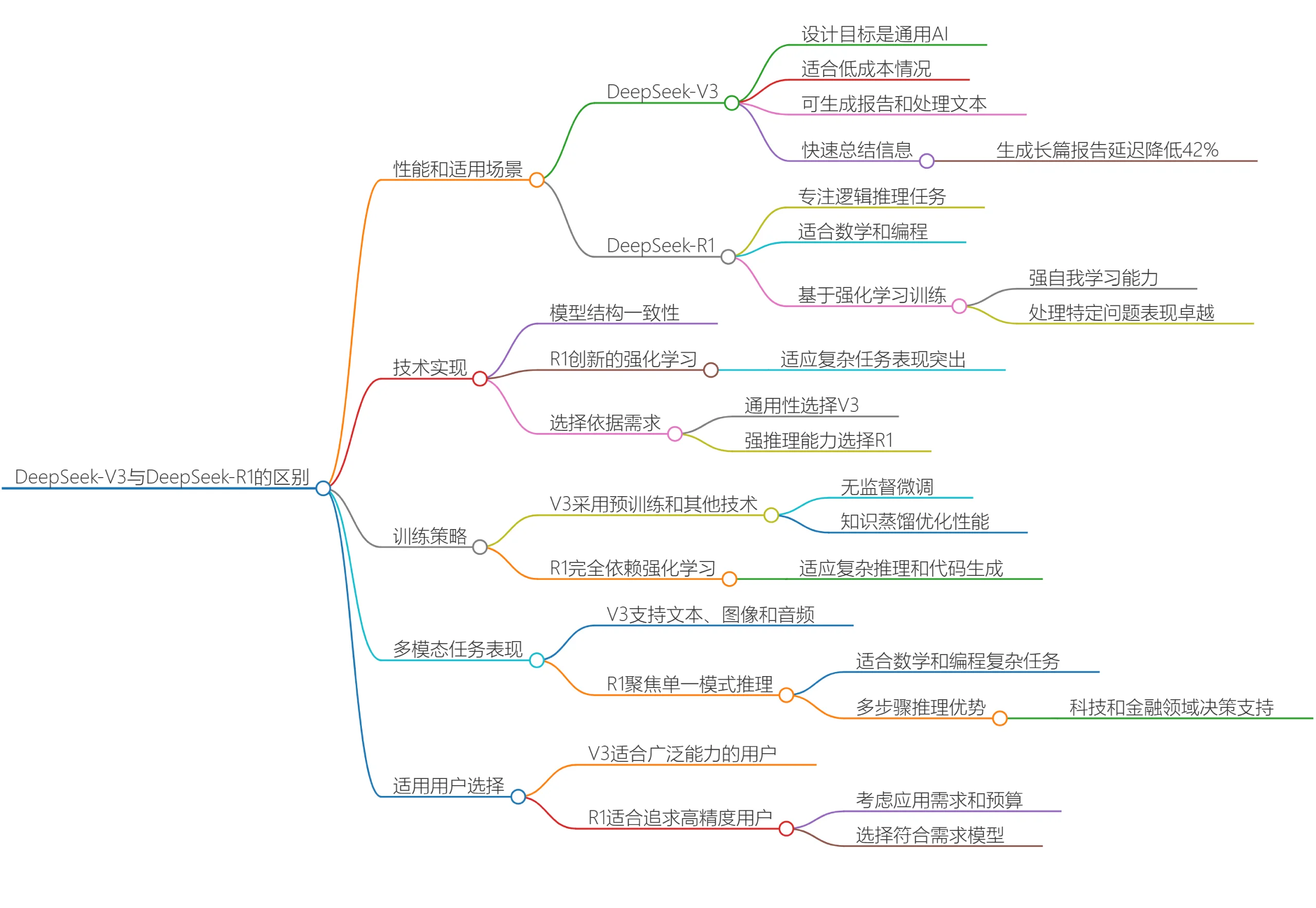

DeepSeek V3和DeepSeek R1有什么区别?哪个更适合你呢?

2025-03-20

-

2025-04-05

-

2025-04-21

-

文生图模型Ideogram 2A:更快的生成速度和更低的成本

2025-03-12

-

2025-03-28