FastMCP:用于构建MCP服务器的开源Python框架

FastMCP是什么?

FastMCP 是一个开源的Python 框架,专注于让 MCP 服务器和客户端的搭建变得更简单。它用简洁的装饰器语法,大大减少了冗余代码,还支持智能体和组合 MCP 服务器,能轻松应对复杂应用的开发需求。FastMCP 与 OpenAPI 和 FastAPI 深度集成,让现有的 API 转变为 MCP 服务变得轻而易举。它还具备图像处理能力,客户端功能也很完善。安装时推荐用 uv,开发和使用起来都很方便,特别是搭配 Claude Desktop,体验感更佳。

FastMCP功能特色

快速开发:提供高层级接口,开发者不需要处理复杂的协议细节和服务器管理,减少了编写代码的工作量。

简单易用:仅需少量的样板代码即可构建 MCP 服务器,开发者可以通过装饰器的方式,轻松定义工具、资源和提示,大大减少了冗余代码。

Pythonic 风格:充分利用了 Python 的语言特性,让代码编写更加符合 Python 的编程习惯。

功能完整:提供对 MCP 核心规范的完整实现,目前核心功能已经能够满足大多数开发需求,并仍处于活跃开发中。

FastMCP核心组件

工具(Tools):定义 LLM 可执行的操作(如计算、API 调用),支持同步和异步函数。

资源(Resources):提供结构化数据访问(如配置信息、用户数据),支持动态路径参数。

上下文(Context):内置日志记录、进度报告、资源读取等能力,增强交互控制。

提示(Prompts):可复用交互模板,指导 LLM 更高效地使用工具。

优势

快速开发:通过高级接口,减少代码量,加速开发。

简洁易用:使用最少的样板代码构建 MCP 服务器。

Pythonic:符合 Python 开发者的习惯。

完整实现:全面支持 MCP 核心规范。

FastMCP使用场景

ai 助手工具集:为 AI 助手提供本地功能扩展。

数据库交互:安全地暴露数据库查询功能。

文件处理:读取和处理本地文件。

API 集成:将现有 API 包装为 AI 可用的工具。

智能客服:可以使用 FastMCP 构建服务器,为客服人员提供快速查询知识库、调用数据分析工具等功能

数据分析:通过 FastMCP 将各种数据分析工具集成到 LLM 中,让用户能够更方便地进行数据处理和分析

FastMCP安装与运行

1. 安装依赖:

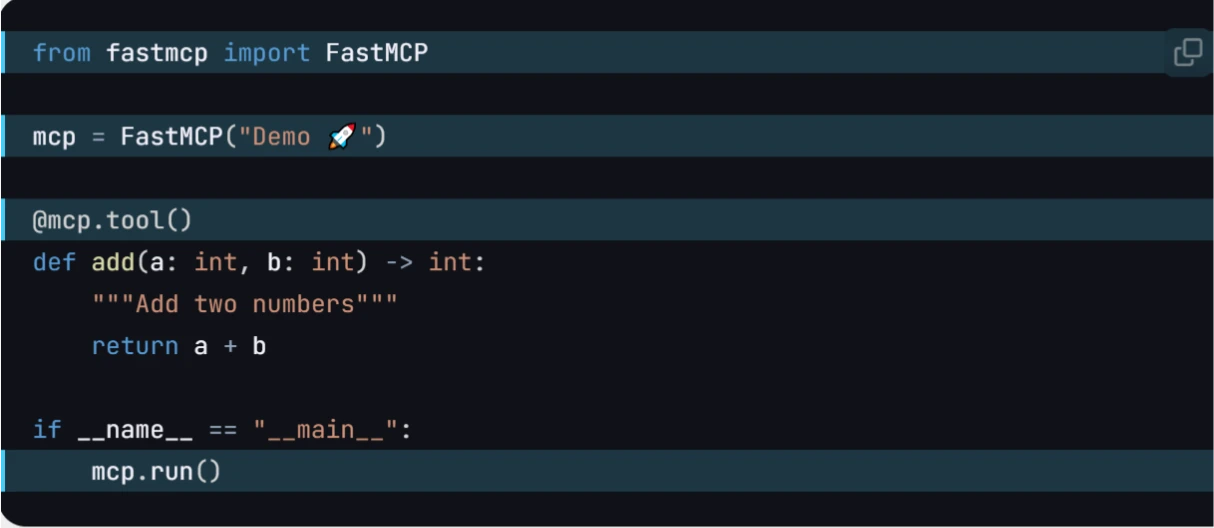

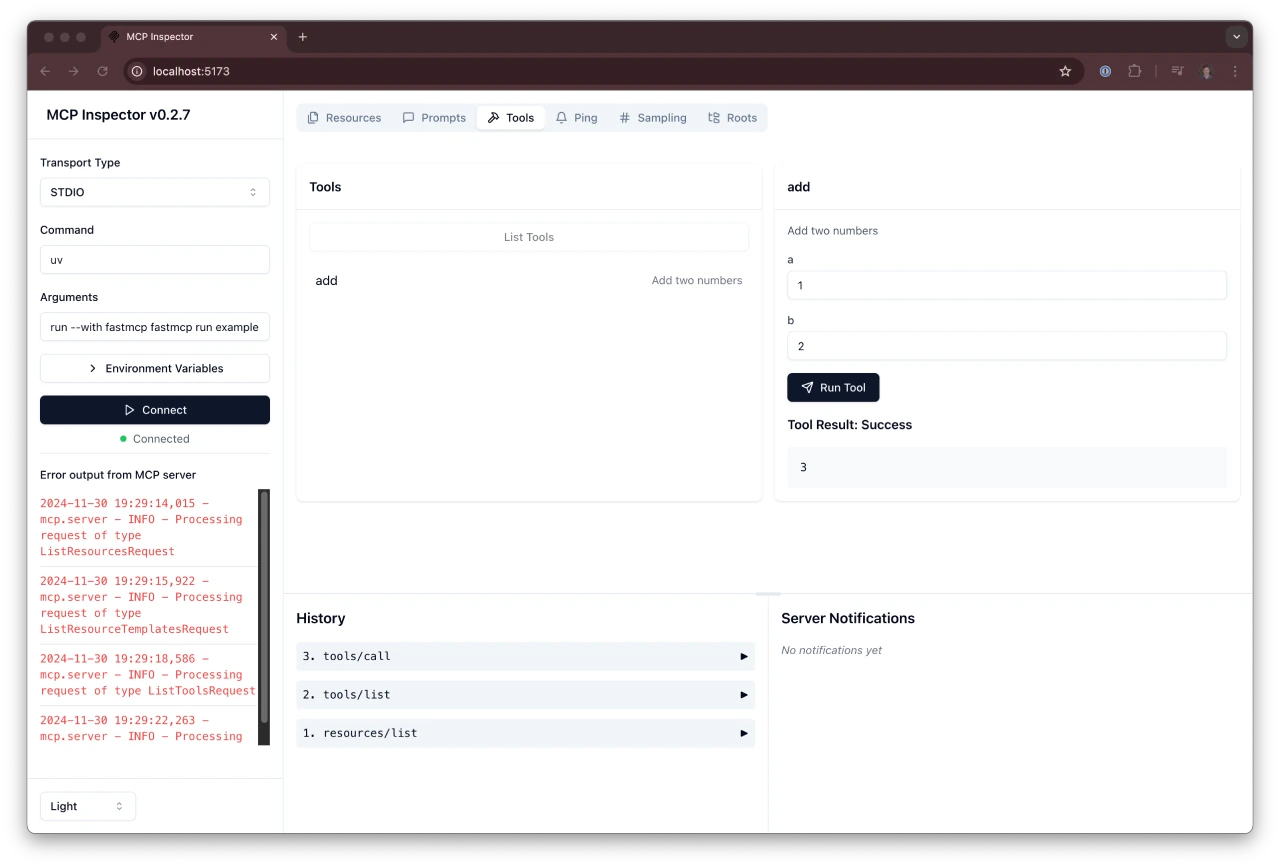

pipinstalluvicornpipinstallfastmcp2. 创建项目并编写服务器代码:

fromfastmcpimportFastMCPmcp=FastMCP("MyApp")@mcp.tool()defadd(a:int,b:int)->int:returna+bif__name__=="__main__":mcp.run(debug=True)3. 启动服务器:

uvicornserver:app--reload或使用 FastMCP 命令行工具:

fastmcprunserver.py

github:https://github.com/jlowin/fastmcp

详细:https://gofastmcp.com/getting-started/welcome

-

下一篇: 最后一页

- FastMCP:用于构建MCP服务器的开源Python框架

- 字节Trae v1.3.0更新了哪些功能?

- Langgraph-Mcp-Agents:一个集成MCP基于LangGraph的AI智能体系统

- HawkinsDB:一款基于人类大脑工作原理设计的AI记忆系统

- Awesome-Deepseek-Integration:DeepSeek实用集成工具箱

- WatermarkRemover-AI:一款开源的AI去水印工具

- PageIndex:一个开源PDF文档索引系统,可实现更精准、更逻辑化的检索

- Cooragent:一个开源的AI智能体协作社区,一句话即可创建智能体

- No-OCR:一款不需要OCR文本提取的文档处理工具

- 桃豆:爱奇艺发布的个人智能助手

-

Danswer学习资源汇总 - 开源Gen-AI聊天与统一搜索解决方案

2025-01-07

-

2025-01-16

-

Open Assistant API学习资料汇总 - 开源自托管的AI智能助手API框架

2025-01-27

-

2025-02-08

-

pot-desktop使用指南 - 跨平台划词翻译和OCR软件

2025-01-02

-

2025-01-13

-

2025-01-22

-

Ant Design X:蚂蚁开源的可以快速构建AI聊天界面的工具包

2025-02-01

-

LlamaGPT入门指南 - 自托管离线ChatGPT替代方案

2025-01-07

-

ChatGPT on WeChat: 打造你的智能微信机器人

2025-01-17