Mercury:首个商用级别扩散大型语言模型(dLLM)

Mercury是什么?

Mercury是由创业公司Inception Labs推出的首个商用级别扩散大型语言模型(dLLM)。在Copilot Arena基准测试中,Mercury Coder速度超过了包括GPT-4o Mini和Claude 3.5 Haiku等多个现有模型。 在实际应用中,Mercury Coder能够以极快的速度生成高质量的代码。

技术原理

扩散模型:Mercury采用扩散模型技术,与传统自回归模型不同,它通过“从粗到细”的生成过程,从纯噪声开始,通过多个去噪步骤逐步生成有意义的文本。

并行生成:利用GPU的并行生成机制,Mercury能够在生成文本时同时修改多个token,从而显著提高生成速度和效率。

创新点

速度优势:Mercury在NVIDIA H100上能以每秒超过1000 token的速度运行,比现有的经过速度优化的LLM快5到10倍。

成本效益:通过新的语言生成方法,Mercury将推理成本降低了10倍,同时保持了与前沿模型相当的性能。

纠错能力:扩散模型的特性使得Mercury能够在生成过程中不断改进输出,纠正错误和幻觉。

Mercury功能特征

扩散模型技术:Mercury采用扩散模型,通过“从粗到细”的生成过程,从纯噪声开始,逐步生成有意义的文本。

并行生成:利用GPU的并行生成机制,Mercury能够在生成文本时同时修改多个token,显著提高生成速度和效率。

速度优势:在NVIDIA H100上能以每秒超过1000 token的速度运行,比现有的经过速度优化的LLM快5到10倍。

成本效益:通过新的语言生成方法,Mercury将推理成本降低了10倍,同时保持了与前沿模型相当的性能。

纠错能力:扩散模型的特性使得Mercury能够在生成过程中不断改进输出,纠正错误和幻觉。

Mercury应用

编程与代码生成:Mercury Coder专门为代码生成进行了优化,在标准编码基准测试中表现优异,速度比传统模型快10倍以上。

Agent应用:Mercury的高速度和效率使其在需要大量规划和长篇生成的应用中表现出色,如智能客服、代码助手等。

边缘应用:由于其高效性,Mercury在资源受限的环境中也能表现出色,如手机或笔记本电脑上的应用。

高级推理:Mercury可以利用错误修正来修复幻觉并提升回答质量,适用于需要深度推理的任务。

可控生成:Mercury可以编辑输出内容,按任意顺序生成词,适用于需要灵活生成内容的场景。

Mercury如何使用?

安装与配置:Mercury Coder已上线,可公开试用。用户可以通过Inception Labs提供的playground体验其功能,或通过API和内部部署服务进行企业级应用。

体验与测试:用户可以在Inception Labs的官方网站上体验Mercury Coder的强大能力,输入代码需求,即时生成高质量的代码。

在线体验:https://chat.inceptionlabs.ai/

官方介绍:https://www.inceptionlabs.ai/news

-

下一篇: 最后一页

- Mercury:首个商用级别扩散大型语言模型(dLLM)

- BiliBili ShadowReplay:哔哩哔哩直播切片和投稿工具

- AI-Infra-Guard:腾讯开源的一个AI基础设施安全评估工具,可一键检测AI系统的潜在安全风险

- Migician:清华大学等团队出的解决复杂场景下的多图像目标定位问题的多模态模型

- Mp-Vx-insight:一键获取微信公众号文章的封面图、采集文章内容

- DeepSeek开源周第六天开源项目:DeepSeek-V3/R1推理系统,成本利润率高达545%

- CSM:Sesame公司的语音合成模型,如同与真人交流

- Leffa:Meta AI开源的用于可控人物图像生成的工具,适用于虚拟试穿。

- Probly:与Python数据分析能力相结合的AI电子表格应用程序

- WhisperChain:实时语音转录工具,可把口语化的表达变得更正式

-

tortoise-tts学习资料汇总 - 高质量多声音TTS系统

2024-12-31

-

-

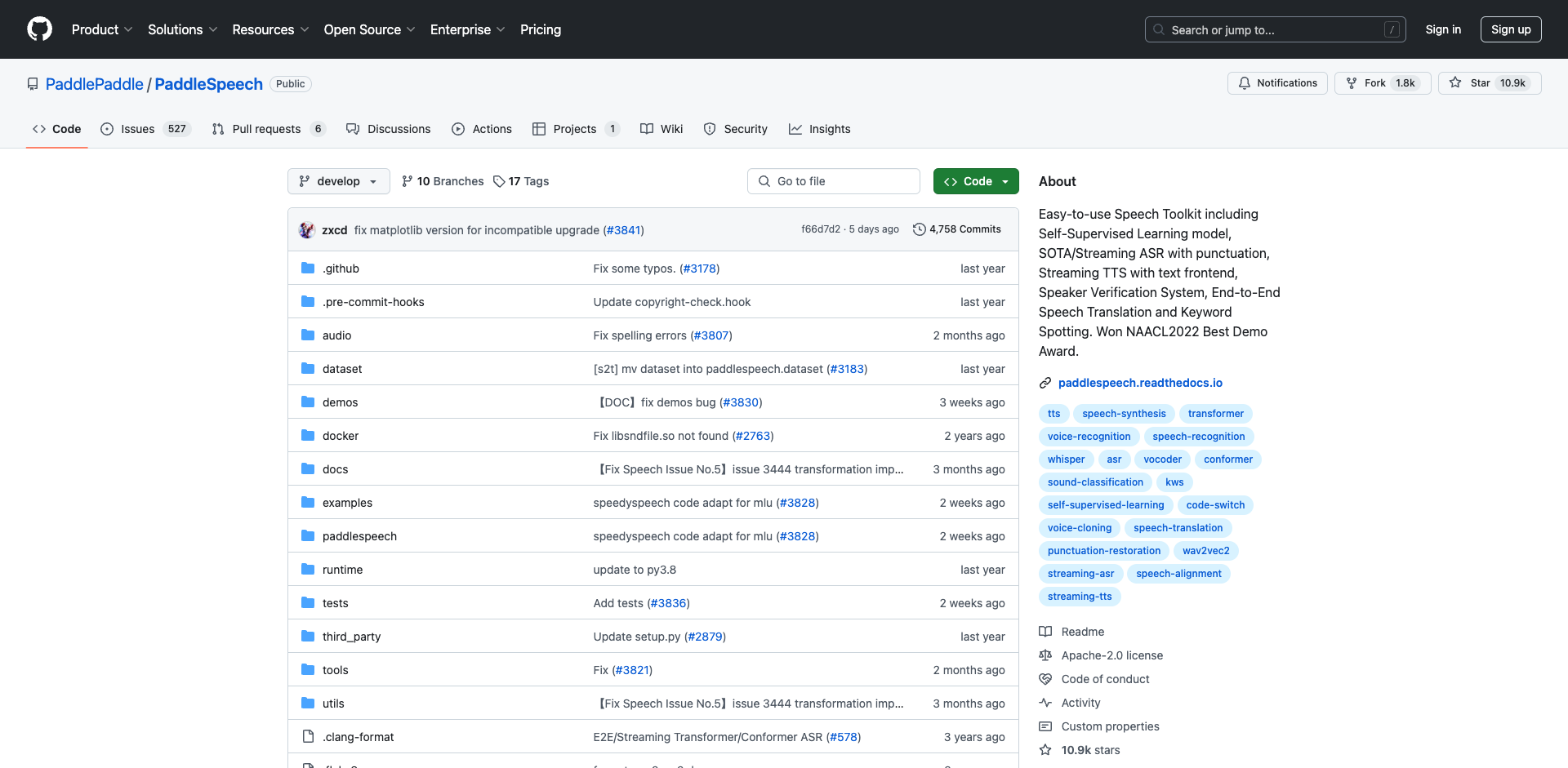

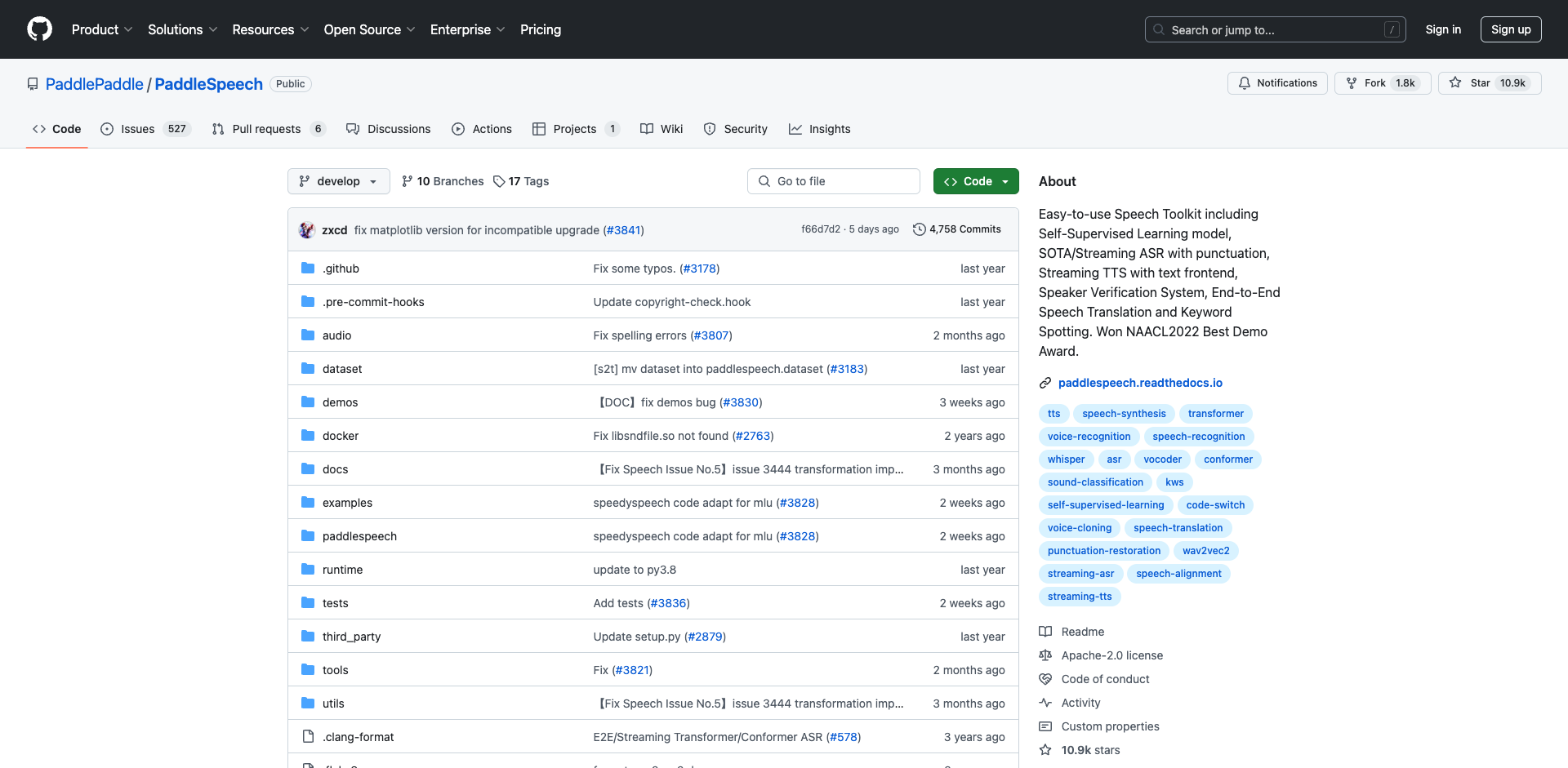

PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

2025-01-02

-

pot-desktop使用指南 - 跨平台划词翻译和OCR软件

2025-01-02

-

understand-prompt学习资料汇总 - AI助手的探索与应用

2025-01-02

-

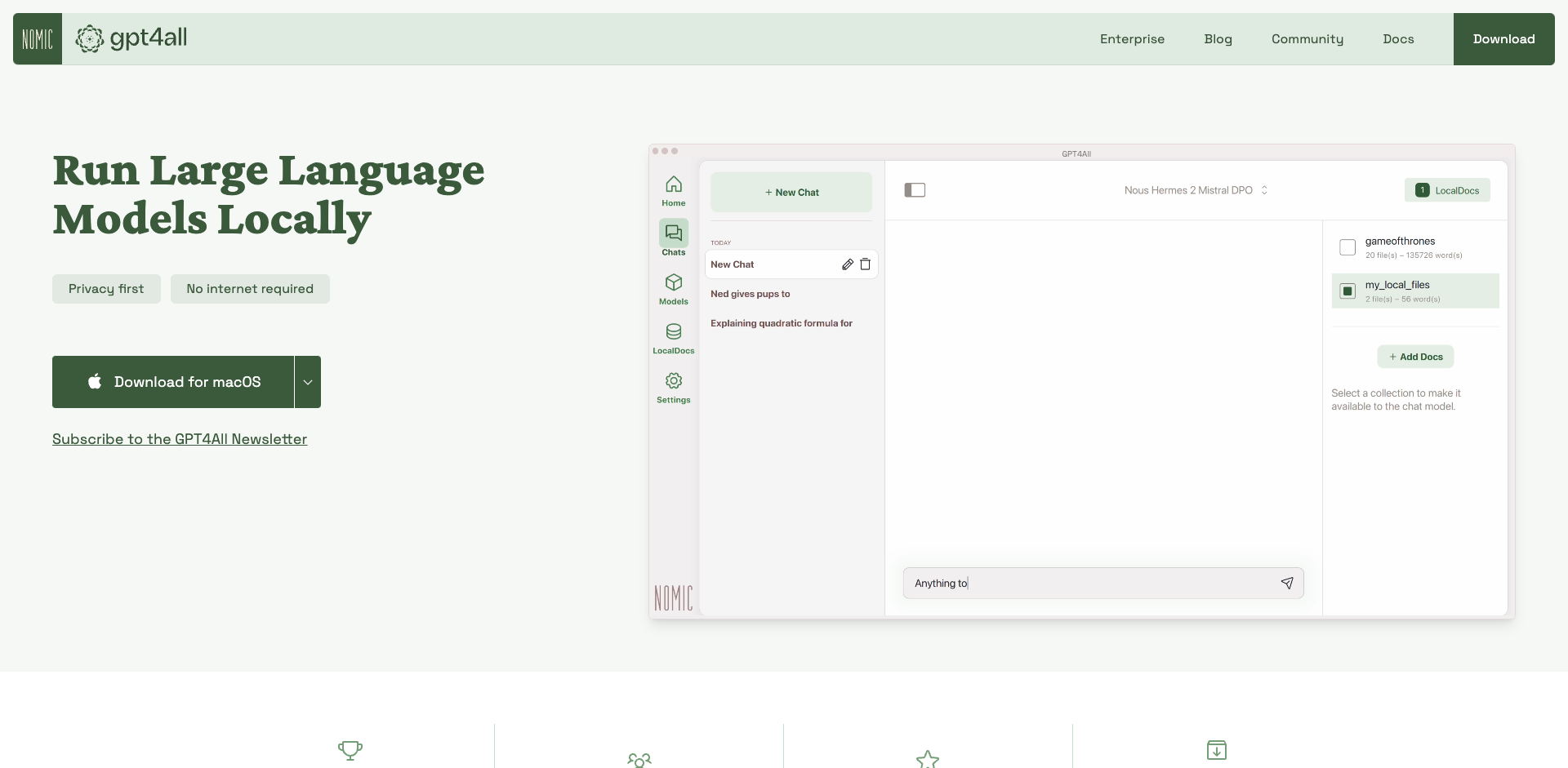

GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

2025-01-02

-

2025-01-02

-

wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

2025-01-02

-

Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

2025-01-02

-

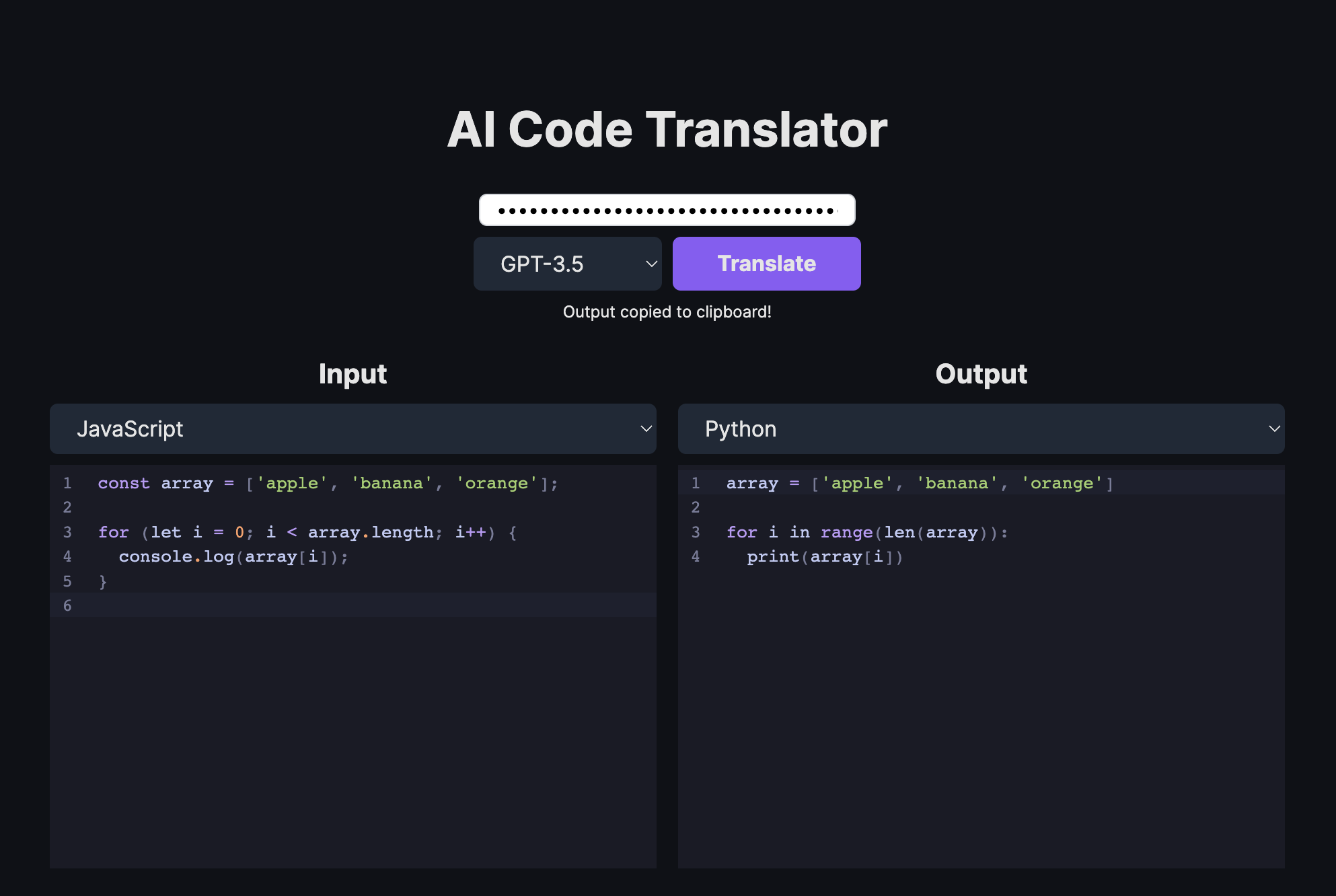

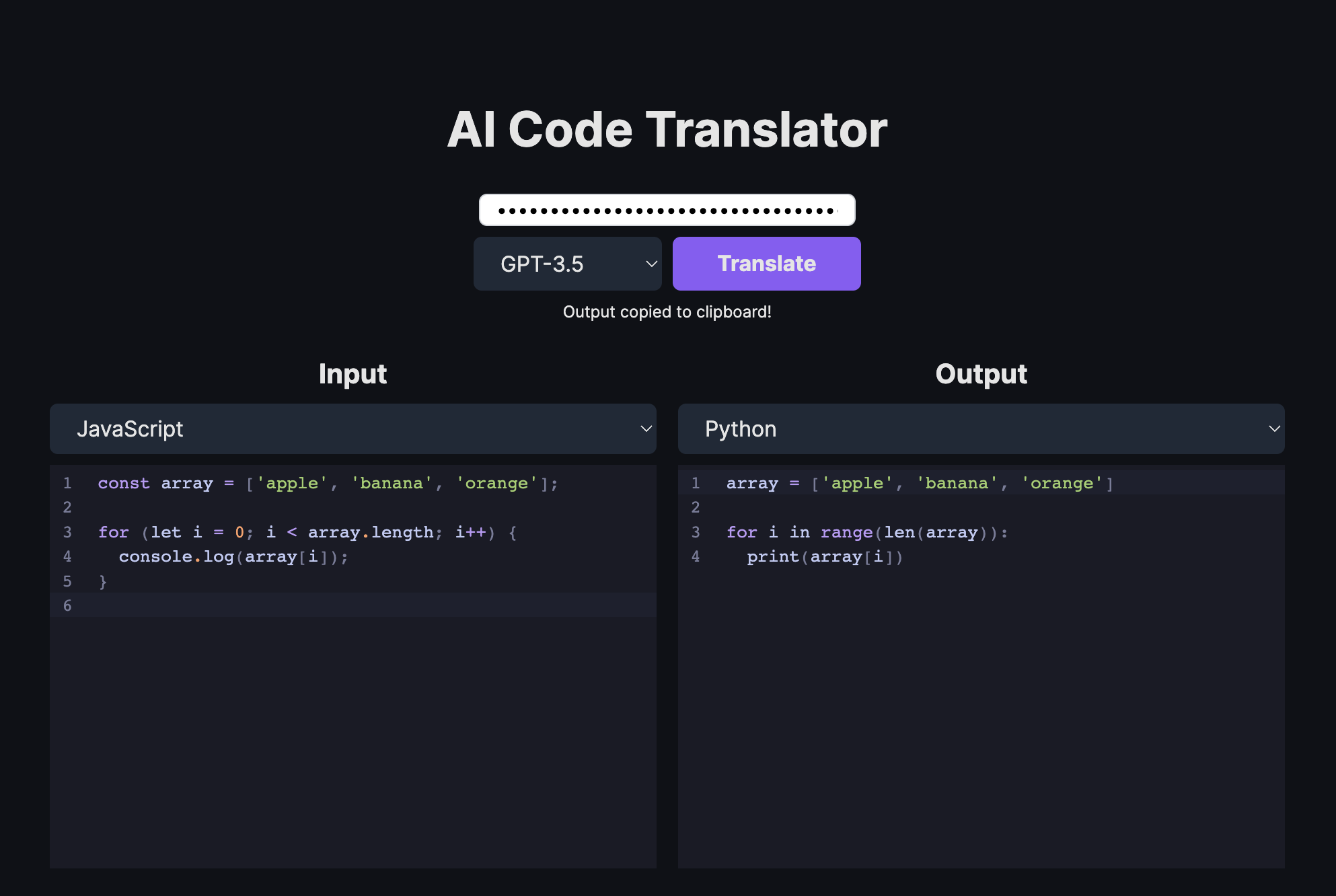

AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言

2025-01-02

-

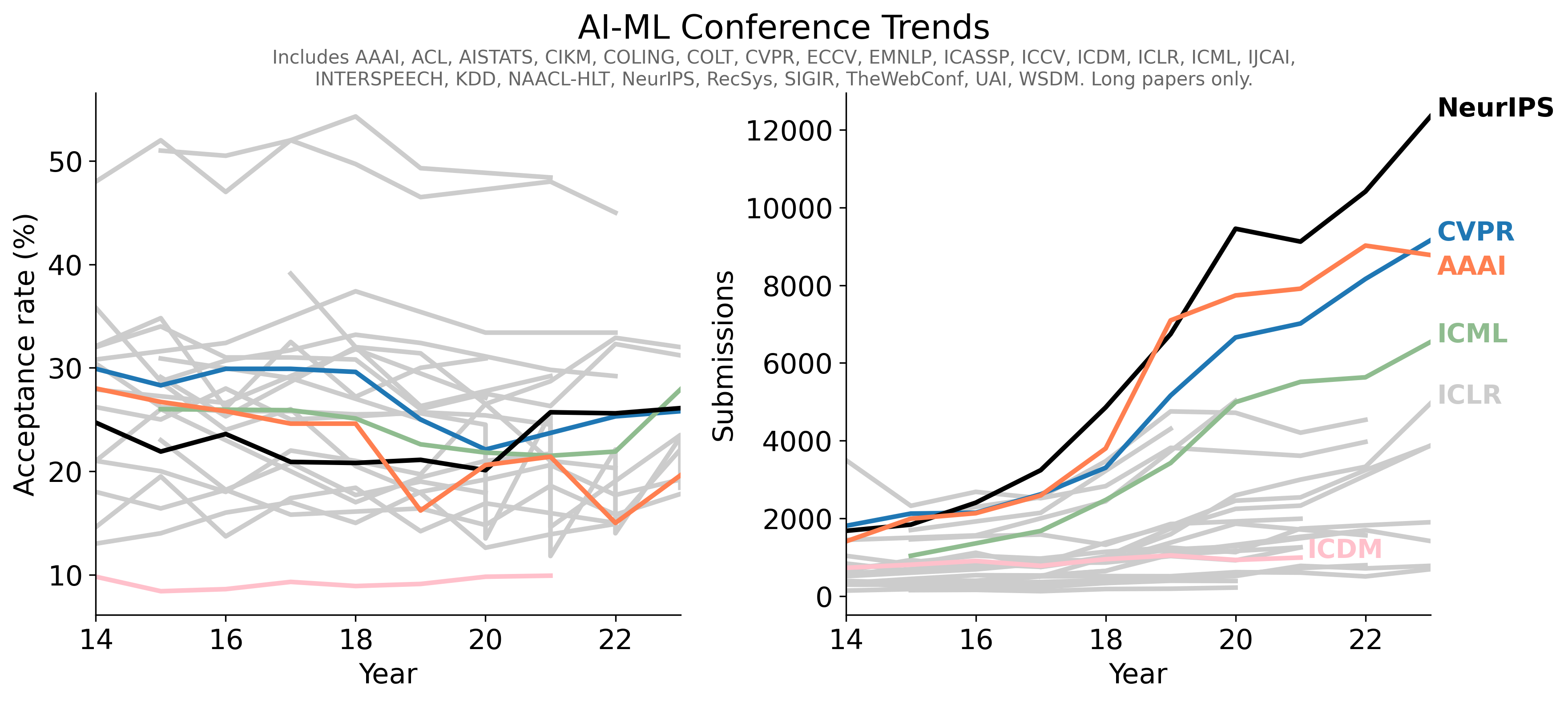

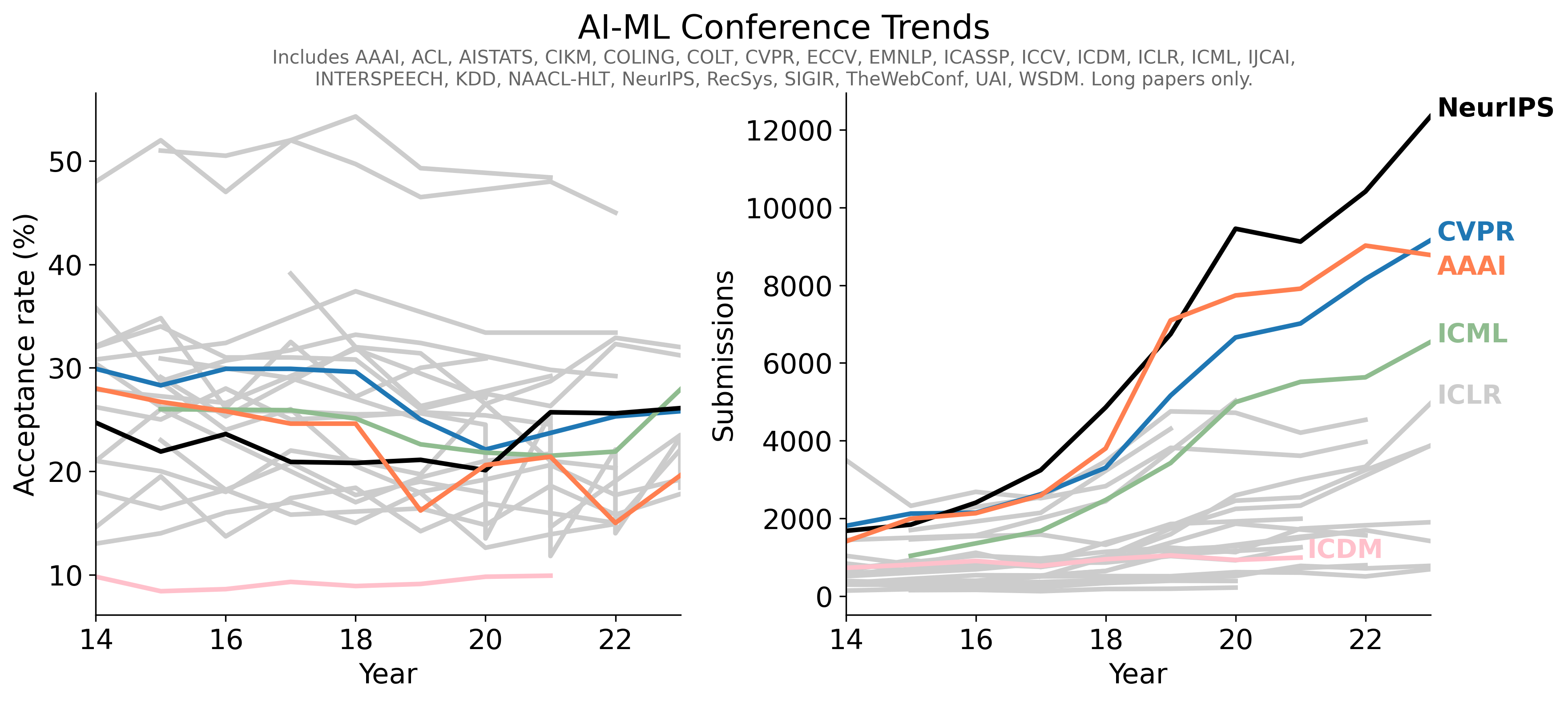

- 1Conference-Acceptance-Rate项目学习指南 - 人工智能顶级会议录用率数据汇总

- 2PaddleSpeech入门学习资料汇总 - 开源语音AI工具包

- 3pot-desktop使用指南 - 跨平台划词翻译和OCR软件

- 4understand-prompt学习资料汇总 - AI助手的探索与应用

- 5GPT4All学习资源汇总 - 在本地设备上运行大型语言模型

- 6law-cn-ai 入门指南 - AI 驱动的中国法律助手

- 7wechat-bot入门指南 - 基于ChatGPT的微信聊天机器人

- 8Cheetah - AI助手学习资料汇总 - Mac应用助力远程技术面试

- 9AI代码翻译器学习资料汇总 - 使用AI将代码从一种语言翻译成另一种语言