Qwen2.5-Omni:阿里巴巴发布的端到端全能多模态旗舰模型

Qwen2.5-Omni是什么?

Qwen2.5-Omni 是阿里巴巴发布的Qwen 系列中的新一代端到端多模态旗舰模型。它专为全方位多模态感知设计,也就是可以理解文本、音频、图像、视频,可以同时进行思考和说话,并通过实时流式响应同时生成文本与自然语音合成输出的一个ai模型。

Qwen2.5-Omni核心特点

创新架构:

Thinker-Talker 架构:Thinker 负责处理和理解来自文本、音频和视频模态的输入,生成高级语义表征和对应的文本内容;Talker 则将这些内容转化为自然语音输出。

TMRoPE 技术:提出了一种名为 TMRoPE(Time-aligned Multimodal RoPE)的新型位置编码技术,用于同步视频输入与音频的时间戳。

实时交互:

支持完全实时交互,能够处理分块输入并即时输出。

自然流畅的语音生成:

在语音生成的自然性和稳定性方面超越了许多现有的流式和非流式替代方案。

全模态性能优势:

在多模态任务(如 OmniBench)中表现出色,同时在单模态任务(如语音识别、翻译、音频理解、图像推理、视频理解等)中也表现出色。

端到端语音指令跟随能力:

在端到端语音指令跟随方面表现出与文本输入处理相媲美的效果,在 MMLU 和 GSM8K 等基准测试中表现优异。

Qwen2.5-Omni架构设计

Thinker:类似于大脑,负责处理和理解来自文本、音频和视频模态的输入,生成高级语义表征和对应的文本内容。

Talker:类似于人类的嘴巴,接收 Thinker 生成的高级语义表征和文本内容,并以流式方式输出自然语音。

整体架构:Thinker 是一个 Transformer 解码器,配备用于音频和图像的编码器以提取信息。Talker 是一个双轨自回归 Transformer 解码器架构。在训练和推理过程中,Talker 直接接收来自 Thinker 的高维表征,并共享 Thinker 的所有历史上下文信息,整个架构作为一个统一的模型进行端到端训练和推理。

Qwen2.5-Omni性能表现

在多模态任务(如 OmniBench)中,Qwen2.5-Omni 实现了最先进的性能。

在单模态任务中,它在语音识别(Common Voice)、翻译(CoVoST2)、音频理解(MMAU)、图像推理(MMMU、MMStar)、视频理解(MVBench)和语音生成(Seed-tts-eval 和主观自然性)等方面表现出色。

相关链接

Qwen Chat:https://chat.qwenlm.ai

Hugging Face:https://huggingface.co/Qwen/Qwen2.5-Omni-7B

ModelScope:https://modelscope.cn/models/Qwen/Qwen2.5-Omni-7B

DashScope:https://help.aliyun.com/zh/model-studio/user-guide/qwen-omni

GitHub:https://github.com/QwenLM/Qwen2.5-Omni

Demo体验:https://modelscope.cn/studios/Qwen/Qwen2.5-Omni-Demo

-

下一篇: 最后一页

- Qwen2.5-Omni:阿里巴巴发布的端到端全能多模态旗舰模型

- Bonito入门指南 - 无需GPT即可生成指令调优数据集的轻量级库

- Mureka O1:昆仑万维发布的全球首款音乐推理大模型

- playwright-mcp:能够使大语言模型直接操控浏览器完成复杂任务

- 如何用OpenAI的GPT-4o来制作属于自己的表情包教程

- QVQ-Max:阿里推出的视觉推理模型,能够理解图片和视频中的内容

- Paper-to-Podcast:将学术论文转换为AI播客的开源工具

- ideogram v3发布,看看有哪些新功能或改进。

- Pika新功能 :与小时候的自己合影拍视频教程指南

- ChatAnyone:阿里发布的通过音频输入生成具有丰富表情和上半身动作的肖像视频

-

2025-02-24

-

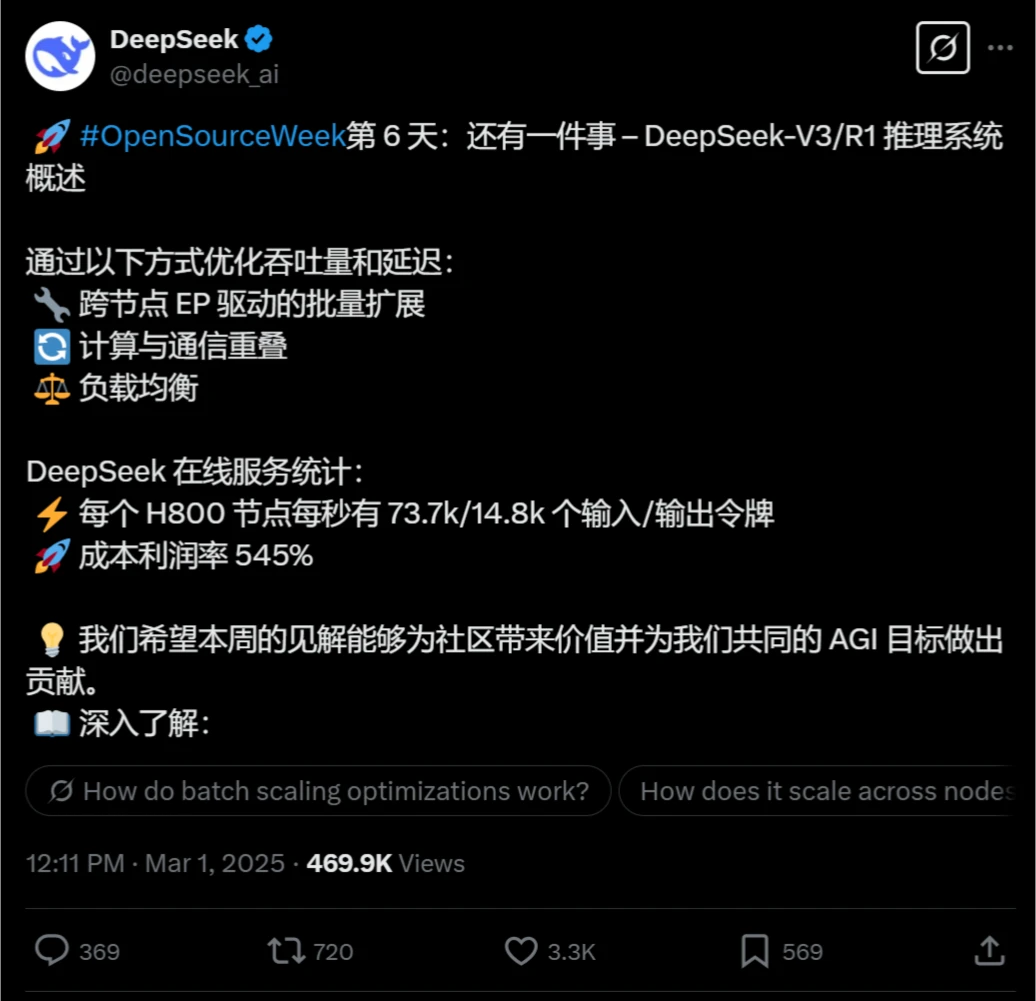

NSA:DeepSeek团队推出的加速超长上下文的训练和推理技术

2025-03-18

-

ChatGPT Canvas大更新来了,可提升写作和编程的效率!

2025-04-04

-

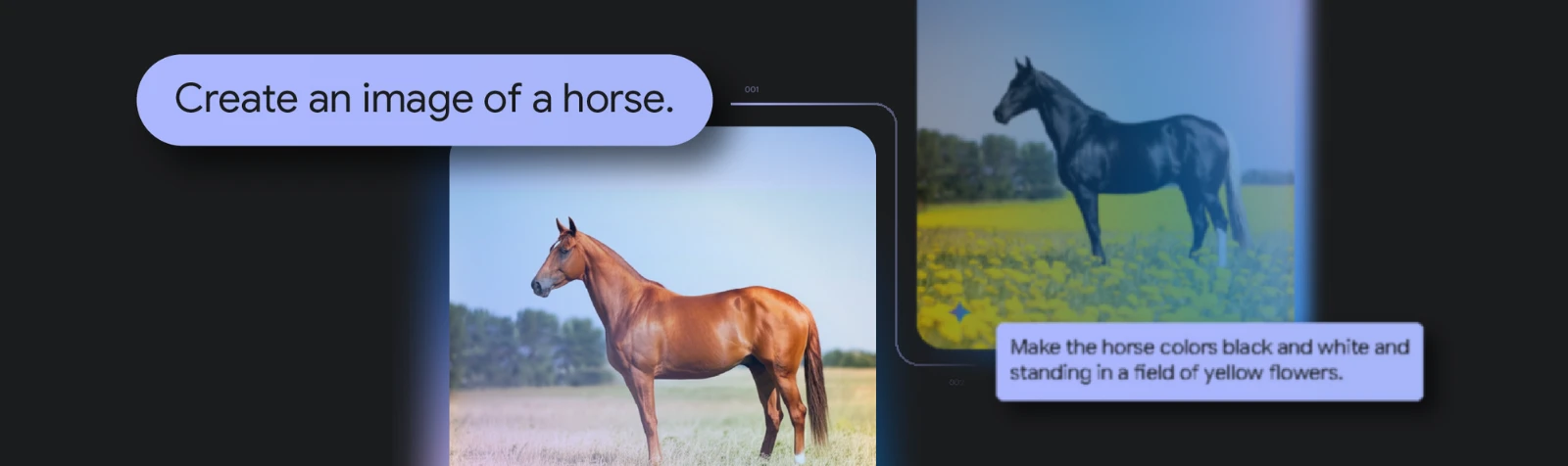

Gemini 2.0 Flash Experimental的功能特征及使用方法

2025-04-20

-

-

2025-03-28

-

Coze、Dify 和 FastGPT 对比哪个好、如何选择?

2025-04-14

-

2025-02-24

-

2025-03-18

-

2025-04-05