NOTUS: 推动语言模型对齐的开源项目

NOTUS: 开源推动语言模型对齐的先锋

在人工智能快速发展的今天,如何让大型语言模型(LLM)能够更好地理解和执行人类指令,成为了一个重要的研究方向。由Argilla公司发起的NOTUS项目,正是为解决这一挑战而生。NOTUS通过创新的微调技术和数据驱动的方法,致力于提高语言模型的能力和可靠性,推动AI向着更加智能和可控的方向发展。

NOTUS项目概览

NOTUS是一个开源项目,其名称源自古希腊神话中的南风之神诺托斯(Notus)。这个命名也暗示了NOTUS项目与Zephyr项目(西风之神)的关联和区别。NOTUS的核心目标是通过各种先进的微调技术,如监督微调(SFT)、直接偏好优化(DPO)等,来改进大型语言模型的性能和行为。

NOTUS项目的独特之处在于其"数据优先"的方法论。在Argilla公司丰富的数据处理经验基础上,NOTUS特别注重高质量训练数据的收集和处理。这种方法不仅提高了模型的性能,还确保了模型行为的可控性和一致性。

NOTUS的技术创新

NOTUS项目采用了多种先进的模型微调技术:

监督微调(SFT): 通过大量高质量的人类标注数据,指导模型学习特定任务和领域的知识。

直接偏好优化(DPO): 这是一种新兴的强化学习技术,通过直接学习人类偏好来优化模型输出。

SFT+DPO组合: 结合监督学习和强化学习的优势,进一步提升模型性能。

其他RLHF(基于人类反馈的强化学习)技术: NOTUS项目还在探索和应用其他先进的对齐技术。

这些技术的组合应用,使NOTUS能够在保持模型基础能力的同时,更好地对齐人类价值观和偏好。

NOTUS的实际应用

NOTUS项目的成果主要体现在以下几个方面:

对话型应用: NOTUS模型经过优化,特别适合用于聊天机器人等对话场景。

学术评估: 项目团队使用MT-Bench、AlpacaEval等权威基准来评估模型性能,确保模型在各种任务上的表现。

开放资源: NOTUS项目在HuggingFace平台上提供了模型和数据集,方便研究者和开发者使用和进一步探索。

NOTUS的最新进展

NOTUS项目一直在持续更新和改进。2023年12月1日,项目团队发布了NOTUS 7B v1模型。这个版本在DPO微调过程中采用了创新的数据处理方法,通过对UltraFeedback数据集的不同评价标准进行平均,而不是仅依赖单一的评分指标。这种方法使NOTUS 7B在AlpacaEval和LM Eval Harness等基准测试中的表现超越了Zephyr 7B Beta,同时在MT-Bench上保持了相当的水平。

NOTUS的开源精神

NOTUS项目深深植根于开源社区,其成功离不开社区的支持和贡献。项目团队特别感谢HuggingFace H4团队的alignment-handbook项目,这为NOTUS的发展提供了宝贵的基础和灵感。

NOTUS项目不仅分享了模型和数据,还开放了详细的技术文档和研究成果。这种开放态度不仅有利于项目自身的发展,也为整个AI社区的进步做出了贡献。研究者和开发者可以基于NOTUS的成果进行进一步的探索和创新,推动语言模型对齐技术的整体进步。

NOTUS的未来展望

随着人工智能技术的不断发展,语言模型的对齐问题将继续是一个重要的研究方向。NOTUS项目团队计划在以下几个方面继续努力:

数据质量提升: 进一步完善数据收集和处理方法,提高训练数据的质量和多样性。

技术创新: 探索更多先进的微调和对齐技术,如多任务学习、元学习等。

跨语言和跨文化对齐: 研究如何使模型更好地适应不同语言和文化背景。

伦理和安全: 加强对模型行为的控制,确保其输出符合伦理标准和安全要求。

社区合作: 加强与学术界和工业界的合作,共同推动语言模型对齐技术的发展。

结语

NOTUS项目代表了当前语言模型对齐研究的前沿。通过创新的技术方法和开放的合作态度,NOTUS正在为构建更智能、更可靠的AI系统做出重要贡献。随着项目的不断发展,我们有理由期待NOTUS能够为未来的AI应用带来更多突破性的进展,推动人工智能向着更加智能和负责任的方向发展。

对于有兴趣深入了解或参与NOTUS项目的研究者和开发者,可以访问项目的GitHub仓库获取更多信息。同时,NOTUS项目也欢迎社区成员的贡献和反馈,共同推动语言模型对齐技术的进步。

-

上一篇: duix.ai: 革新性的AI开发平台

-

下一篇: 最后一页

-

2025-05-02

-

2025-05-01

-

stdlib: JavaScript 和 Node.js 的标准库

2025-05-02

-

2025-05-01

-

字节跳动的SeedEdit 和谷歌的Gemini 2.0 Flash对比,哪个更强

2025-05-03

-

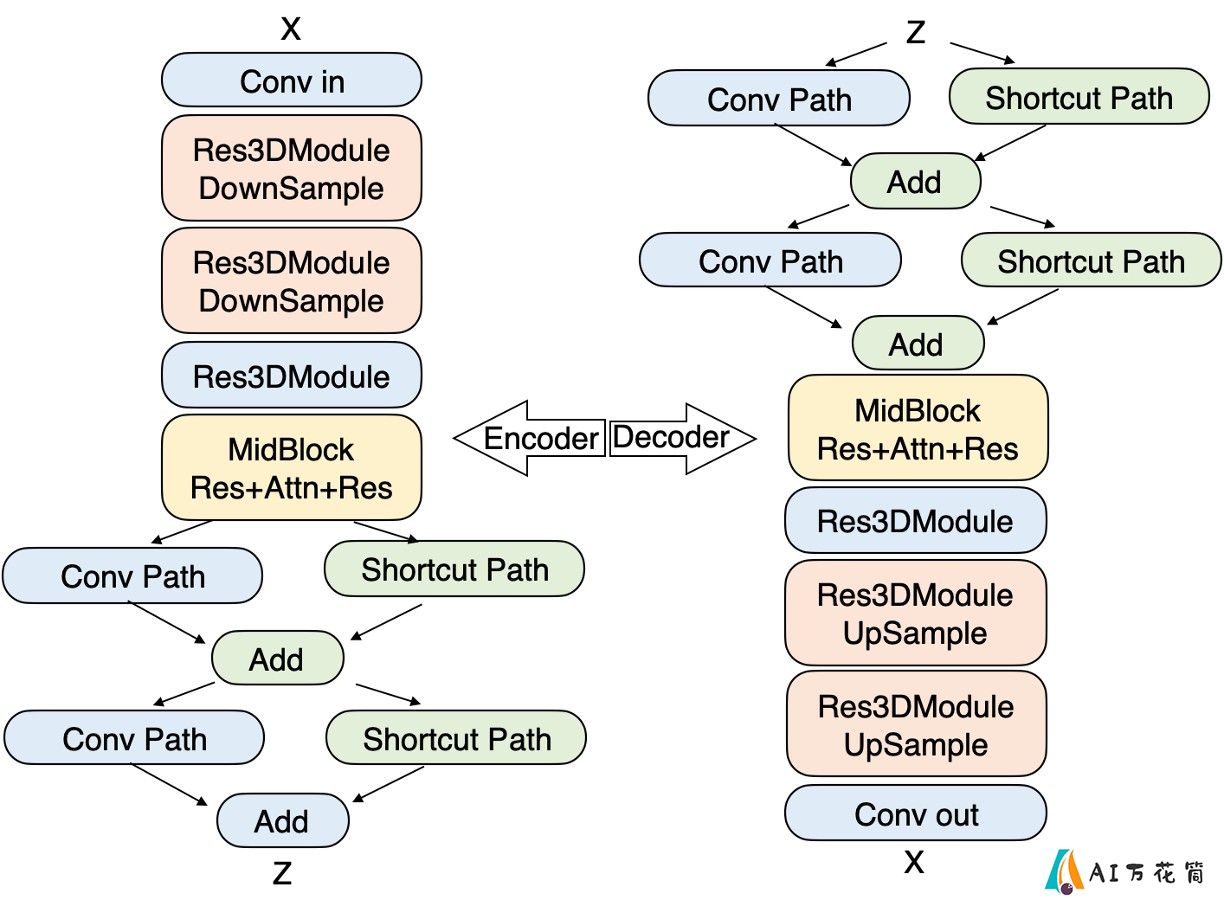

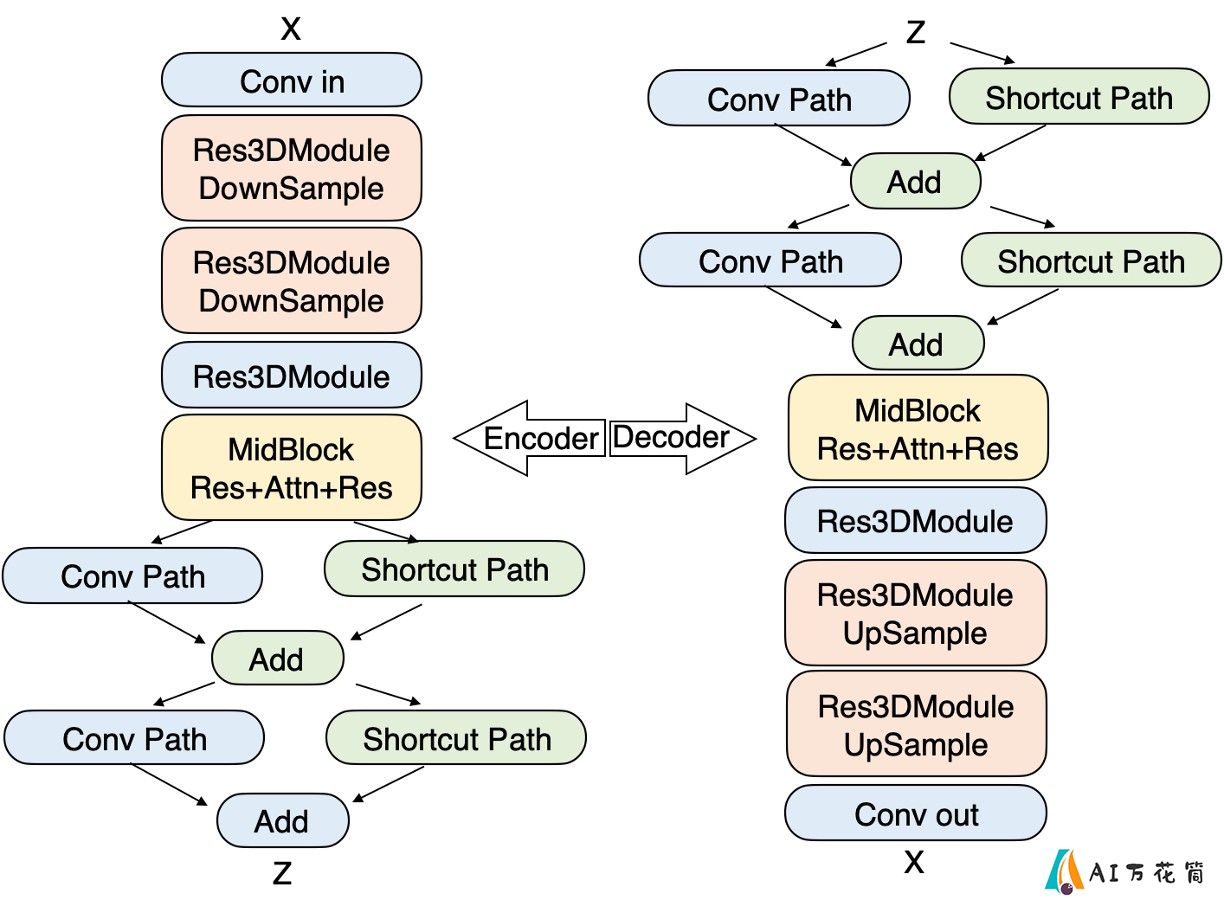

Step-Video-TI2V:阶跃星辰开源的一款AI文生视频和图生视频模型

2025-05-01

-

2025-05-03

-

2025-05-01

-

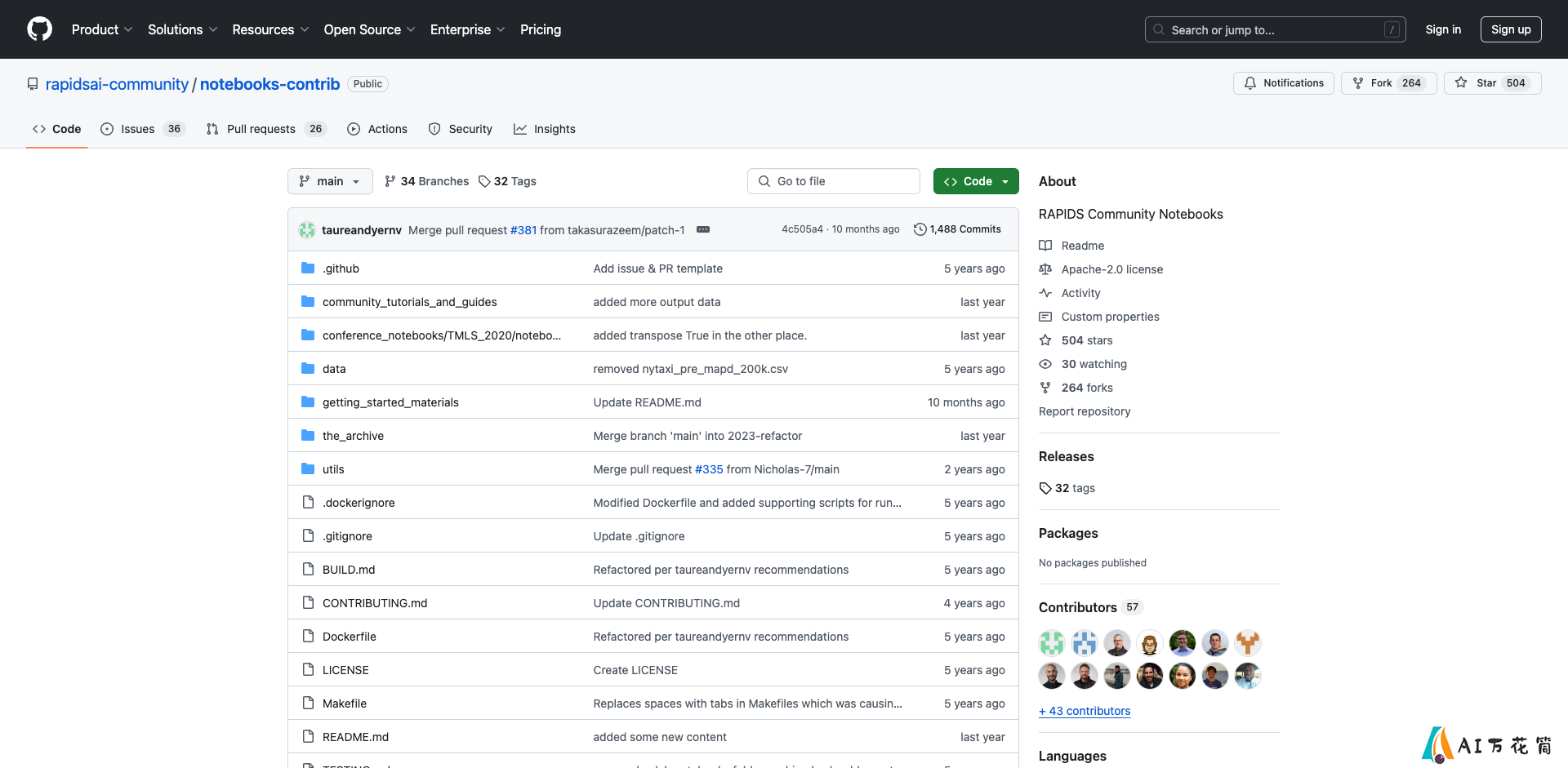

RAPIDS Community Notebooks: 加速数据科学工作流的开源工具集

2025-05-03

-

Stable Virtual Camera:使用一张图片,可以生成360度旋转的3D视频

2025-05-02

-

- 1Ballerine:开源风险管理基础设施简介

- 2stdlib: JavaScript 和 Node.js 的标准库

- 3iOS 18: 苹果移动操作系统的革命性升级

- 4字节跳动的SeedEdit 和谷歌的Gemini 2.0 Flash对比,哪个更强

- 5Step-Video-TI2V:阶跃星辰开源的一款AI文生视频和图生视频模型

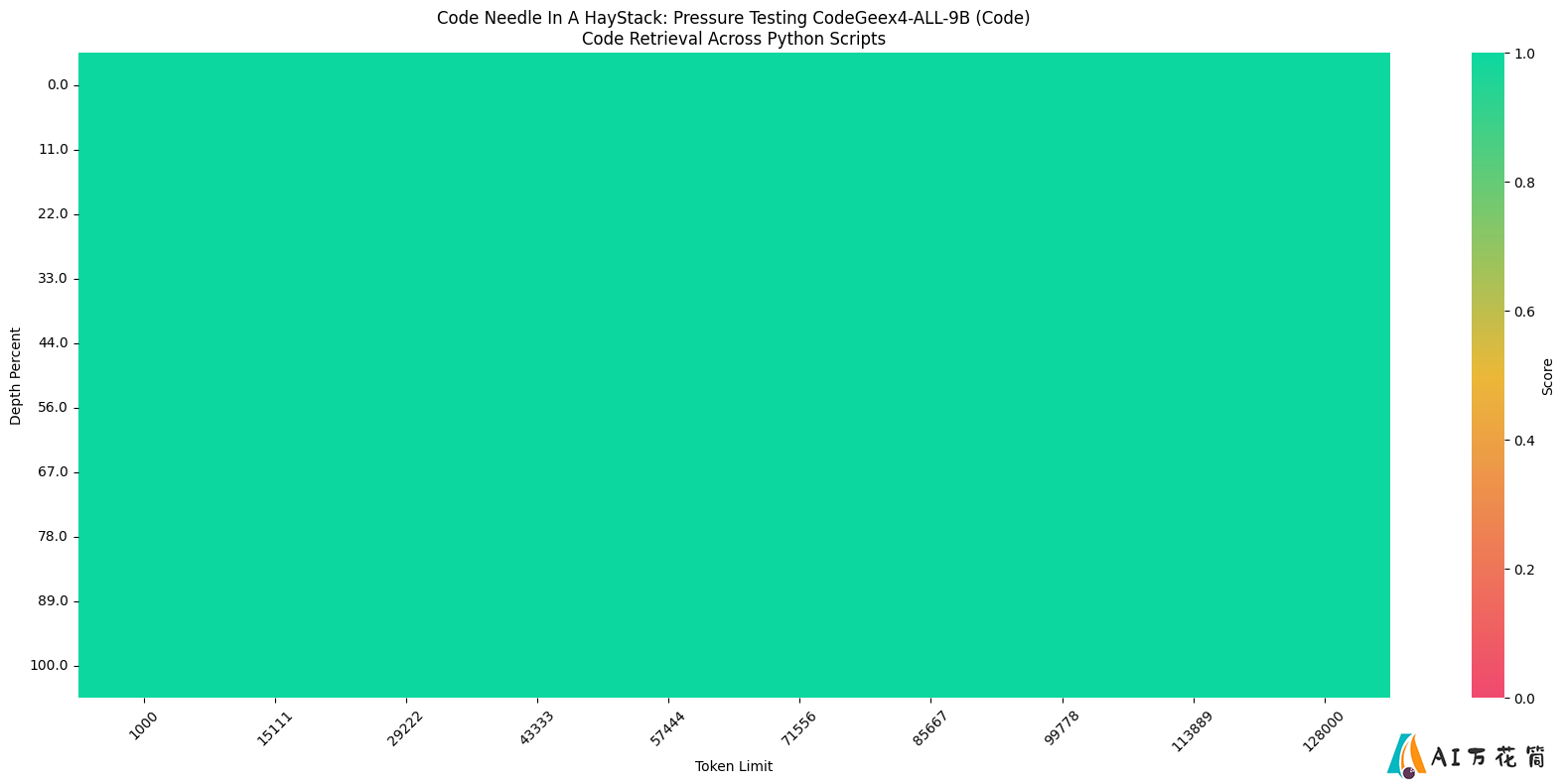

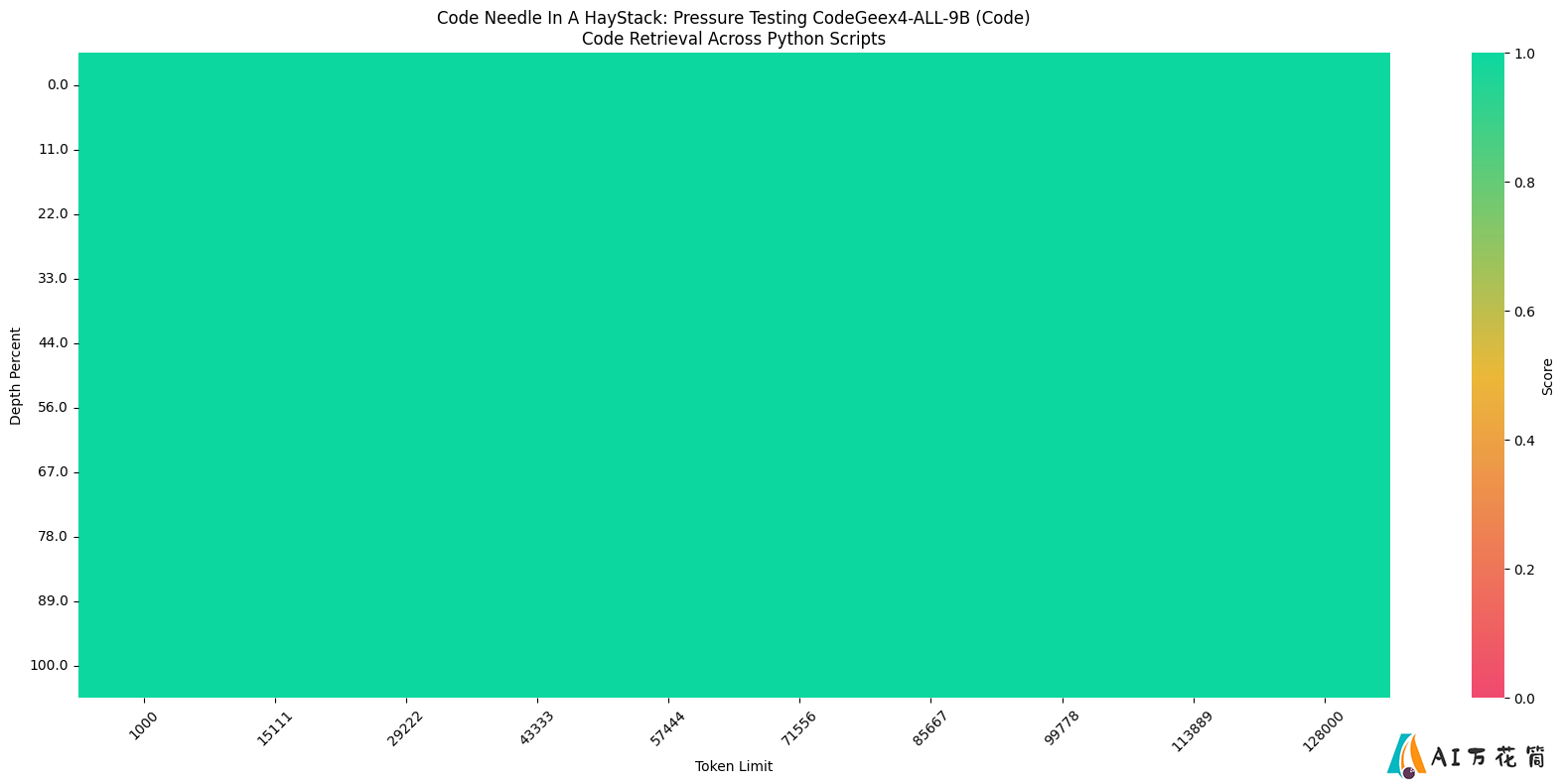

- 6CodeGeeX4: 开源多语言代码生成模型的新突破

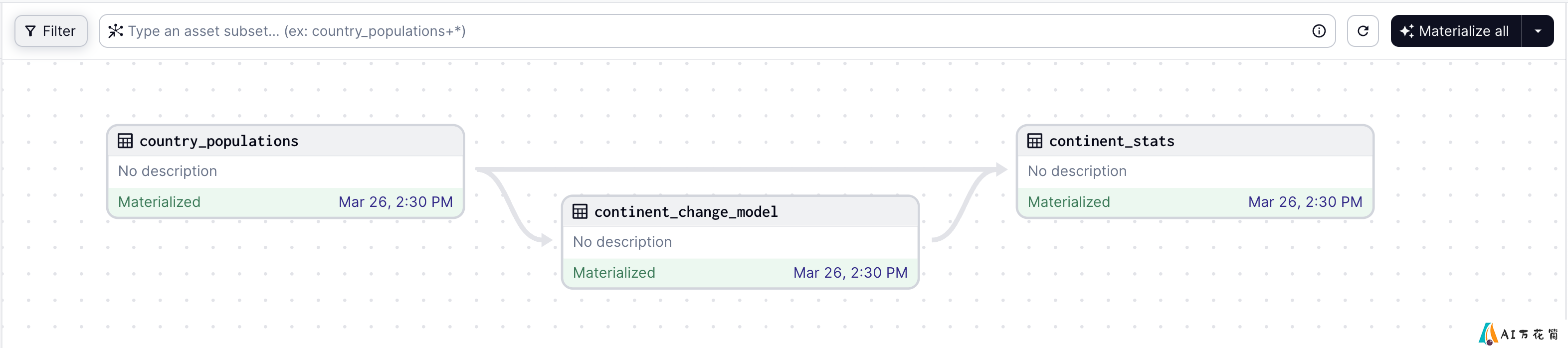

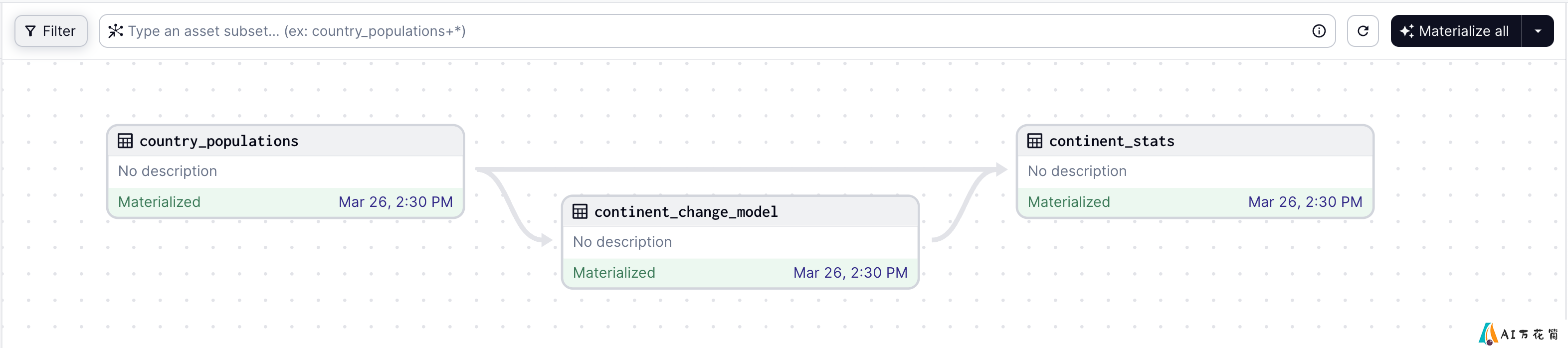

- 7Dagster: 现代数据工程的全生命周期数据资产编排平台

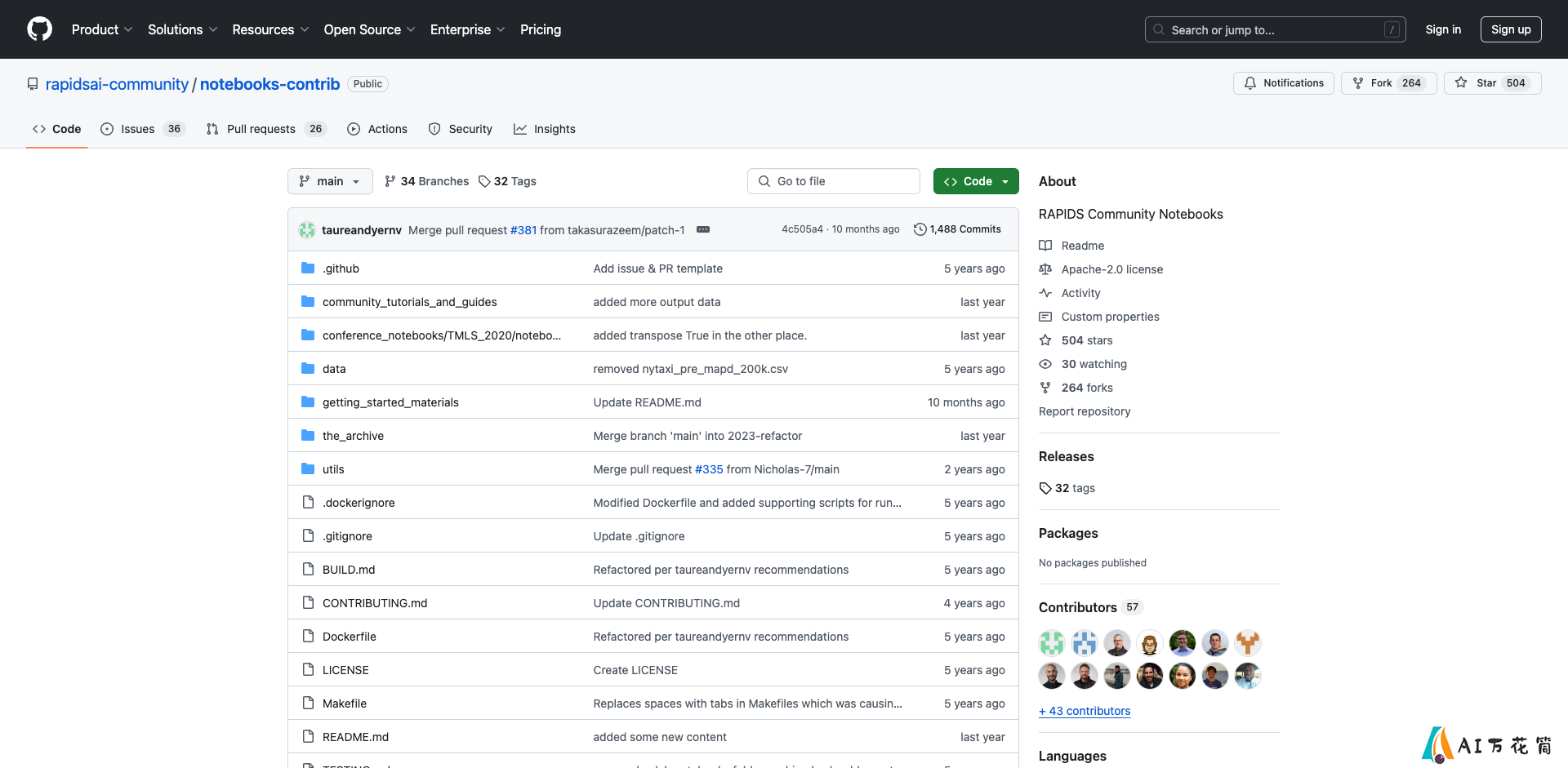

- 8RAPIDS Community Notebooks: 加速数据科学工作流的开源工具集

- 9Stable Virtual Camera:使用一张图片,可以生成360度旋转的3D视频